如何理解统计学习理论、优化与神经网络?伯克利Spencer Frei最新演讲报告,附58页ppt与视频

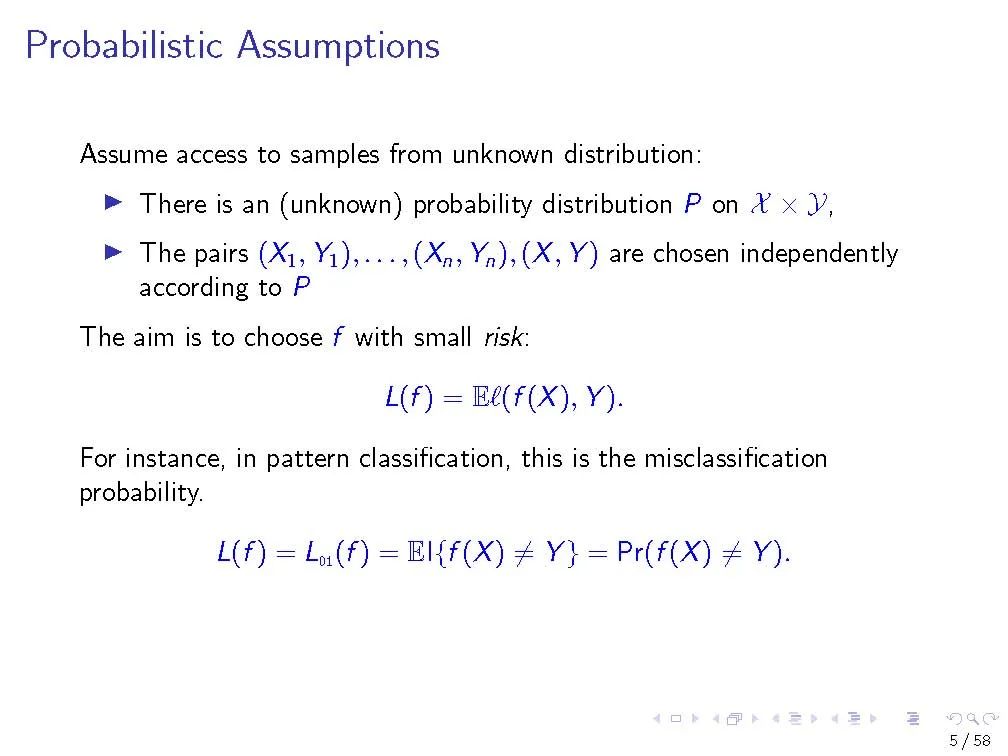

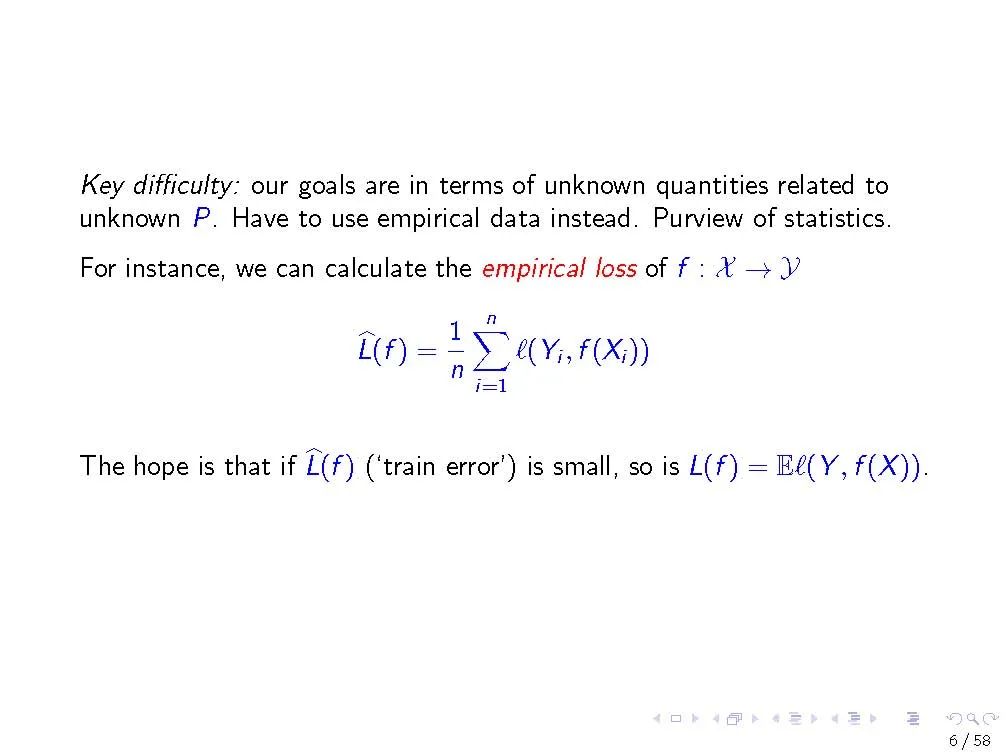

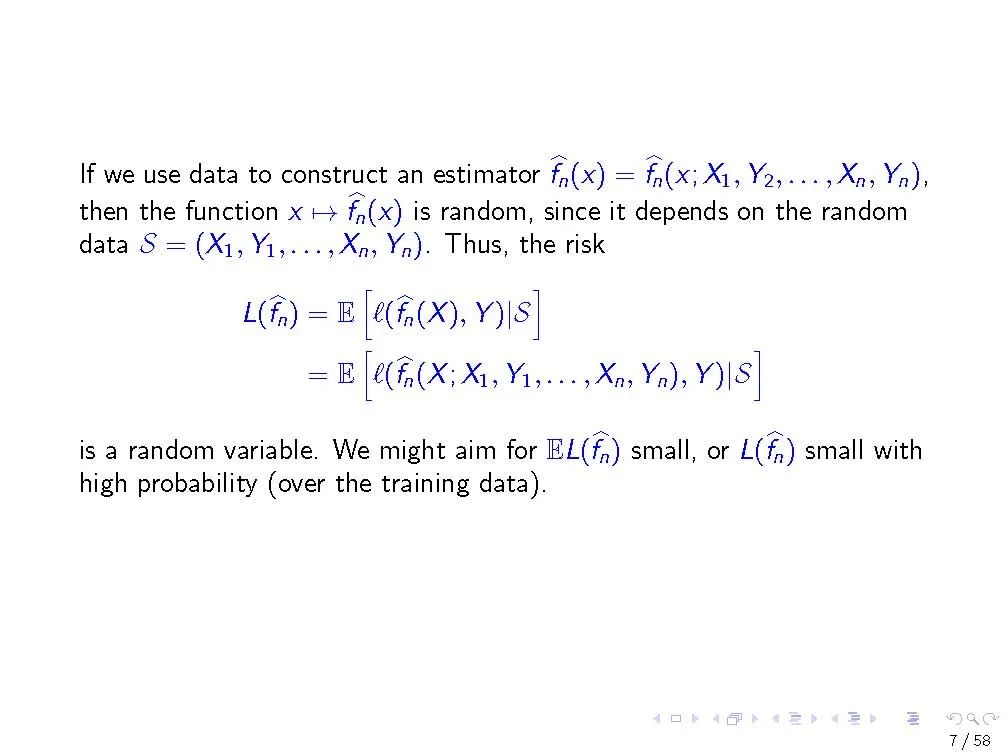

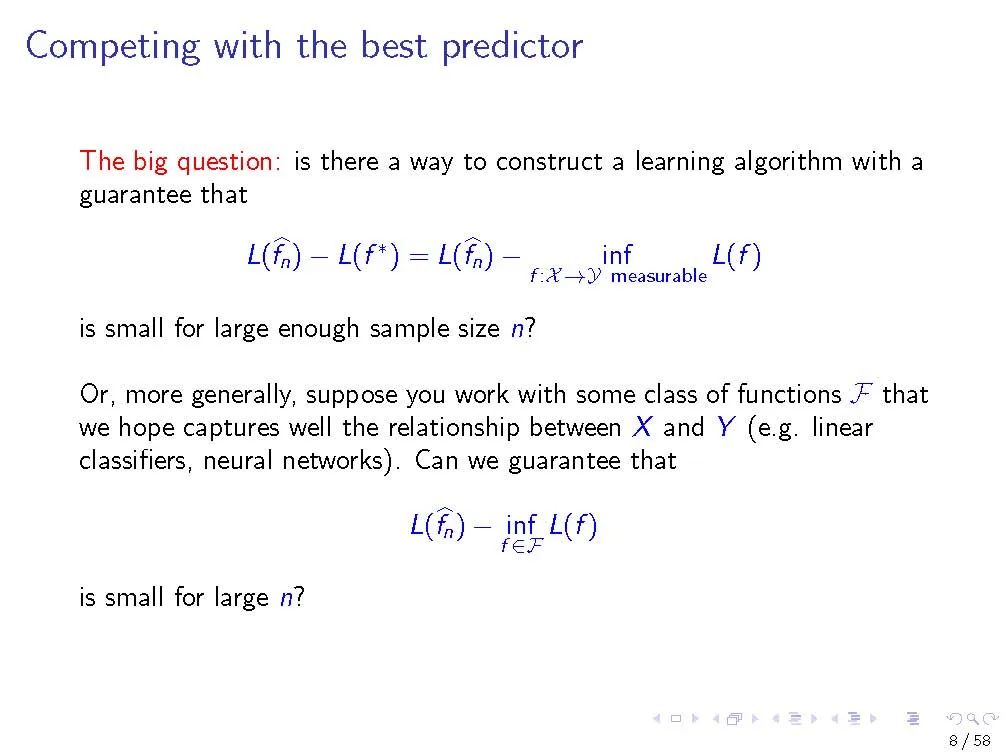

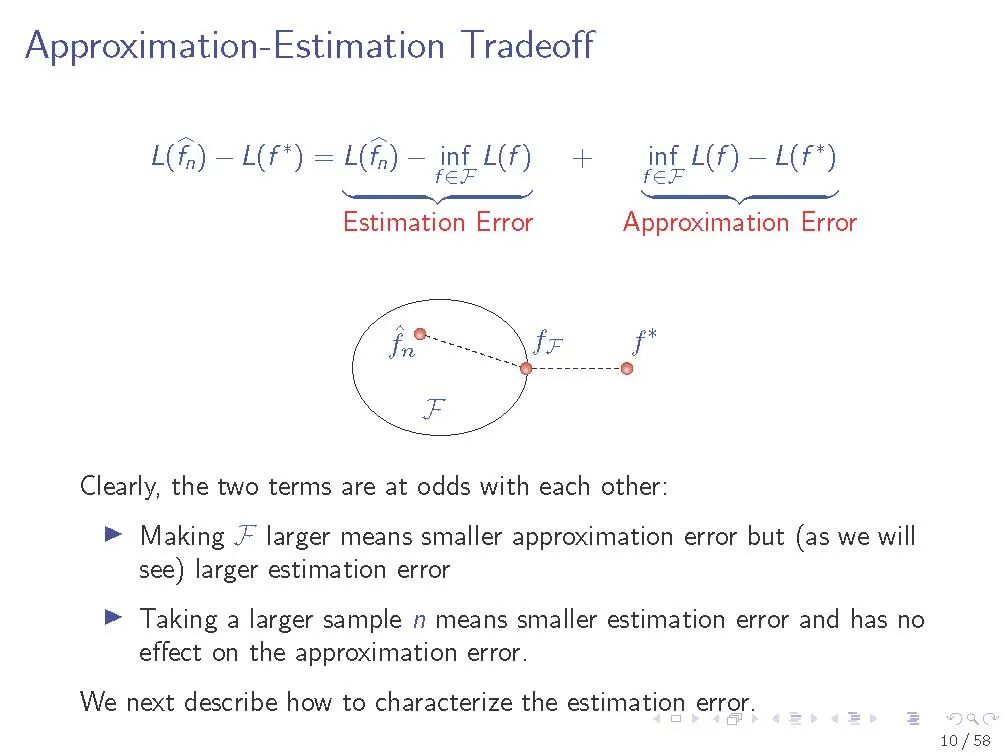

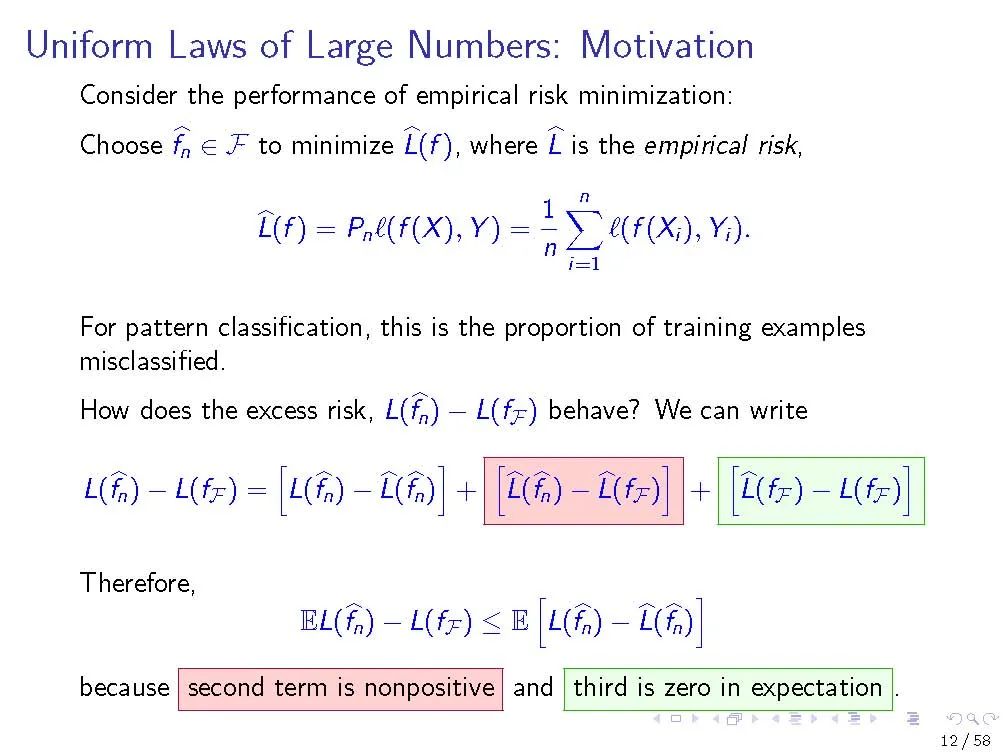

在第一个教程中,我们回顾了来自经典统计学习理论的工具,这些工具对理解深度神经网络的泛化性能很有用。我们描述大数的统一定律,以及它们如何依赖于感兴趣的函数类的复杂性。我们专注于一个特定的复杂性度量,Rademacher复杂性,以及深度ReLU网络中这种复杂性的上界。我们研究了现代神经网络的行为如何与在经典设置中发展的直觉相冲突。

在第二篇教程中,我们将从优化的角度回顾理解神经网络训练的方法。我们回顾了凸目标和光滑目标的梯度下降的经典分析。我们描述了Polyak- Lojasiewicz (PL)不等式,并讨论如何在神经网络训练的背景下解释这样的不等式。我们描述了一种特殊的神经网络训练机制,它可以通过核方法很好地逼近,被称为神经切线核(NTK)机制。我们展示了如何用两种方法建立神经网络的PL不等式:一种基于NTK近似的一般方法,另一种在线性可分离数据的特殊设置中。

Spencer Frei

加州大学伯克利分校Simons计算理论研究所的博士后,该研究所由Peter Bartlett和Bin Yu主持,是美国国家科学基金会/Simons合作项目深度学习理论基础的一部分。我对机器学习、统计和优化感兴趣,尤其对理解深度学习中观察到的统计和计算现象感兴趣。

在来伯克利之前,我在UCLA完成了统计学博士学位,导师是Quanquan Gu和Ying Nian Wu。在此之前,我在温哥华的英属哥伦比亚大学完成了数学硕士学位,在那里我的导师是Ed Perkins。在此之前,我在麦吉尔大学完成了我的数学本科学位。

https://www.stat.berkeley.edu/~frei/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“S58” 就可以获取《如何理解统计学习理论、优化与神经网络?伯克利Spencer Frei最新演讲报告,附58页ppt与视频》专知下载链接