【MIT课程】深度学习不确定性,Google大脑Jasper Snoek演讲,附Slides与视频

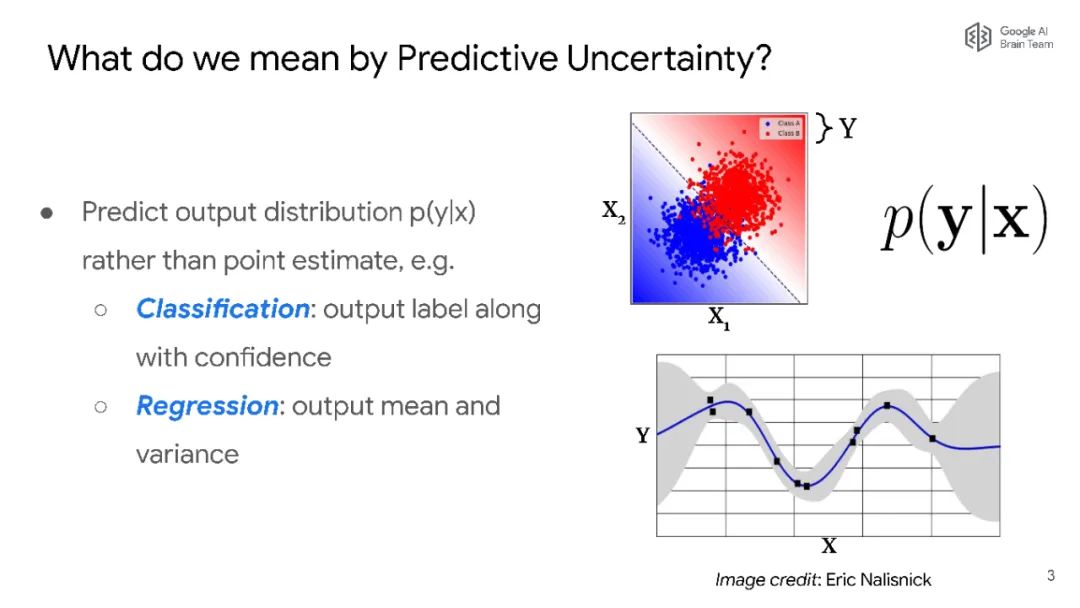

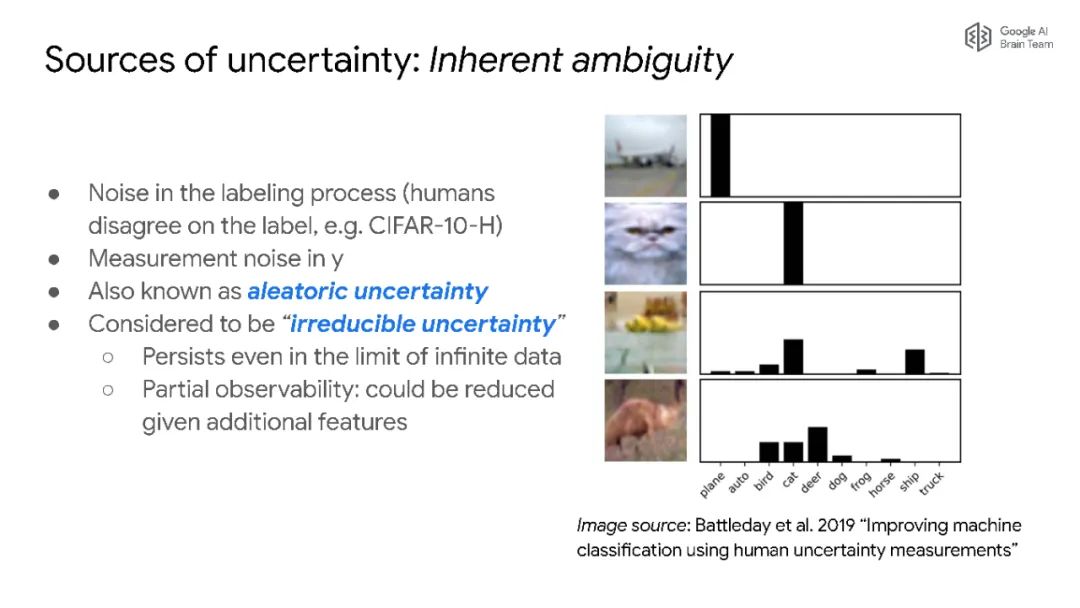

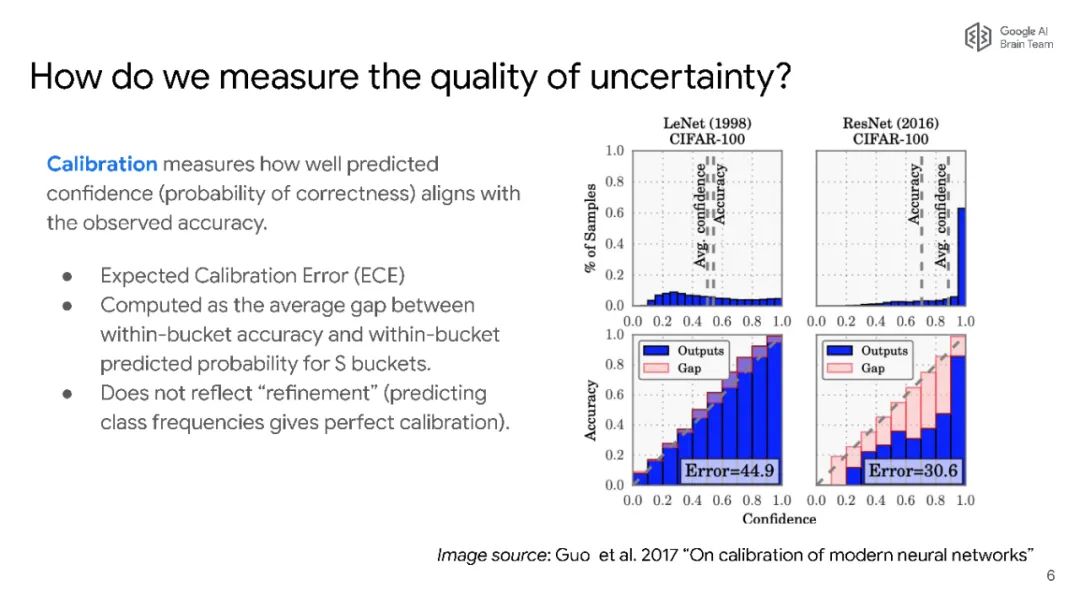

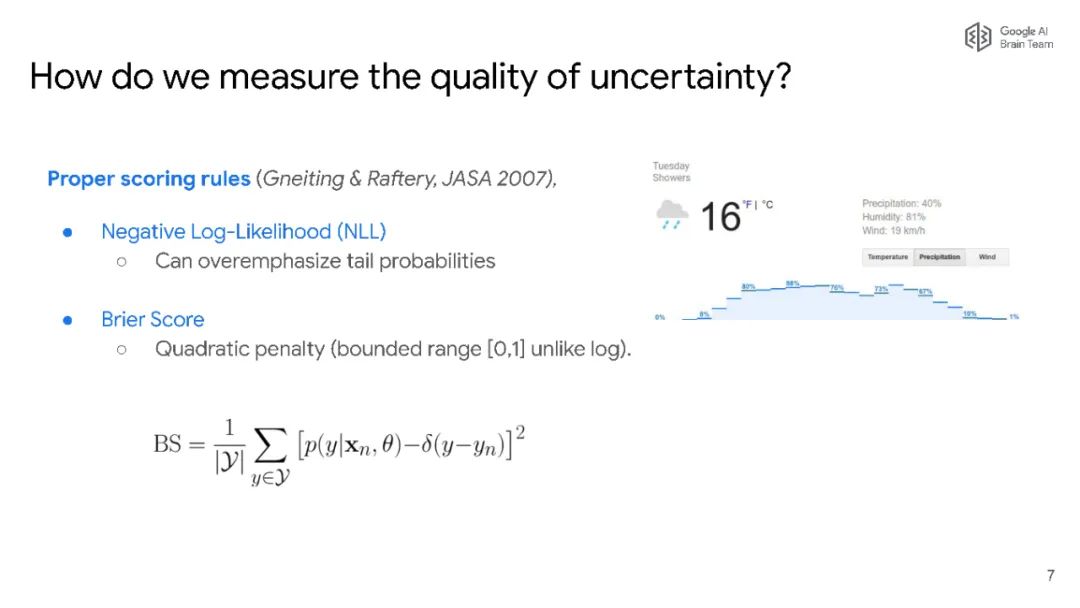

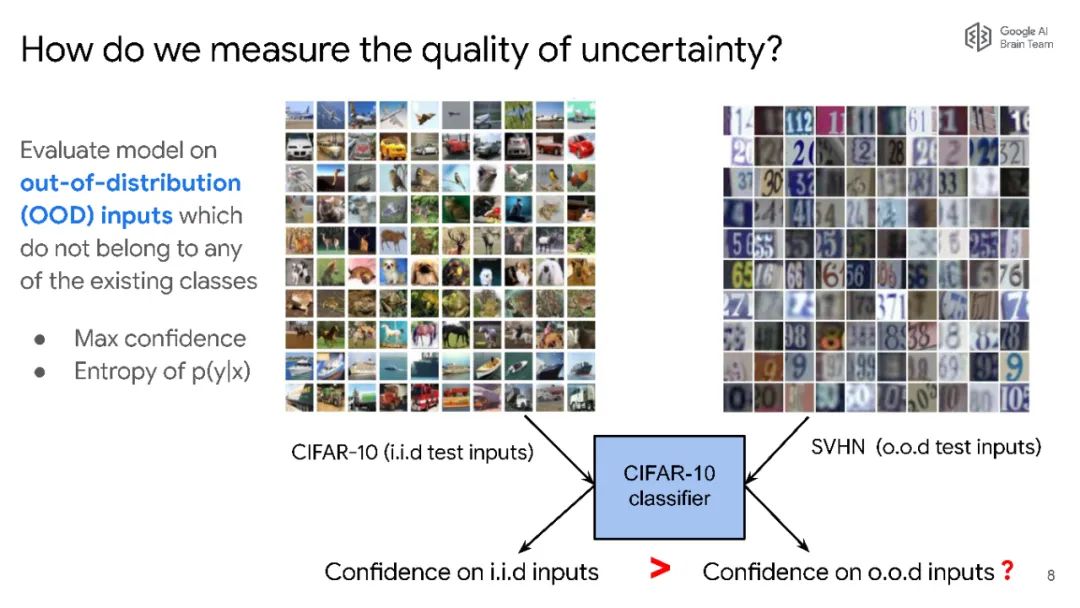

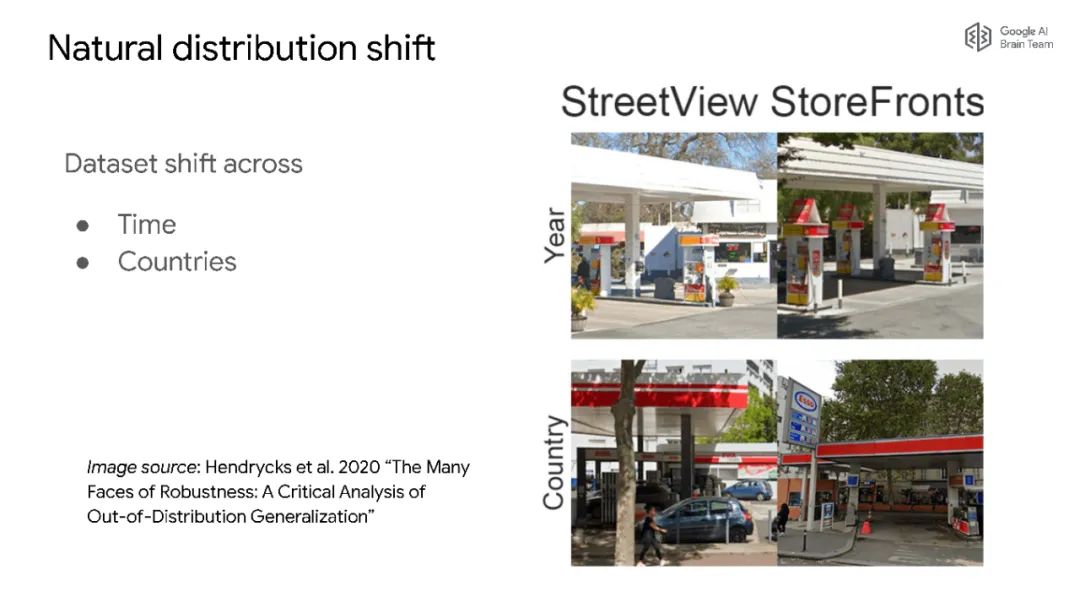

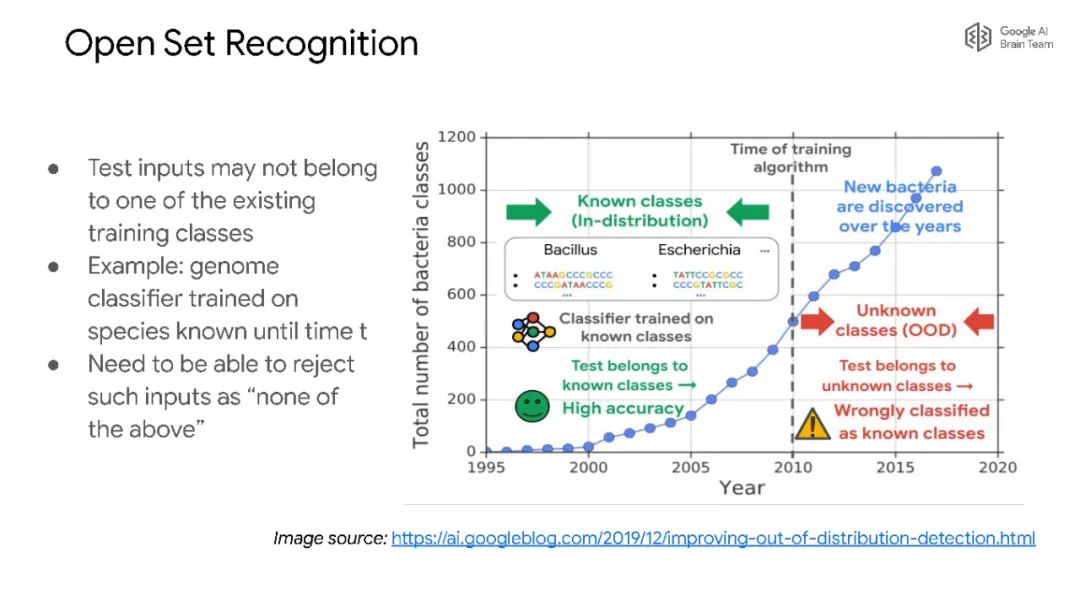

深度学习模型不擅长发出失败信号:它们倾向于以较高的置信度进行预测,而这在现实世界的应用中是有问题的,比如医疗保健、自动驾驶汽车和自然语言系统,这些应用存在相当大的安全影响,或者在训练数据和模型预测的数据之间存在差异。现在迫切需要了解什么时候模型不应该进行预测,以及提高模型对数据自然变化的稳健性。在这次演讲中,简要介绍一下我的关于深度学习中的不确定性和鲁棒性的NeurIPS教程,然后介绍一些最近为应对这些挑战而研究的工作。

Jasper Snoek目前是谷歌Brain公司的研究科学家。最近他的研究主要集中在提高深度学习方法的不确定性和鲁棒性的方法。他的兴趣涉及贝叶斯方法和深度学习的交叉领域。他在多伦多大学完成了机器学习博士学位。随后,他在多伦多大学(University of Toronto)接受杰弗里·辛顿(Geoffrey Hinton)和Ruslan Salakhutdinov的研究,并在哈佛大学(Harvard)计算与社会研究中心接受瑞安·亚当斯(Ryan Adams)的研究。Jasper Snoek是机器学习初创公司Whetlab的联合创始人之一,该公司后来被Twitter收购。他曾担任NeurIPS、ICML和ICLR的区域主席,并在ICML和NeurIPS组织了各种研讨会。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DLUS” 就可以获取《【MIT课程】深度学习不确定性,Google大脑Jasper Snoek演讲,附Slides与视频》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年7月26日