题目: Continue Meta-learning without tasks

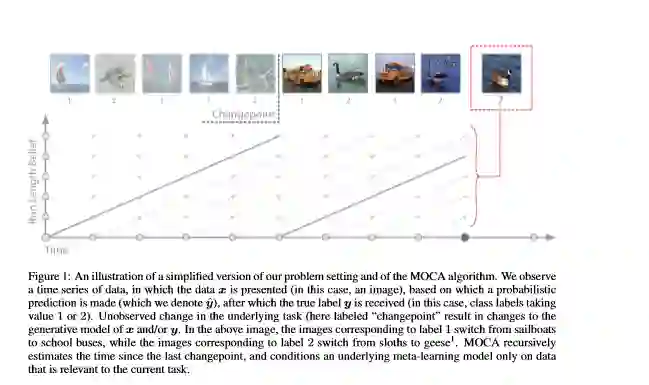

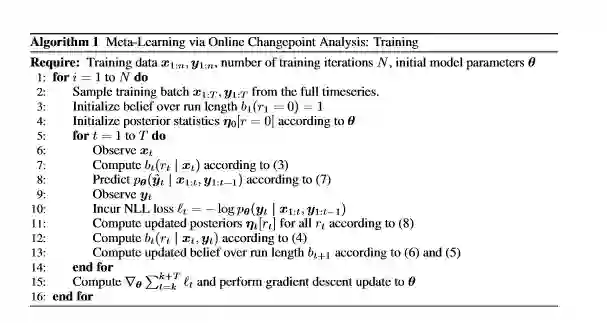

简介: 元学习可以利用从任务分配中收集的数据来有效地学习新任务。然而,迄今为止,元学习文献集中于任务分段设置,即在训练时,根据其基础任务和测试时间将“数据”汇总为多个,对算法进行了优化以在单个任务中学习。在这项工作中,我们可以将通用元学习算法应用于无法进行此任务细分的设置,例如使用时变任务进行连续在线学习。我们介绍了通过在线变更点分析(MOCA)进行的元学习,该方法利用可区分的贝叶斯变更点检测方案增强了元学习算法。该框架允许直接对时间序列数据进行培训和测试,而无需将其细分为离散任务。我们在非线性元回归基准以及两个元图像分类基准上证明了该方法的实用性。

成为VIP会员查看完整内容

相关内容

ICLR,全称为「International Conference on Learning Representations」(国际学习表征会议),2013 年才刚刚成立了第一届。这个一年一度的会议虽然今年才办到第五届,但已经被学术研究者们广泛认可,被认为「深度学习的顶级会议」。

ICLR由位列深度学习三大巨头之二的 Yoshua Bengio 和 Yann LeCun 牵头创办。

ICLR 希望能为深度学习提供一个专业化的交流平台。但实际上 ICLR 不同于其它国际会议,得到好评的真正原因,并不只是他们二位所自带的名人光环,而在于它推行的 Open Review 评审制度。

专知会员服务

10+阅读 · 2019年12月12日