主题: A New Meta-Baseline for Few-Shot Learning

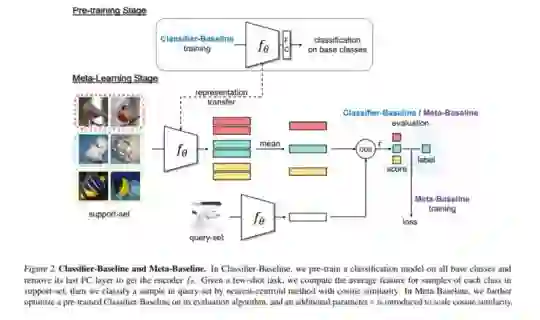

摘要: 近年来,元学习已经成为小样本学习的流行框架,其目标是从少拍分类任务的集合中学习模型。虽然提出了越来越多的新颖元学习模型,但我们的研究发现了被忽视的简单基准。我们通过在所有基类上预先训练分类器,并在基于最近质心的少数镜头分类算法上进行元学习,提出了一种Meta-Baseline方法,该方法以较大的优势胜过了最新的方法。为什么这个简单的方法这么好?在元学习阶段,我们观察到在基础类的未见任务上更好地推广的模型在新型类任务上的性能可能会下降,这表明存在潜在的客观差异。我们发现预训练和从预训练的分类器继承良好的几次快照分类法对于元基线都很重要,这可能有助于模型更好地利用具有更强可传递性的预训练表示。此外,我们研究了何时需要在此元基线中进行元学习。我们的工作为该领域建立了一个新的基准,并为进一步了解元学习框架中的几次学习现象提供了启示。

成为VIP会员查看完整内容