题目: Meta-Learning in Neural Networks: A Survey

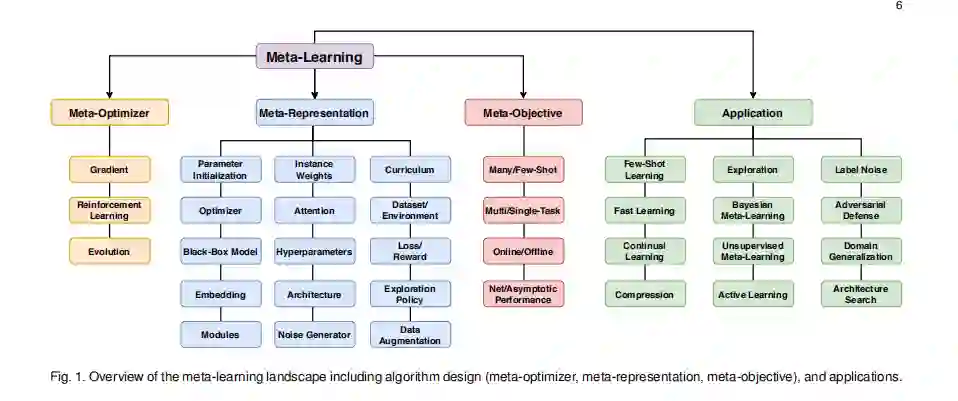

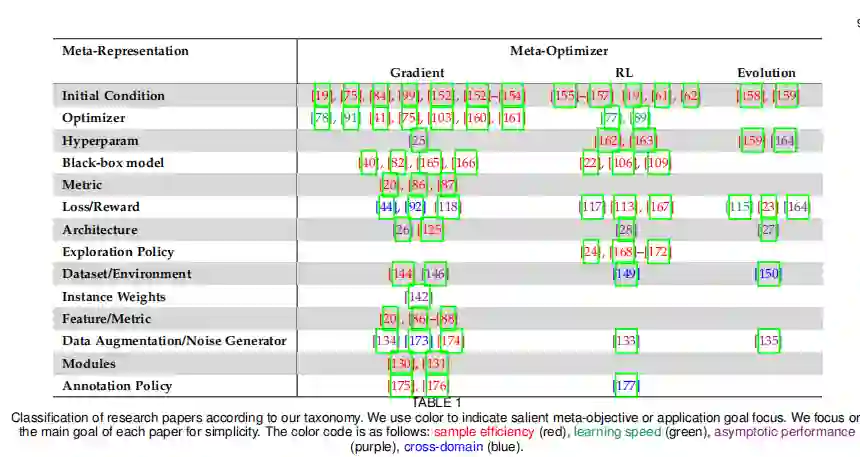

简介: 近年来,元学习领域的兴趣急剧上升。与使用固定学习算法从头解决给定任务的传统AI方法相反,元学习旨在根据多次学习事件的经验来改善学习算法本身。这种范例为解决深度学习的许多传统挑战提供了机会,包括数据和计算瓶颈以及泛化的基本问题。在本次调查中,我们描述了当代的元学习环境。我们首先讨论元学习的定义,并将其相对于相关领域(例如转移学习,多任务学习和超参数优化)进行定位。然后,我们提出了一种新的分类法,该分类法为当今的元学习方法提供了更为全面的细分。我们调查了元学习的有希望的应用程序和成功案例,包括,强化学习和架构搜索。最后,我们讨论了未来研究的突出挑战和有希望的领域。

成为VIP会员查看完整内容