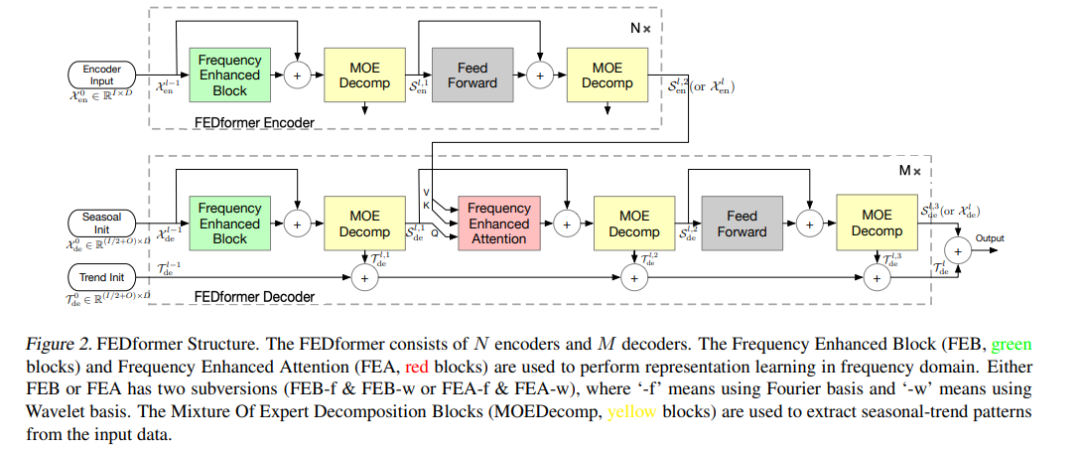

尽管基于Transformer的方法显著改善了长期序列预测的最先进结果,但它们不仅计算成本高,更重要的是,无法捕捉时间序列的全局视图(例如,总体趋势)。为了解决这些问题,我们提出将Transformer与季节趋势分解方法相结合,其中分解方法捕获时间序列的全局剖面,而Transformer捕获更详细的结构。为了进一步增强Transformer的长期预测性能,我们利用了大多数时间序列倾向于以众所周知的基(如傅里叶变换)为基础进行稀疏表示的事实,并开发了频率增强Transformer。该方法被称为频率增强分解变换器(federformer),除具有更高的效率外,它比序列长度线性复杂度的标准变压器效率更高。在6个基准数据集上的实证研究表明,对于多变量和单变量时间序列,FEDformer方法的预测误差分别比现有方法降低了14.8%和22.6%。代码将很快发布。

https://www.zhuanzhi.ai/paper/5786e05d73ef3afa50ace494c3beeb15

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年7月7日

Arxiv

12+阅读 · 2021年12月28日