【AAAI2021】生成式Transformer的对比三元组提取

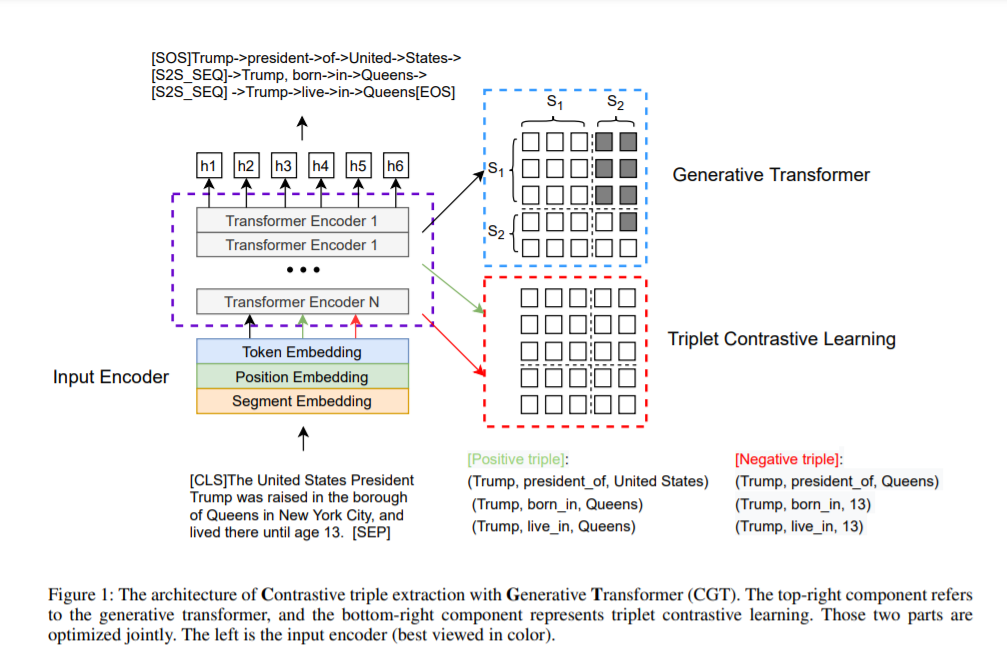

在自然语言处理和知识图构造的信息提取中,三次提取是必不可少的任务。在本文中,我们将重新审视用于序列生成的端到端三重提取任务。由于生成三元组提取可能难以捕获长期依赖关系并生成不忠实的三元组,因此我们引入了一种新颖的模型,即使用生成Transformer的对比三元组提取。具体来说,我们介绍了一个共享的Transformer模块,用于基于编码器-解码器的生成。为了产生忠实的结果,我们提出了一种新颖的三重态对比训练对象。此外,我们引入了两种机制来进一步提高模型性能(即,批量动态注意遮罩和三级校准)。在三个数据集(即NYT,WebNLG和MIE)上的实验结果表明,我们的方法比基线具有更好的性能。

https://www.zhuanzhi.ai/paper/b8ed53721b7162af43614d558adb9c58

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CTE” 可以获取《【AAAI2021】生成式Transformer的对比三元组提取》专知下载链接索引

登录查看更多

相关内容

专知会员服务

99+阅读 · 2020年7月3日