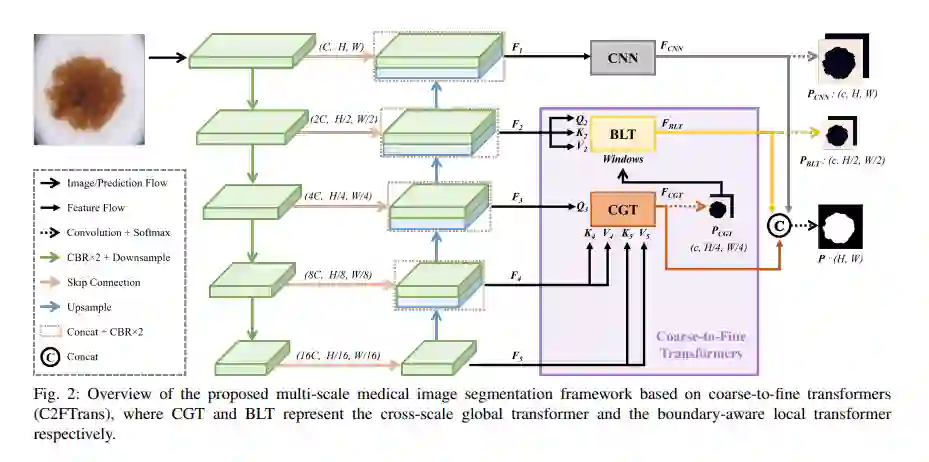

卷积神经网络(CNN)是基于深度学习的医学图像分析中最流行的架构,但其固有的归纳偏差和不充分的接受域仍然在功能上受到限制。为了解决这个问题而诞生的Transformer,由于其在捕获远程依赖关系方面的卓越能力,在自然语言处理和计算机视觉领域引起了爆炸性的关注。然而,最新的基于变压器的医学图像分割方法在基于CNN的方法中直接将普通Transformer作为辅助模块,由于Transformer中的patch划分方法过于严格,导致了严重的细节丢失。为了解决这个问题,我们提出了C2FTrans,一种新颖的多尺度架构,将医学图像分割作为一个从粗到细的过程。C2FTrans主要由一个跨尺度的全局Transformer(CGT)和一个边界感知的局部Transformer(BLT)组成,前者处理CNN中的局部上下文相似性,后者克服了Transformer中刚性patch划分带来的边界不确定性。CGT在三个不同的小尺度特征映射之间构建全局依赖关系,以可接受的计算成本获得丰富的全局语义特征;BLT在熵的指导下,自适应地在边界周围生成窗口,以降低基于大尺度特征映射的计算复杂度和细节损失。在三个公共数据集上的大量实验结果表明,C2FTrans在参数更少、故障更低的情况下,相对于最先进的基于CNN和基于Transformer的方法具有更好的性能。我们相信,C2FTrans的设计将进一步启发未来开发高效、轻量化的医学图像分割Transformer的工作。本文的源代码在https://github.com/xianlin7/C2FTrans上公开。

https://www.zhuanzhi.ai/paper/a9dc2afe9459bd58a0f3caabafd2df1d

成为VIP会员查看完整内容