【ICML2022】通过凸对偶揭示注意力:视觉Transformers的分析与解读

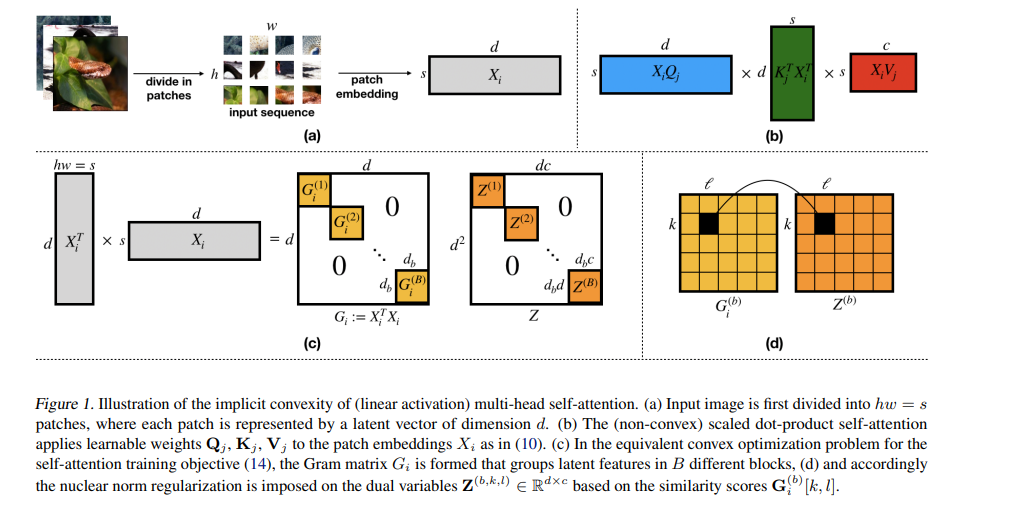

利用自注意或其提出的替代方案的视觉transformers 在许多与图像相关的任务中显示出良好的结果。然而,归纳性注意偏差的基础还没有被很好地理解。为了解决这一问题,本文通过凸二象性的视角来分析注意力。对于非线性点积自注意,以及MLP混合器和傅立叶神经算子(FNO)等替代机制,我们导出了可解释和可求解全局最优的等价有限维凸问题。凸规划导致阻塞核范数正则化,在潜在特征和令牌维度上提高低秩。特别地,我们展示了自注意力网络如何基于它们的潜在相似性隐式聚集令牌。我们通过对各种凸注意力头进行微调,实现了用于CIFAR-100分类的预训练transformers 骨干的转移实验。结果表明,与现有的MLP或线性磁头相比,由注意力引起的偏置具有优越性。

https://www.zhuanzhi.ai/paper/bdf2d9661e9c0ed0cb8e6b6dfcb965d4

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“AIVT” 就可以获取《【ICML2022】通过凸对偶揭示注意力:视觉Transformers的分析与解读》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年7月22日

Arxiv

10+阅读 · 2021年10月4日