题目: On the Number of Linear Regions of Convolutional Neural Networks

摘要:

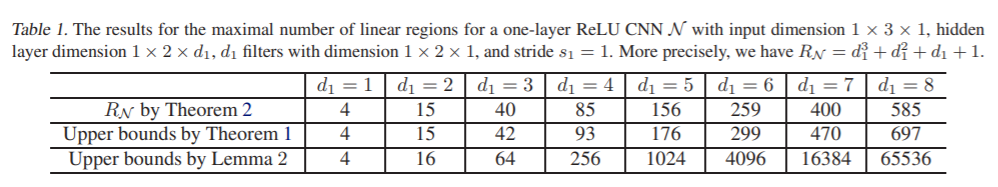

深度学习的一个基本问题是理解深度神经网络(NNs)在实践中的卓越性能。对神经网络优越性的一种解释是,它可以实现大量复杂的函数,即它们有强大的表现力。ReLU型神经网络的表达能力可以用它能分割其输入空间的最大线性区域数来量化。自2013年以来,关于全连接ReLU神经网络线性区域数的研究已经取得了各种结果。然而,据我们所知,由于缺乏合适的数学工具,对于卷积神经网络(CNNs)的线性区域的数量没有明确的结果。本文给出了研究网络神经网络线性区域所需要的几个数学结果,并利用这些结果得到了单层神经网络的最大和平均线性区域数。进一步,我们得到了多层ReLU网络的线性区域数的上界和下界。还得到了一些渐近结果。结果表明,更深层次的网络比浅层次的网络具有更强的表达能力,而在每个参数上,网络比全连接网络具有更强的表达能力。据我们所知,这篇论文是第一次研究CNN的线性区域数。最后给出了各种可能的发展方向。

成为VIP会员查看完整内容

相关内容

专知会员服务

60+阅读 · 2020年6月28日

专知会员服务

49+阅读 · 2020年2月15日

专知会员服务

116+阅读 · 2019年12月30日

Arxiv

11+阅读 · 2019年9月8日