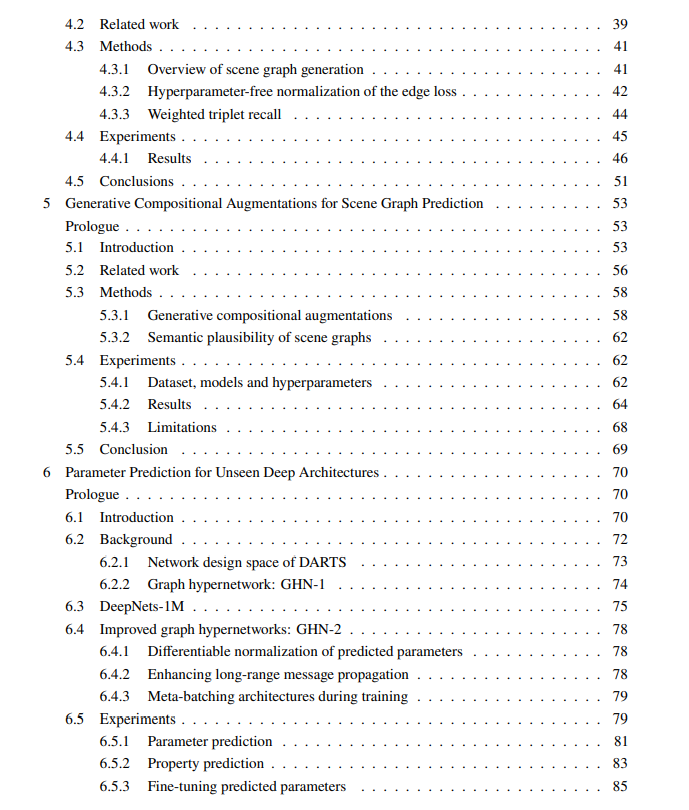

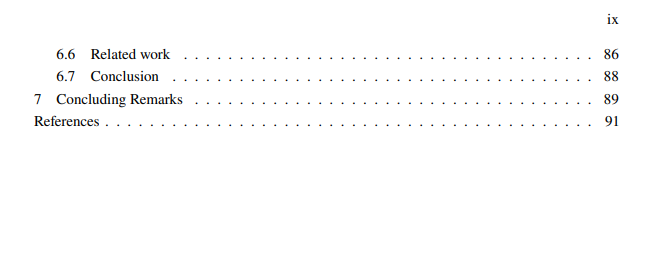

这篇论文在机器学习领域做出了一些贡献,特别是在图推理任务。每篇文章都研究并改进了几种图推理应用中的泛化: 经典图分类任务、组合视觉推理和神经网络图参数预测的新任务。

在第一篇文章中,我们研究了图神经网络中的注意力机制。虽然注意力在GNN中得到了广泛的研究,但它对泛化到更大的噪声图的影响还没有被深入分析。我们证明,在合成图任务中,可以通过仔细初始化GNN的注意力模块来提高泛化能力。我们还开发了一种方法,降低了注意力模块对初始化的敏感性,提高了实际图任务的泛化能力。

在第二篇文章中,我们讨论了将问题泛化到视觉场景中罕见或不可见的物体组合和关系。以往的工作多以频繁的视觉构图为主,构图泛化能力较差。为了缓解这一问题,我们发现将损失函数与场景图的结构进行归一化是很重要的,这样可以更有效地利用训练标签。用我们的损失训练的模型显著提高了合成泛化。

在第三篇文章中,我们将进一步讨论视觉合成泛化。我们考虑一种数据增强方法,即在训练数据中添加罕见的和不可见的成分。我们开发了一个基于生成对抗网络的模型,该模型根据我们通过扰动真实场景图获得的罕见或不可见的场景图生成合成视觉特征。我们的方法不断改进合成的泛化。

在第四篇文章中,我们研究了在不可见的深度神经结构中预测参数的新任务中的图推理。我们的任务的动机是由于用于训练神经网络的迭代优化算法的局限性。为了解决我们的任务,我们开发了一个基于Graph HyperNetworks的模型,并在我们的神经架构图数据集上训练它。我们的模型可以在一次向前传递中预测不可见的深度网络(如ResNet-50)的性能参数。该模型可用于神经结构搜索和迁移学习。

https://atrium.lib.uoguelph.ca/xmlui/handle/10214/26824

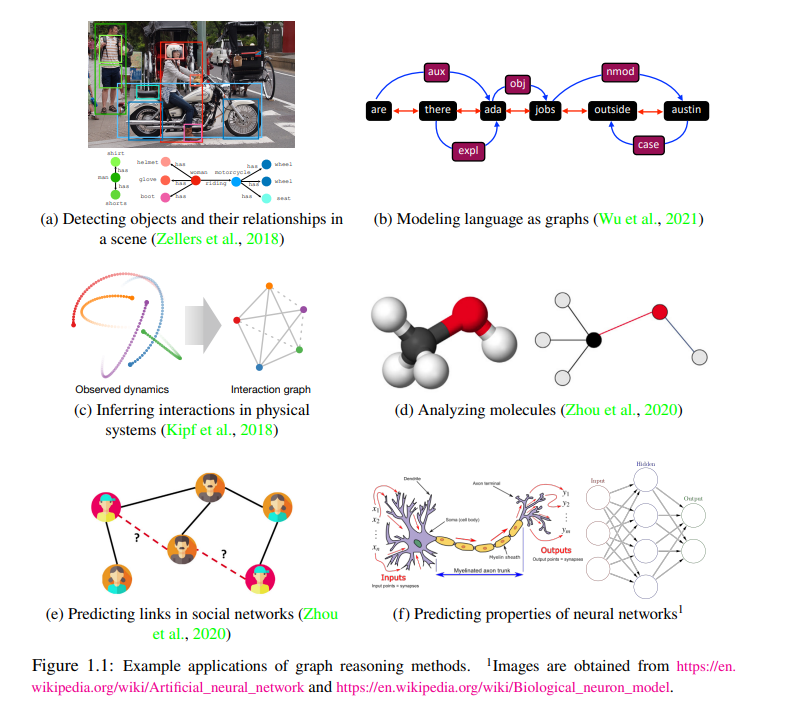

我们的世界是一个复杂的组合系统,简单的组件用来创建更复杂的组件,所有组件以一种非平凡的方式交互。其中一个组成部分就是人类,人类天生就有能力积累多样化的多领域知识,并学习周围世界的丰富组成结构。这种知识使人类能够轻松地解决大量复杂的任务。例如,给定一个复杂动态3D场景的静态2D图像,人类能够识别物体,它们的部分,它们之间的关系,并预测场景中的未来事件。人类甚至可以预测场景的地理和人口背景,并推断场景的情感等抽象属性(图1.1,a)。工程旨在开发能够替代人类执行此类任务的系统和算法,特别是重复性、费力或危险的任务。在一些实际场景中,如理解2D图像,这些系统需要从传感器记录的输入中恢复原始成分结构(图1.1,a-c)。例如,机器人或自动驾驶汽车需要从原始像素或点云中检测物体及其关系。在其他场景中,组合结构已经提供(例如,由另一个系统或人类提供),算法需要对组合输入进行推理,以做出复杂的高级决策(图1.1,d-f)。例如:预测分子的性质,预测未来人与人之间的联系,或预测生物或人工神经网络的性质。

为了开发能够从原始感官数据推断组成结构的算法或预测结构属性的算法,我们首先需要定义适合于这类任务的数据抽象。在数学和计算机科学中,有一种方便的抽象专门介绍了模型的组成和关系结构。这种抽象被称为图,其中节点对应结构的组件,而边对应组件之间的交互。例如,分子通常表示为图形,节点对应原子或更复杂的元素,边对应化学键(图1.1,d)。类似地,社会网络是图形,节点是人,边是它们之间的不同类型的关系(图1.1,e)。同样地,生物或人工神经网络是一个图,其中节点可以是神经元,边可以是它们之间的连接(图1.1,f)。需要开发处理相关任务的算法。

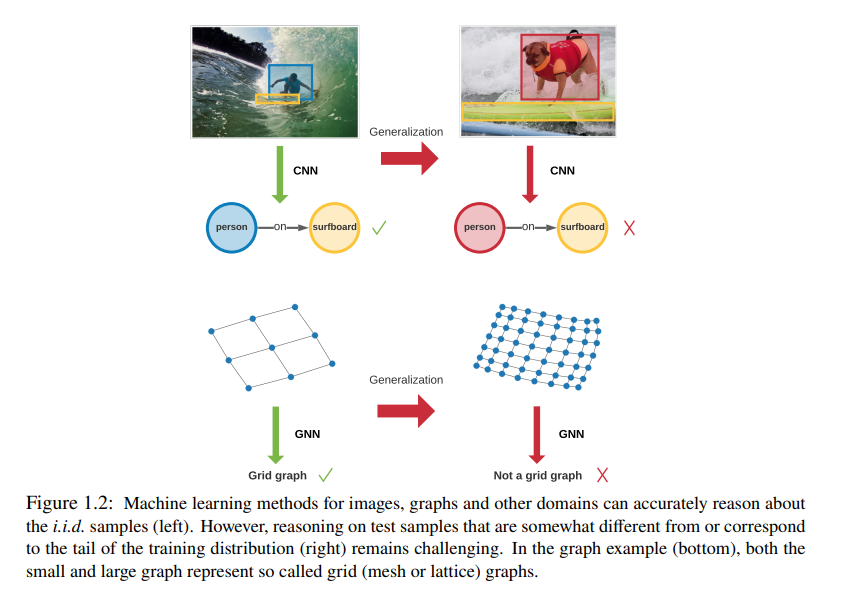

本文探讨了图分类、场景图合成视觉推理和神经网络推理等图推理任务中的泛化问题。使用从数据而不是工程特征中学习的模型来处理这些任务是事实上的标准。然而,这种模型的一个基本挑战,尤其是神经网络,是糟糕的泛化。出现这一问题的原因可能是模型依赖于伪相关(“捷径”),而这些伪相关在训练数据中常常大量存在(Shen et al., 2021; Zhou et al., 2021; Schölkopf et al., 2021)。当在测试数据上评估NN时,这个问题尤其值得注意,这些测试数据来自于与训练数据略有不同的分布。虽然人类经常对各种分布转移表现出很强的泛化能力,但机器学习模型在这方面要弱得多。这篇论文对理解和提高泛化做出了一些贡献。