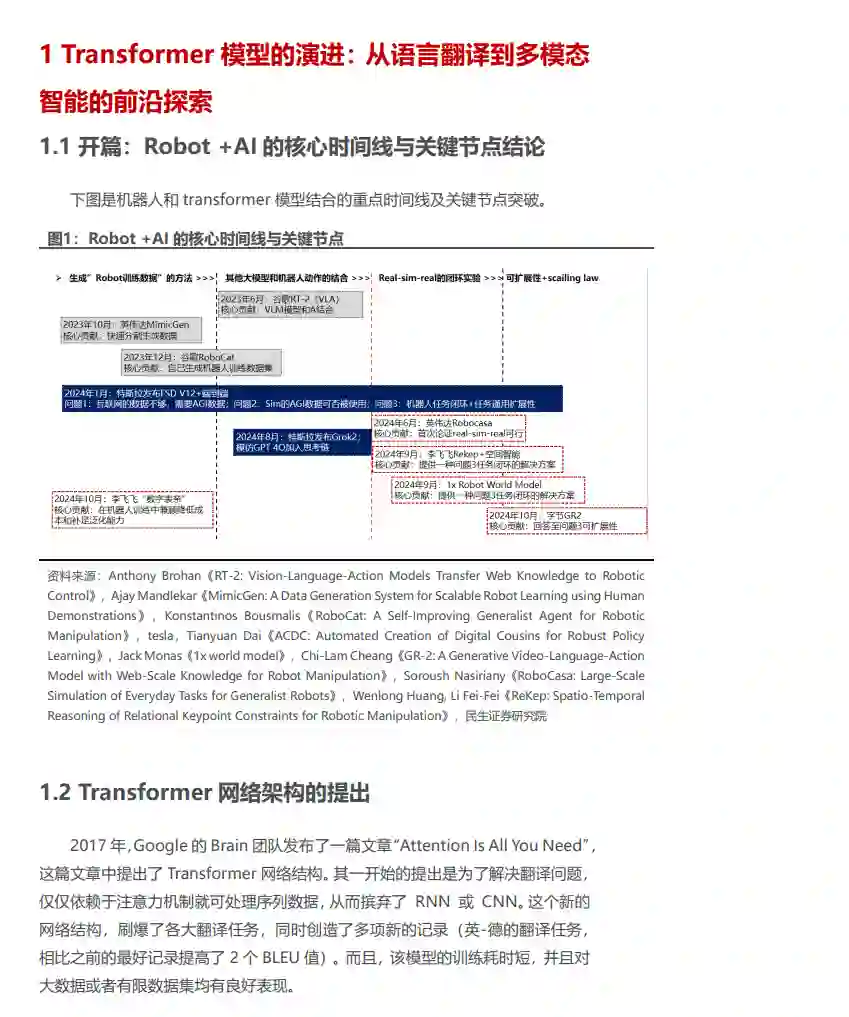

从Transformer到多模态大模型的演进与应用。Transformer不仅在语言处理上广泛应用,还扩展至图像、视频、音频等多模态任务。诸如StableDiffusion、VideoPoet和MusicLM等模型展现了其强大的生成能力,推动了多模态大模型(MLLM)的发展。 机器人现实世界至数据化的突破:RT-2、RoboCat与MimicGen。RT-2通过大规模的视觉-语言预训练,将视觉识别与低级机器人控制结合,实现了机器人在复杂任务和未见环境中的强大泛化能力。RoboCat则基于Gato模型,展示了多任务和多具身平台上的自我迭代学习能力,能够快速适应新任务并生成跨任务策略。英伟达的MimicGen自动生成大量模仿学习数据,有效减少了人工干预,提升了机器人学习的效率。 特斯拉FSD,端到端算法成为主流,数据为关键。2020年FSD引入Transformer模型,走向了数据驱动的模型范式,2024年初FSD V12完全采用神经网络进行车辆控制,从机器视觉到驱动决策都将由神经网络进行控制。FSDV12能够模拟人类驾驶决策,成为自动驾驶领域全新发展路径。 英伟达Robocasa:具体智能关键节点,首次论证real-sim-real。通过升级模拟平台并构建模拟框架,基于厨房场景和原子任务、复合任务、真实世界三个场景收集行为数据集并进行结果评估。说明模拟器的丰富多样性以及视觉和物理真实性显著改善了模拟效果,实验结果首次论证了real-sim-real可行。 后续演绎:在机器人real-sim-real可行,证明存在scaling law的基础上,持续推荐可执行任务的泛化能力,迈向真正的AGI智能化:1)李飞飞Rekep:一种针对机器人操作任务的新型空间和时间约束表示方法,提供了一种三任务闭环的解决方案。通过关键点约束解构机器人行为,将操作行为分为多阶段,并构建子目标约束和路径约束,基于此提出一种三任务闭环的解决方案。同时,融入大型视觉模型和视觉-语言模型,利用VLM和GPT-4o生成Rekep约束,避免了手动指定Rekep的需要。2)1x世界模型:首证扩展定律,能通过大量学习理解周围环境。通过大量的真实数据学习和模拟,机器人能够预测复杂的物体互动,理解周围环境,并灵活应对日常任务。1x的进展首次在机器人上证明了扩展法则。3)GR-2的高效动作预测与泛化能力。由字节跳动研究团队开发的第二代机器人大模型,凭借大规模视频预训练和多模态学习技术,展示了卓越的泛化能力与多任务通用性。4)数字表亲:机器人训练法优化,以更低的成本获取更好的泛化能力。在保留数字孪生优势的基础上,数字表亲表现出了更强的适应能力和鲁棒性,成功实现了从模拟到现实的零样本迁移,为机器人学习在复杂、多变的真实环境中的应用开辟了新的可能性。