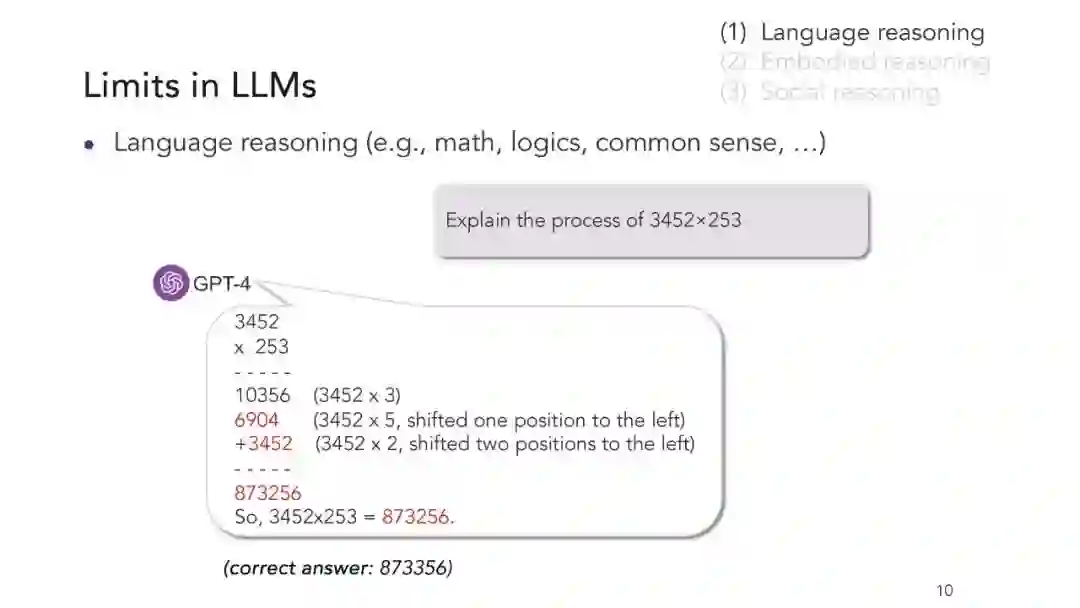

大型语言模型(LMs)在许多语言任务中取得了显著的成功。最近的研究也表明,大型LMs能够从世界知识中获益,从而帮助人们在体现任务中进行决策。然而,目前大型LMs展现的世界知识往往不够稳健,且在没有额外模型的情况下无法在物理环境中得到实现。这限制了它们可靠地执行复杂推理和规划任务的能力。例如,在创建移动积木到目标状态的行动计划时,GPT-4与人类相比成功率显著较低。 另一方面,人类基于对世界的心智模型进行深思熟虑的推理和规划,这也被称为世界模型(WM),它使我们能够模拟行动及其对世界状态的影响。编码物理世界知识的WMs可以极大地提高智能代理的数据效率和稳健性。 然而,WMs通常在强化学习和机器人技术领域进行研究,这些领域在概念上与语言建模研究的问题不同。这一差距表明将WMs与LMs相结合,以提升LM在体现和通用设置中的推理和规划能力,并解决上述局限性,是一个新的机遇。在WMs和LMs交汇点上的新兴研究已展示出有希望的结果。本教程旨在总结并呈现连接WMs和LMs的统一视角,突出基于大型LMs通过世界建模来改进机器推理和规划的各种机会。我们将回顾近期关于学习WMs的研究,并使用它们来进一步学习和执行体现任务。我们将展示LMs如何利用外部WMs来弥补其缺乏的基于地面的世界知识,以及LMs本身如何从超越文本数据的体现经验中学习世界模型,并使用这些内部WMs来指导复杂推理。

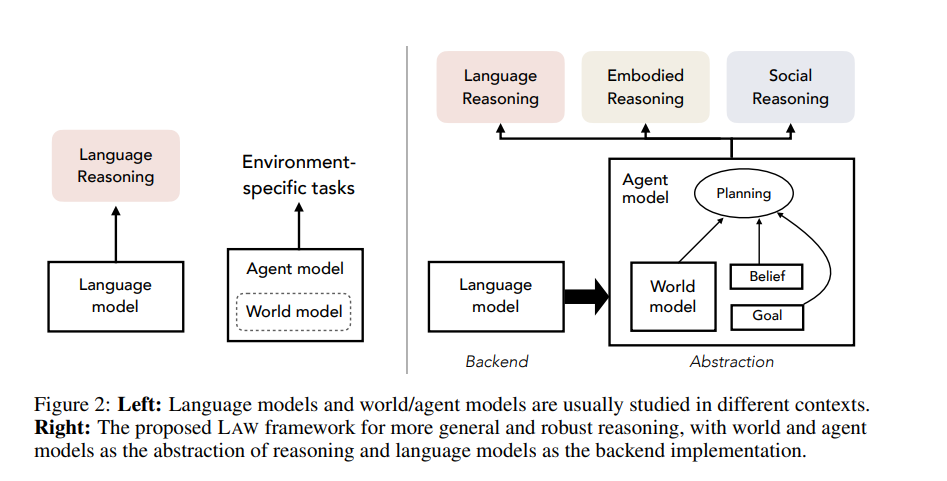

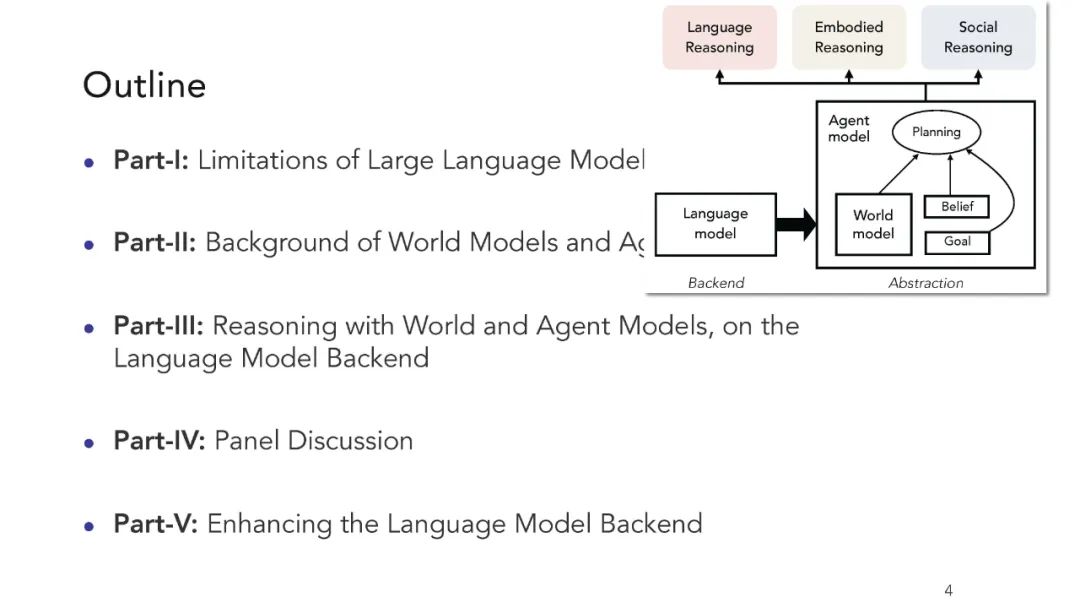

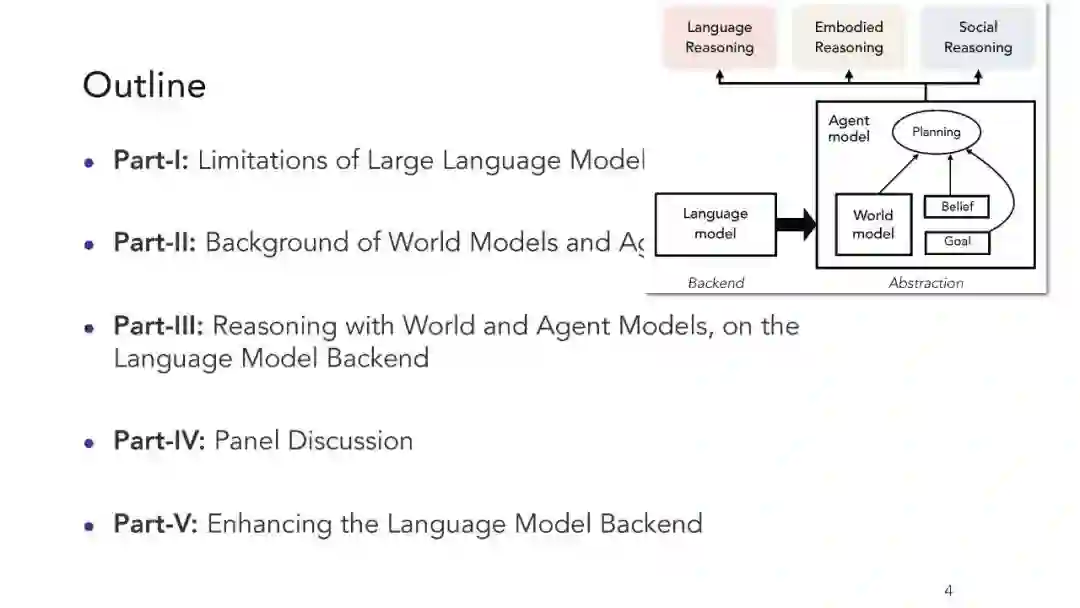

尽管在许多应用中取得了巨大成功,但大型语言模型在各种(语言、体现和社会)场景中常常难以实现一致的推理和规划,这是由于它们在推理、学习和建模能力上的固有局限。在这篇立场论文中,我们提出了一种新的机器推理观点,LAW,它将语言模型、代理模型和世界模型的概念联系起来,以实现更稳健和多样的推理能力。特别是,我们认为世界和代理模型是一种更好的推理抽象,它引入了人类推理的关键元素,包括对世界和其他代理的信念、对后果的预期、目标/奖励和战略规划。关键的是,LAW中的语言模型作为实现系统或其元素的后端,因此提供了计算能力和适应性。我们回顾了近期取得相关进展的研究,并讨论了将LAW框架实用化的未来研究方向。

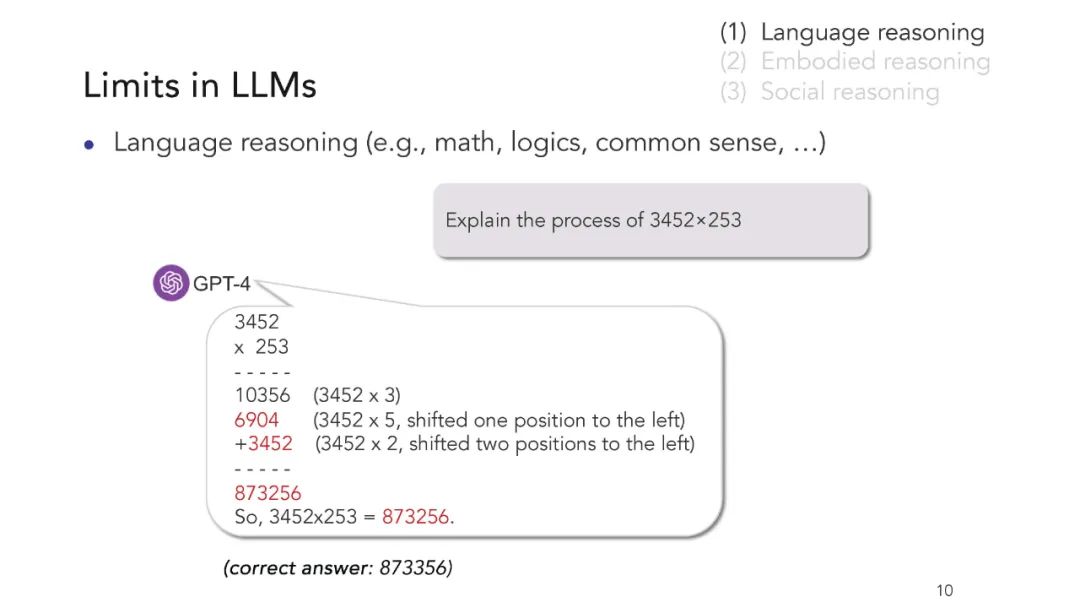

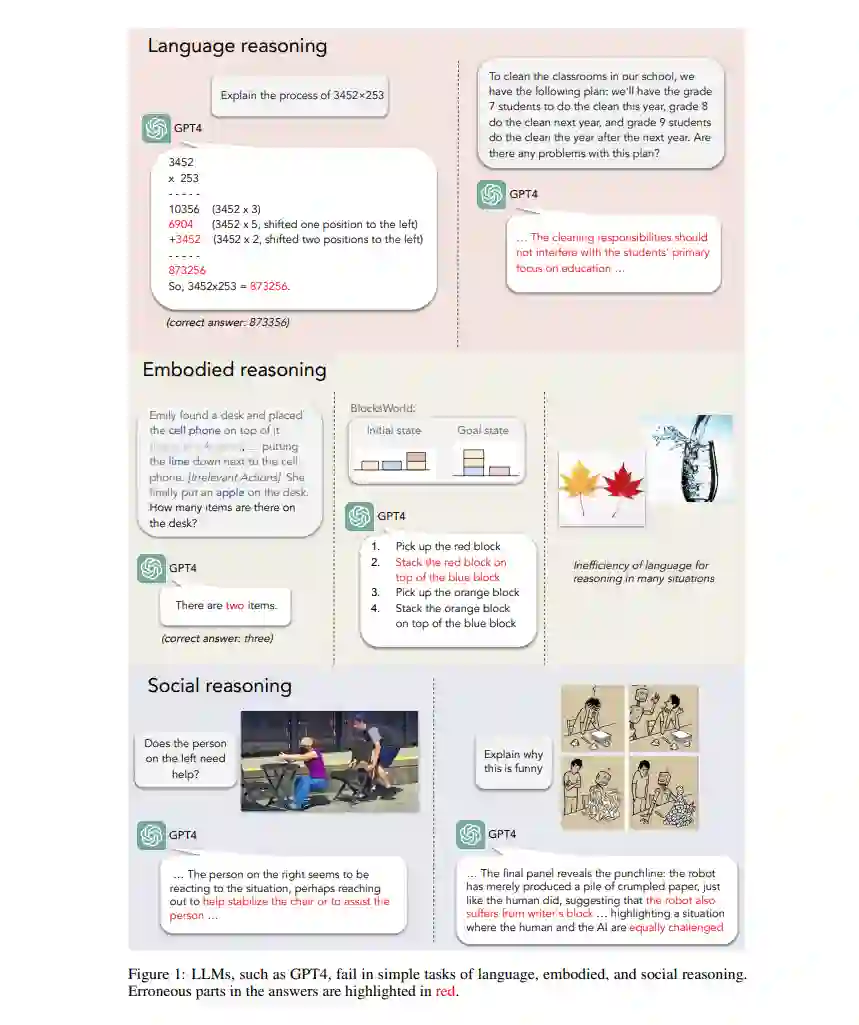

大型语言模型(LLMs)是迄今为止人类构建的最强大的智能机器之一。它们擅长根据给定的文本(或多模态)输入生成自然语言的延续。自然语言是人类描述世界、表达思想和相互交流的灵活手段。LLMs,经过训练,吸收了人类所产生的大量文本中传达的大部分知识,包括世界的因果结构(如“一个瓶子被推,水便流出来”的句子所表达的),对各种主题的推理、科学理论、信仰、文化规范等。 另一方面,LLMs在一致的推理和规划上常常有所不足,有时在人类觉得简单的任务上意外地失败。图1展示了在不同推理场景中的这类例子。这些失败实例突显了基于LLMs的机器推理的几个根本限制: 首先,自然语言文本通常是模糊且不精确的。造成这种模糊和不精确的一个关键原因是,人类在产生文本时所依赖的丰富上下文通常缺失。这种上下文包括人类代理人所处的特定感知和社会情境、他们的心理状态(例如,意图、信念和思维过程)以及世界常识。因此,LLMs只学习模仿表面文本而不建模潜在的上下文,缺乏对物理、社会和心理经验的基础。 LLMs的另一个核心局限来自于语言作为在某些情况下进行推理的媒介的低效性(图1,体现推理)。例如,表达两片树叶之间所有微妙的区别可能需要一段冗长的文本段落。相比之下,生成视觉上代表这些树叶的图像可能更为高效,只需几个像素。同样,使用其他感官模式(例如,视频)通常比依靠语言来描述直观物理学更为直接,如基于其粘度和周围障碍物预测流体流动。

这些局限性进一步被LLMs的推理过程所加剧。它们通过从左到右自回归地、逐标记地生成文本来进行推理,类似于人类的第一系统(System-I)直觉思维。人类的第二系统(System-II)推理与LLM推理形成鲜明对比。特别是,人类拥有世界的心智模型。我们头脑中的“世界模型”使我们能够模拟行动及其对世界状态的影响,从而在复杂任务中进行稳健推理(Tolman, 1948; Briscoe, 2011; Battaglia et al., 2013; Allen et al., 2020; Pramod et al., 2020)。例如,在规划实现目标时,我们使用内部世界模型来思考我们可以采取的不同行动,并预测每个选择的可能结果。这种结果的预测反过来有助于改进行动计划,以更好地实现目标。这一决策过程由位于世界模型之上的“代理模型”所控制。此外,在社会推理任务中,人类代理人还使用他们对其他代理人的信念。例如,在对话过程中,代理人需要推断他人的意图和他们可能的反应,以决定最合适的言语。因此,人类通过由其内部世界和其他代理人模型指导的深思熟虑的规划实现他们的目标并成功与他人互动。

人类代理人还展现出比LLMs更丰富的学习机制。如图1所示(体现/社会推理),仅用大规模文本语料库训练的LLMs缺乏基本的现实世界经验,如跟踪和与对象互动、理解现实世界物理和时空关系、感知和跟踪世界状态、识别其他代理的行为等。人类代理人通过与环境的互动学习来绕过这些限制。例如,我们通过尝试任务并获得反馈来获取新知识(例如,厨师通过尝试不同的食材并品尝结果来完善他们的烹饪技巧),或者仅仅通过随机探索周围环境(例如,一个孩子通过随机拾起各种物体来了解不同的质地和感觉)。

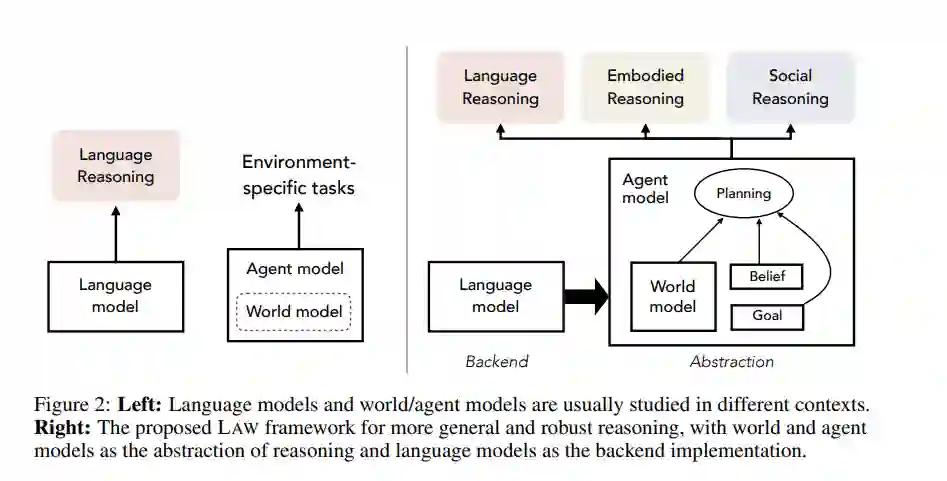

总而言之,当前LLM的推理和规划在推理(自回归生成)、学习(未经真实世界互动的数据语料库模仿)和建模(语言的低效率及其缺乏基础)方面面临关键限制。在这篇立场论文中,我们提出了一种更通用和稳健的机器推理的新视角,适用于语言、体现、社会以及其他广泛场景。特别是,受到上述讨论的启发,我们提出了一种统一的LAW机器推理框架,将语言模型、代理模型和世界模型的概念联系起来(图2,右侧)。

具体而言,世界和代理模型的概念源于认知科学和发展心理学(例如,Tolman, 1948; Premack and Woodruff, 1978; Johnson-Laird, 1983, 2010; Gentner and Stevens, 2014; Nortmann et al., 2015; Maus et al., 2013; Forrester, 1971; Gopnik and Wellman, 1994; Gergely and Csibra, 2003; Spelke and Kinzler, 2007; Battaglia et al., 2013; Baker et al., 2009; Jara-Ettinger et al., 2016; Baker et al., 2017)。如前所述,世界模型(§2.2)是代理人用来理解和预测周围外部世界的心理表征;代理模型(§2.3)包含世界模型以及其他关键组件,包括代理的目标以及对当前世界状态和其他代理的信念。这些组件共同塑造了代理的认知过程,使其能够进行深思熟虑的推理和规划。在人工智能和机器学习领域,世界和代理模型通常在强化学习和机器人技术的背景下研究(例如,Toussaint, 2003; Schulkin, 2012; Ha and Schmidhuber, 2018; Berkenkamp et al., 2017; Clavera et al., 2018; Zhang et al., 2019; Kaiser et al., 2019; Moerland et al., 2023; LeCun, 2022)。例如,最近的研究表明,世界建模使代理能够在特定游戏和体现控制问题中制定有效的行动计划(Schrittwieser et al., 2020; Hafner et al., 2020)。

在这篇论文中,我们强调了将语言模型与世界和代理模型结合起来的巨大新机遇,以实现单独公式无法实现的更通用推理能力。特别是,与当前基于LM的推理范式相比,我们认为世界和代理模型是机器推理的更好抽象,因为它们天生包含了人类推理所必需的基本组成部分——例如,信念、目标、对后果的预期和深思熟虑的规划(图2,右侧)。在这个框架中,LMs是实现世界/代理模型或各个组成部分的一种方式。也就是说,LMs作为实现这一框架的后端。与传统的实现方式相比,LMs提供了处理广泛多样的推理场景所需的计算能力和适应性。另一方面,LMs在LAW推理框架中的新角色也突显了它们的局限性,并激发了改进的未来研究。 在接下来的章节中,我们首先分别简要介绍这三种模型的背景(§2)。然后,我们介绍新的LAW推理框架(§3),其中我们回顾了与框架中每个元素相关的新兴研究,并讨论了应对现有方法固有挑战的路线图,以实现更先进的机器推理和规划。