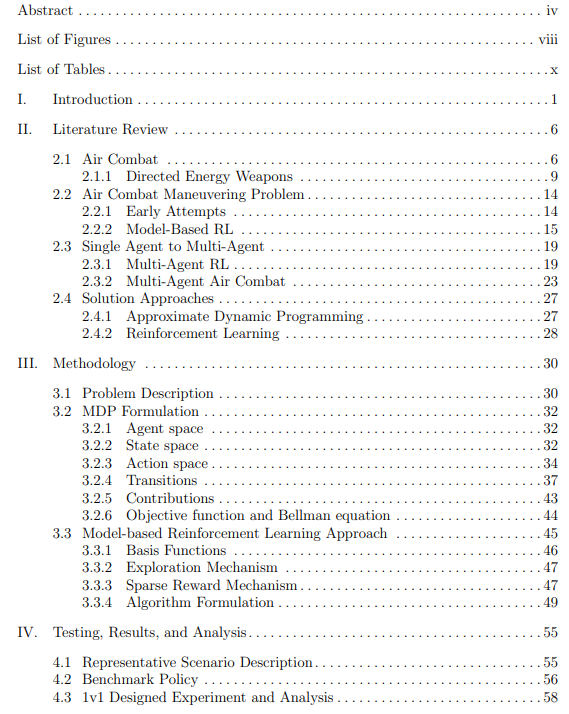

在可视范围内执行空战,需要飞行员在接近1马赫的飞行速度下,每秒钟做出许多相互关联的决定。战斗机飞行员在训练中花费数年时间学习战术,以便在这些交战中取得成功。然而,他们决策的速度和质量受到人类生物学的限制。自主无人驾驶战斗飞行器(AUCAVs)的出现利用了这一限制,改变了空战的基本原理。然而,最近的研究集中在一对一的交战上,忽略了空战的一个基本规则--永远不要单独飞行。我们制定了第一个广义的空战机动问题(ACMP),称为MvN ACMP,其中M个友军AUCAVs与N个敌军AUCAVs交战,开发一个马尔可夫决策过程(MDP)模型来控制M个蓝军AUCAVs的团队。该MDP模型利用一个5自由度的飞机状态转换模型,并制定了一个定向能量武器能力。状态空间的连续和高维性质阻止了使用经典的动态规划解决方法来确定最佳策略。相反,采用了近似动态规划(ADP)方法,其中实施了一个近似策略迭代算法,以获得相对于高性能基准策略的高质量近似策略。ADP算法利用多层神经网络作为价值函数的近似回归机制。构建了一对一和二对一的场景,以测试AUCAV是否能够超越并摧毁一个优势的敌方AUCAV。在进攻性、防御性和中立性开始时对性能进行评估,从而得出六个问题实例。在六个问题实例中的四个中,ADP策略的表现优于位置-能量基准策略。结果显示,ADP方法模仿了某些基本的战斗机机动和分段战术。

成为VIP会员查看完整内容