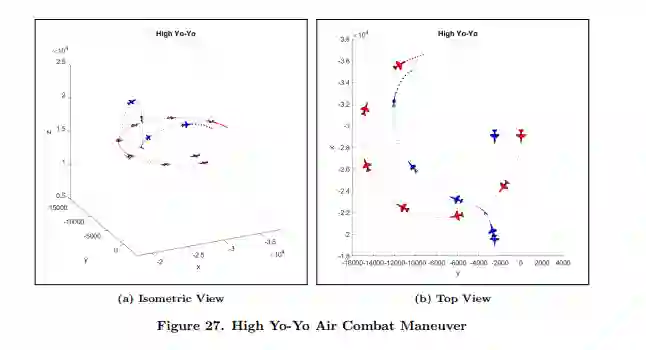

在可视范围内的空战涉及执行高度复杂和动态的活动,需要快速、连续的决策以生存和击败对手。战斗机飞行员花费数年时间来完善交战战术和机动动作,然而不断出现的无人自主飞行器技术引起了一个自然的问题--自主无人作战飞行器(AUCAV)能否被赋予必要的人工智能,以独立完成具有挑战性的空战机动任务?我们制定并解决了空战机动问题(ACMP),开发了一个马尔可夫决策过程(MDP)模型来控制一个寻求摧毁对手飞行器的AUCAV。该MDP模型包括一个5自由度、点质量的飞机状态转换模型,以准确表示机动时的运动学和能量。ACMP中状态空间的高维和连续性质使得经典的解决方法无法实施。相反,我们提出了一种近似动态规划(ADP)方法,其中我们开发并测试了一种近似的策略迭代算法,该算法实现了神经网络回归,以实现AUCAV的高质量机动策略。为了计算测试的目的,我们指定了一个有代表性的拦截场景,其中AUCAV的任务是保卫一个责任区,必须与试图穿透保卫空域的敌方飞机交战并摧毁它。进行了几个设计实验,以确定飞机特性和对手的机动战术如何影响拟议ADP解决方案的功效。此外,设计的实验使高效的算法超参数调整成为可能。ADP生成的策略与目前ACMP文献中发现的两个公认的基准机动策略进行了比较,一个只考虑位置,一个同时考虑位置和能量。在调查的18个问题实例中,ADP策略在18个实例中的15个超过了只考虑位置的基准策略,在18个实例中的9个超过了位置-能量基准策略,在最能代表典型空中拦截交战的问题实例中获得了更好的杀伤概率。作为一个有趣的探索,以及对我们方法的定性验证,由ADP策略产生的机动与标准的、基本的战斗机机动和常见的特技飞行机动进行了比较。结果表明,我们提出的ADP解决方法产生了模仿已知飞行动作策略。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年8月11日