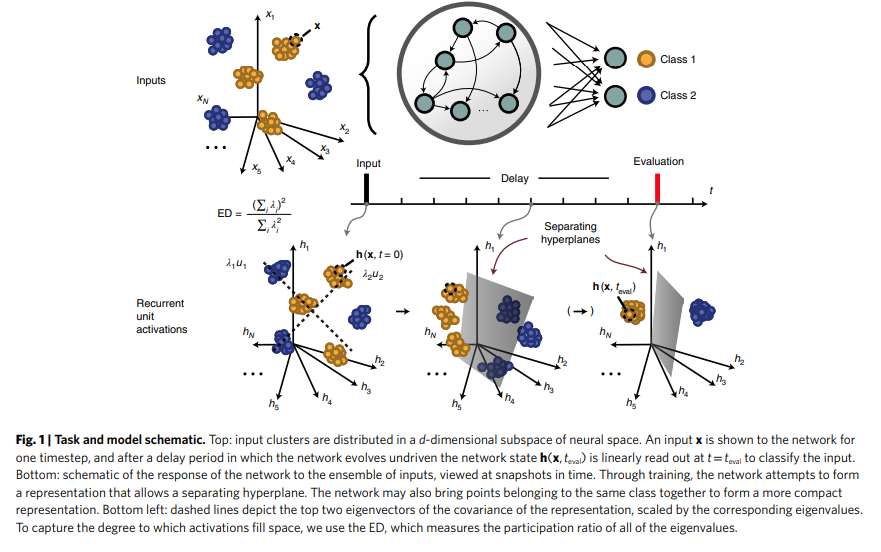

神经网络需要输入数据的正确表示来学习。在这里,我们问基于梯度的学习如何塑造递归神经网络(RNNs)表示的基本属性——它们的维度。通过模拟和数学分析,我们展示了梯度下降如何导致RNN压缩其表示的维度,以匹配训练期间的任务要求,同时支持对未见示例的泛化。这可能需要在早期的时间步中扩展维度,在后期的时间步中压缩维度,而强混沌的RNN似乎特别擅长学习这种平衡。除了有助于阐明适当初始化的人工循环神经网络的力量外,这一事实对神经生物学也有影响。大脑中的神经回路显示了与混沌和低维动力学结构相关的高可变性。综上所述,我们的研究结果表明,简单的基于梯度的学习规则如何引导神经网络解决具有鲁棒表示的任务,从而泛化到新情况。

成为VIP会员查看完整内容

相关内容

专知会员服务

44+阅读 · 2020年6月29日

Arxiv

0+阅读 · 2022年8月12日

Arxiv

20+阅读 · 2020年3月10日