人工智能(AI)研究人员经常对训练机器学习系统的最佳策略存在分歧,但有一个信念是普遍认可的:人类仍然比机器更擅长学习。与人工智能系统不同,人类不会通过观察独立的和同分布的例子从头开始学习具有挑战性的新任务(例如,解微分方程)。相反,人类通常遵循一系列步骤,使他们能够逐步建立执行这些新任务的必要技能。课程学习(CL)是一项尝试将这种人类学习方法融入机器学习的工作,希望通过这种方式训练的机器可以学习得更快,表现得更好。然而,生物大脑不同于硅大脑,并没有使用已成为机器学习规范的梯度下降法进行训练。那么,我们能指望人类的学习策略对电脑也有效吗?过去20年的各种研究证据表明,在某些情况下,CL确实有利于机器学习,而在另一些情况下,它实际上可能会阻碍性能(Elman, 1993; Rohde and Plaut, 2003; Bengio et al., 2009; Bojar et al., 2017b)。在这篇论文中,我们的目的是发现不同形式的语言学习在哪些问题设置中是有益的,以及它们提供的好处的类型。我们提出以下声明:像人类一样学习的AI系统,从简单的问题开始,逐渐解决越来越难的问题,有潜力达到更好的局部最优和/或更快地收敛。此外,使用课程获得的学习收益取决于课程的选择、数据的大小和类型以及模型架构。

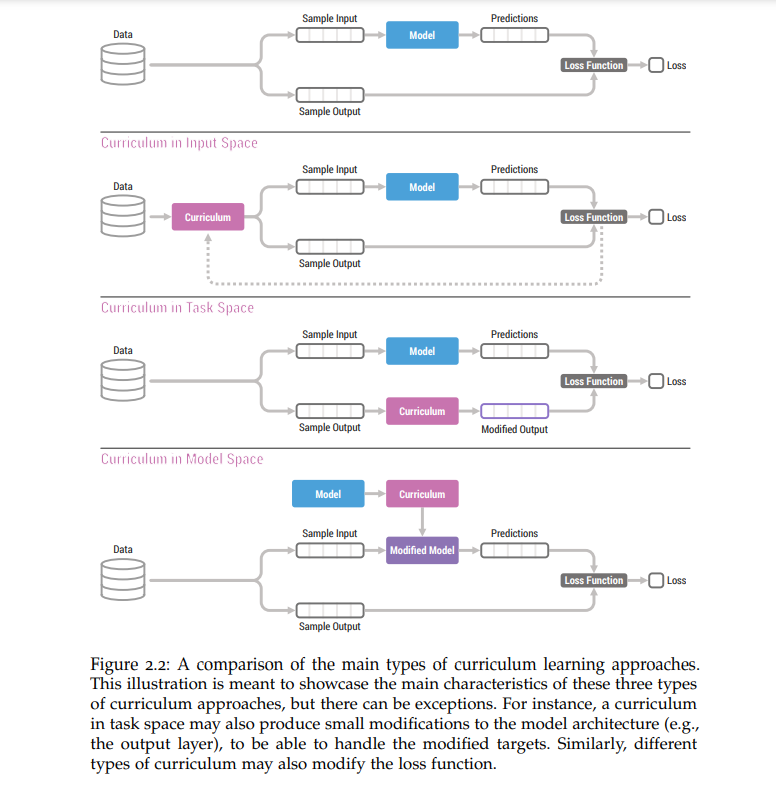

在这项工作中,我们为这种说法提供了证据,并调查了什么类型的数据和模型可以受益于CL。我们首先介绍了CL的定义,并确定了CL方法的三大类。我们进一步提供了文献综述的主要CL方法在过去三十年。此外,我们提出了新的CL方法,并将其应用于各种模型和问题设置,从教学一个LSTM来解决基本的算术问题,到使用变形金刚的神经机器翻译,使用卷积神经网络的图像分类,以及组合多任务学习问题。通过这些实验,我们观察到,如果设计良好,语言学习在某些环境下(如句子等连续数据)是非常有益的,但如果表现不好,它也会损害学习效率(如,如果课程在简单问题上花费太多时间)。最后,我们进行分析,以理解为什么CL会导致观察到的效果。