科学家可能需要几十年的时间来确定物理定律,从重力如何影响物体,到为什么能量不能被创造或破坏。

美国普渡大学(Purdue University)的研究人员提出

简约神经网络(parsimonious neural networks,PNN),将神经网络与进化优化相结合,以找到平衡精度与简约的模型,可将物理定律发现的时间缩短到几天。

该研究是使用机器学习从数据中发现物理定律的首批演示之一,该工具可通过 nanoHUB 在线获取。

该研究以「Parsimonious neural networks learn interpretable physical laws」为题,发表在《Scientific Reports》上。

机器学习(ML)在物理科学中发挥着越来越重要的作用,并且在将领域知识嵌入模型方面取得了重大进展。

在物理科学中使用 ML 的主要缺点之一是,模型通常无法学习「手头」系统的基本物理特性,例如约束或对称性,从而限制了它们的泛化能力。此外,大多数 ML 模型缺乏可解释性。在许多领域,这些限制可以通过大量数据得到补偿,但在材料科学等领域,获取数据既昂贵又耗时,这通常是不可能的。

为了应对这一挑战,在使用基础物理学知识来提高模型的准确性和/或减少训练期间所需的数据量方面取得了进展。

较少探索的是使用 ML 进行科学发现,即从观测数据中提取物理定律。

在这里,研究人员提出简约神经网络 (PNN),将神经网络与进化优化相结合,以找到平衡准确性和简约性的模型。

以神经网络为起点,找到简约神经网络作为以尽可能最简单的方式解释数据的网络。

通过开发经典力学模型并从基本特性预测材料的熔化温度,证明了该方法的强大功能和多功能性。

两个例子

作为第一个例子,考虑在有和没有摩擦的外部 Lennard Jones (LJ) 势下粒子的动力学。

前馈神经网络(FFNN)能够很好地匹配训练/验证/测试数据,然而,该网络的预测能力很差。且这些 FFNN 是不可解释的。

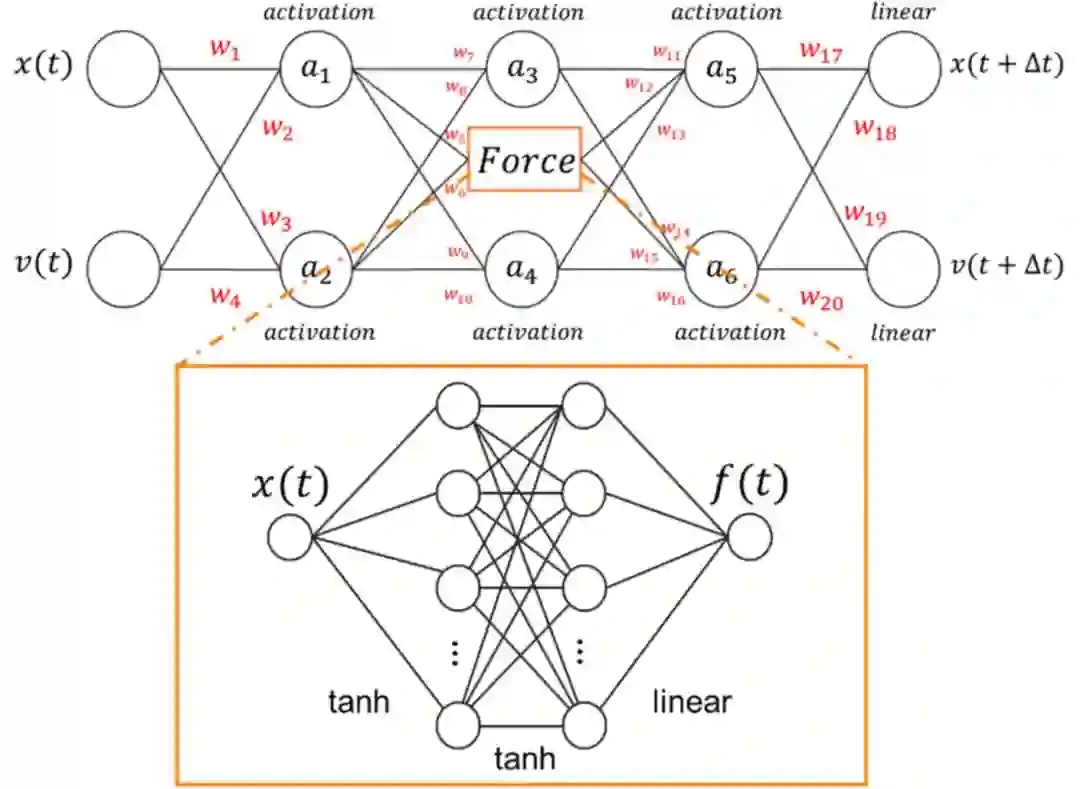

在确定了 FFNN 的缺点之后,引入了简约神经网络 (PNN)。从通用神经网络开始,并使用遗传算法找到具有可控简约性的模型。神经网络由三个隐藏层和一个输出层组成,输出层有两个值,粒子的位置和速度比输入提前一个时间步。

起始神经网络提供了从输入位置和速度到输出位置和速度的高度灵活的映射,PNN 力求在再现训练数据时平衡简单性和准确性。在此示例中,考虑了四种可能的激活函数:线性、线性整流函数 (relu)、双曲正切 (tanh) 和指数线性单元 (elu)。

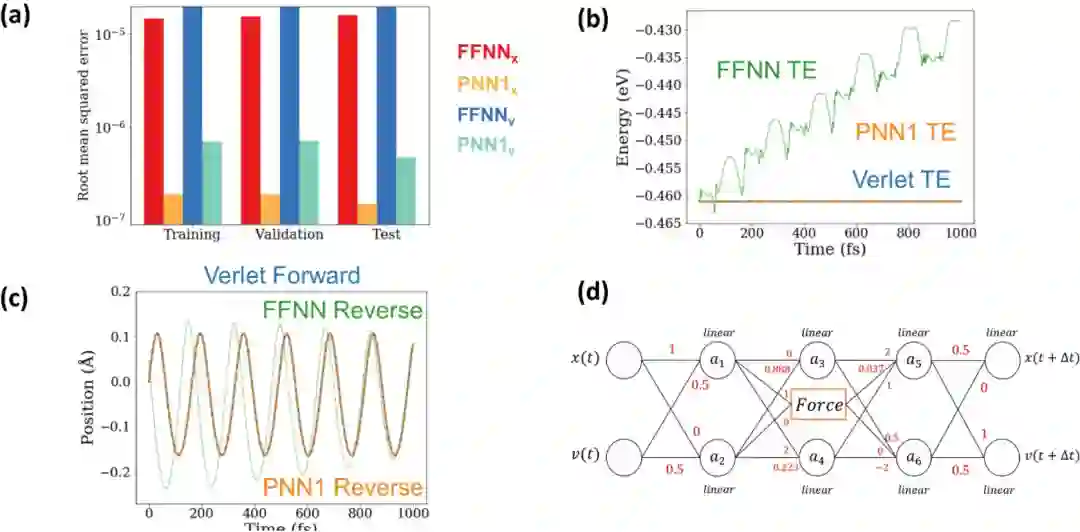

(a) 训练/验证/测试集上的 PNN 模型 1 RMSE 与前馈网络相比 (b) 我们看到 PNN1 和 verlet 积分器之间的能量守恒是可比的(TE:总能量)(c)前向 PNN1 生成的反向轨迹显示出良好的可逆性 (d) 遗传算法发现的 PNN 模型 1 的可视化,试图提前一步预测位置和速度。

由 p = 1 的遗传优化产生的 PNN 比架构复杂的 FFNN 更准确地再现训练、验证和测试数据。值得注意的是,最佳 PNN(PNN1)还具有出色的长期能量守恒和时间可逆性。PNN1 学习了时间可逆性和总能量是一个运动常数。这与物理不可知的 FFNN 甚至像一阶欧拉积分这样的基于物理的简单模型形成鲜明对比。

在第二个例子中,PNN 学习经典力学,摩擦力与速度成正比,并基于位置 Verlet 方法发现相同的稳定积分器,全部来自观测数据。

Verlet 风格积分器的出现来自数据显着。由于其稳定性,该积分器系列是分子动力学模拟的首选。重要的是,研究人员发现了更复杂的模型,它们比 PNN1 更准确地再现数据,但不表现出时间可逆性,也不节约能量。这表明简约对于学习可以深入了解「手头」物理系统和通用性的模型至关重要。

为了证明 PNN 的多功能性和通用性,研究人员将其应用于从实验数据中发现熔化定律。目标是从基本的原子和晶体特性预测材料的熔化温度。

为此,收集了 218 种材料(包括氧化物、金属和其他单元素晶体)的实验熔化温度以及基本物理量。

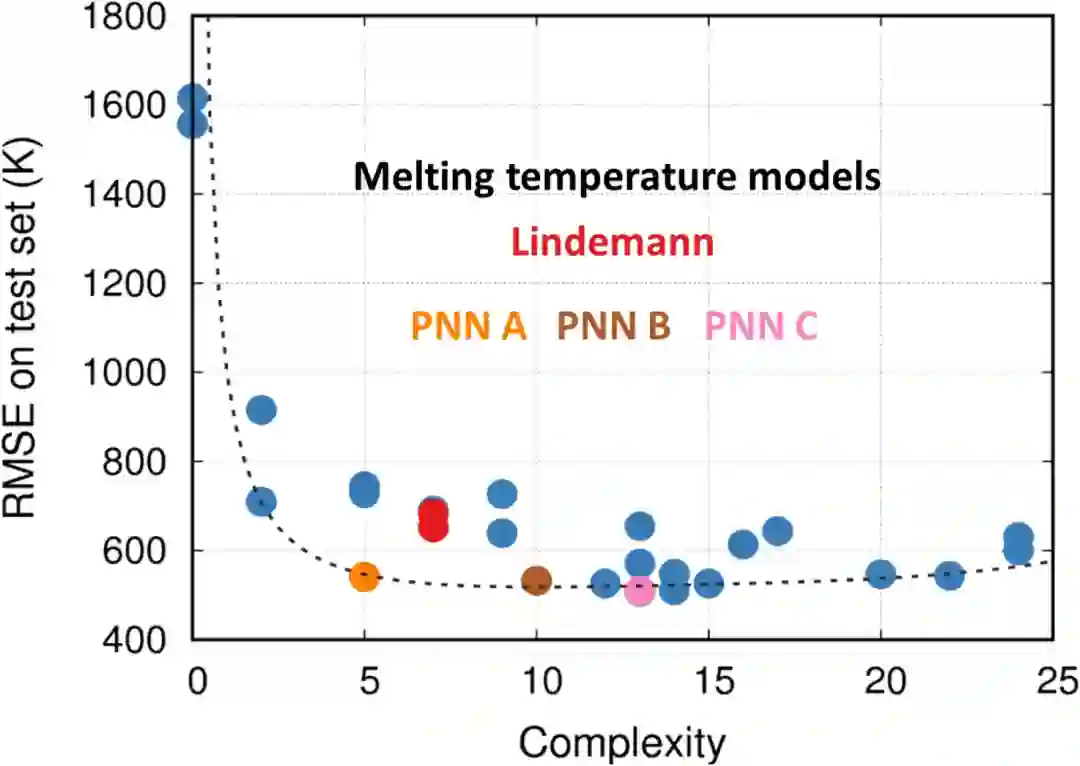

PNN 发现的熔化定律。(红点表示著名的林德曼定律,而蓝点表示发现的其他模型。黑色虚线表示模型的帕累托前沿,其中一些模型比林德曼定律表现更好,同时也更简单。树模型被突出显示和标记。)

PNN 模型代表了准确性和简约性之间的各种权衡,从中我们可以定义最佳模型的帕累托前沿。PNN 方法找到了几个简单而准确的表达式。最简单的非平凡关系由 PNN A 给出,它近似熔化温度与德拜温度成正比:

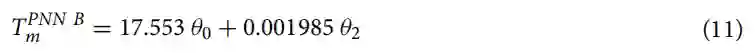

这在物理上是有意义的,因为德拜温度与特征原子振动频率有关,而更硬和更牢固的键往往会导致更高的德拜温度和熔化温度。接下来是复杂性,PNN B 添加了与剪切模量成正比的校正:

这也是物理意义上的,因为剪切刚度与熔化密切相关。PNN 的复杂性略高于 PNN B,发现著名的林德曼熔化定律。

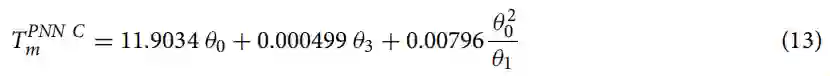

这里 TD 是材料的德拜温度,f 和 C 是经验常数。值得注意的是,这条定律是在 1910 年使用物理直觉推导出来的,它非常接近,但不是在精度-复杂度空间中的最优帕累托前沿。为了完整起见,描述了具有最低 RMS 误差的模型,PNN C 预测熔化温度为:

非常有趣的是,该模型将林德曼表达式与德拜温度和体积(非剪切)模量相结合。考虑到上述表达式,这种组合并不令人惊讶,但此时体积与剪切模量的选择尚不清楚,应进一步探索。

总之,

研究人员提出了能够从数据中学习可解释物理模型的简约神经网络;重要的是,它们可以提取当前问题的潜在对称性,并提供物理洞察力。

这是通过平衡精度与简约来实现的,可调节参数用于控制这两项的相对重要性并生成一系列帕累托最优模型。未来的工作应该探索其他复杂性度量。

论文链接:https://www.nature.com/articles/s41598-021-92278-w

工具地址:https://nanohub.org/resources/pnndemo

参考内容:https://techxplore.com/news/2021-12-scientists-physical-laws-faster-machine.html

人工智能 × [ 生物 神经科学 数学 物理 材料 ]

「ScienceAI」关注人工智能与其他前沿技术及基础科学的交叉研究与融合发展。

欢迎关注标星,并点击右下角点赞和在看。

点击阅读原文,加入专业从业者社区,以获得更多交流合作机会及服务。