BloombergGPT在金融NLP任务上的表现明显优于类似规模的公开模型,而不牺牲通用LLM基准的性能

彭博社今天发布了一篇研究论文,详细介绍了一种新的大规模生成人工智能(AI)模型BloombergGPT的开发。这个大型语言模型(LLM)经过广泛的金融数据专门训练,以支持金融行业中各种各样的自然语言处理(NLP)任务。

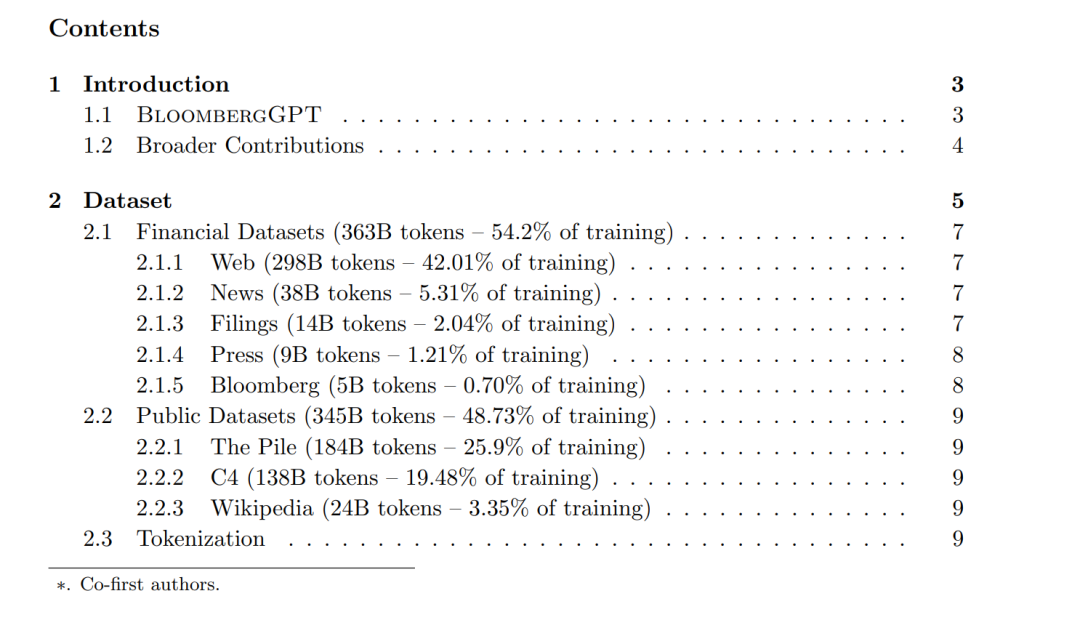

NLP在金融技术领域的使用是广泛而复杂的,其应用范围从情感分析、命名实体识别到问答。大型语言模型(LLMs)已被证明在各种任务中是有效的;然而,文献中还没有专门针对金融领域的LLM的报道。**在这项工作中,我们提出了BloombergGPT,这是一个500亿参数的语言模型,它是在广泛的金融数据上训练的。**基于Bloomberg的广泛数据源构建了一个3630亿token数据集,这可能是迄今为止最大的特定领域数据集,由来自通用数据集的3450亿token增强。我们在标准LLM基准、开放金融基准和一套最准确反映我们预期用途的内部基准上验证了BloombergGPT。**混合数据集训练的模型在金融任务上明显优于现有模型,而不牺牲在一般LLM基准上的性能。**此外,还解释了模型选择、训练过程和评估方法。下一步,我们计划发布训练日志(编年史),详细介绍我们在训练BloombergGPT方面的经验。

1.介绍

**GPT-3于2020年发布(Brown et al., 2020),展示了训练超大型自回归语言模型(LLM)的强大优势。**GPT-3有1750亿个参数,比之前的GPT-2模型增加了100倍,并且在广泛的现在流行的LLM任务中表现得非常好,包括阅读理解、开放式问答和代码生成。这种性能在其他几个模型中得到了复制(Chowdhery et al., 2022;Scao等人,2022;张等,2022a)。此外,证据表明,大型模型表现出突现行为;成长允许它们获得较小模型中不存在的能力(Wei等人,2022a)。突现行为的一个显著例子是通过少样本提示执行任务的能力,其中模型可以从几个示例中学习任务。当我们增加语言模型的规模时,这种能力比随机提高得多得多。一般来说,少样本提示极大地扩展了模型支持的任务范围,并降低了寻求新语言任务自动化的用户的进入门槛。 在GPT-3之后,模型的规模增长到2800亿(Gopher, Rae等人,2021年)、5400亿(PaLM, Chowdhery等人,2022年)和1万亿参数(Megatron, Korthikanti等人,2022年)。工作还探索了实现高性能LLM的其他重要方面,如不同的训练目标(Tay等人,2022b),多语言模型(Scao等人,2022),更高效和更小的模型(Black等人,2022),以及寻找数据和参数有效的训练规模(Hoffmann等人,2022)。

这些努力几乎完全集中在通用LLM上,在涵盖广泛主题和领域的数据集上进行训练。虽然这些包括了一些专门领域的数据集(例如,代码(Chen et al., 2021a)或生物医学文章Gao et al.(2021)),但重点是构建具有广泛功能的llm。最近的工作仅使用特定领域的数据训练模型,已产生的模型虽然小得多,但在这些领域内的任务上击败了通用llm,如science Taylor等人(2022)和medicine Bolton等人(2023);Luo et al. (2022);Lehman et al.(2023)。这些发现激励了专注于特定领域的模型的进一步发展。

金融科技(FinTech)是一个庞大且不断增长的领域,NLP技术具有越来越重要的作用Xing et al. (2018);Fisher et al. (2016);Dredze et al.(2016)。金融NLP任务Shah等人(2022)包括情感分析Araci(2019)、命名实体识别Salinas Alvarado等人(2015)、新闻分类Sinha和Khandait(2020)以及问答Chen等人(2021b, 2022)。虽然任务的范围与一般NLP基准中发现的任务相似,但金融领域的复杂性和术语保证了一个特定领域的系统。由于所有的原因,生成式LLM通常是有吸引力的-少样本学习,文本生成,会话系统等-有一个专注于金融领域的LLM将是有价值的。虽然有针对金融领域Araci(2019)调优的掩码语言模型,但还没有针对该领域的任务进行调优或评估的LLM。

1.1 BloombergGPT

**我们训练BloombergGPT,这是一个500亿参数的语言模型,支持金融行业内广泛的任务。**我们采用混合的方法,而不是建立一个通用的LLM,或专门在特定领域的数据上建立一个小型的LLM。通用模型涵盖许多领域,能够在各种各样的任务中进行高水平的执行,并在训练期间避免了专业化的需要。**然而,现有特定领域模型的结果表明,通用模型无法取代它们。**在彭博社,我们支持一组非常庞大和多样化的任务,通用模型很好地服务于我们,但我们的绝大多数应用都在金融领域内,由特定模型更好地服务。出于这个原因,我们开始构建一个模型,该模型在金融基准上取得了同类中最好的结果,同时也在通用LLM基准上保持有竞争力的表现。

通过构建迄今为止最大的特定领域数据集,利用Bloomberg现有的数据创建、收集和策展资源,实现了这一目标。由于Bloomberg主要是一家金融数据公司,我们的数据分析师已经收集和整理了40多年的金融语言文档。我们拥有广泛的金融数据档案,涵盖了一系列的主题,并对数据来源和使用权进行了仔细的跟踪。我们将这些数据添加到公共数据集,以创建一个拥有超过7000亿token的大型训练语料库。使用该训练语料库的一部分,我们训练了一个bloom风格的500亿参数模型,该模型是根据Hoffmann等人(2022)和Le Scao等人(2022)的指导方针设计的。我们在标准的LLM基准、开放的金融基准和一套最准确地反映我们预期用例的彭博内部基准上验证了该模型。我们的结果表明,我们的混合训练方法产生了一个模型,该模型在域内金融任务上大大超过现有模型,同时在一般NLP基准上持平或更好。

1.2 更广泛的贡献

除了为金融数据构建LLM,我们的目标是为更广泛的研究社区做出贡献。具体来说,本文中记录的我们的经验提供了证据,进一步发展了社区对文献中几个开放问题的理解。

**特定领域的LLM。**现有的少数特定领域的llm专门在特定领域的数据源上进行训练(Luo等人,2022;Bolton等人,2023;Taylor et al., 2022),或将一个非常大的通用模型适应于特定领域的任务(Singhal et al., 2022;Lewkowycz et al., 2022)。我们的替代方法-在特定领域和一般数据源上训练LLM -迄今尚未被研究。由此产生的模型在特定领域的任务上表现非常好,但也在通用基准上保持了强大的性能。

**训练数据。**几乎所有的语言模型在很大程度上都依赖于网络抓取的数据,例如C4 (Raffel等人,2020)和Pile (Gao等人,2021)(其中包括OpenWebText2)。在使用Touvron et al.(2023)之前,这些数据可能会以各种方式进行清洗或子集化;Rae et al. (2020);Scao等(2022);Jernite et al.(2022),但数据重复Carlini et al.(2020)和有毒语言的问题仍然是Welbl et al.(2021)。我们的训练数据对于LLM训练来说不同寻常,因为它包括大量来自可靠来源的策划和准备的数据。

**评估。**LLM评估仍然是一个具有挑战性且不断发展的问题Gehrmann et al. (2022);Goyal et al.(2022),新的基准试图将评估标准化模型(Liang等,2022;Srivastava et al., 2022)。然而,对于特定领域的任务,评估和实际用例之间仍然存在不匹配。评估是建立在可用的数据集上,而不一定是建立在模型将如何在实践中使用上。我们提供了两个公共金融NLP基准的结果(Shah等人,2022;Chen et al., 2021b)以及选择的彭博内部任务,这些任务与我们预期的用例更好地吻合,并直接评估我们的模型执行感兴趣任务的能力。

**模型的尺寸。**早期的LLM对2000 - 4000亿token的语料库进行了一次训练(Brown et al., 2020), Hoffmann et al.(2022)假设模型训练不足,而是专注于训练具有更多数据的较小模型,这是Touvron等人最近采用的一种策略(2023)。我们选择了由Hoffmann等人(2022)驱动的模型大小,并在我们超过7000亿token的语料库中的5690亿token上训练一个500亿参数模型,以产生一个与更大的模型竞争的模型。

**分词器。**在组装训练数据之后,tokenization的关键步骤是将文本转换为适合语言模型的格式。这一步的重要性经常被忽视Mielke et al.(2021),许多较老的llm使用相同的分词器和词汇表,这意味着我们几乎没有证据支持其他分词器。我们采取了一种不同的方法,使用Unigram模型而不是贪婪的基于合并的子词分词器,因为它节省了概率,允许在推理时进行更智能的分词(Kudo, 2018)。

**模型构建的挑战。**GPT-3和后续的模型是大型团队的工作,需要大量的计算。重现这些结果的初始工作,如OPT Zhang et al. (2022a),并没有匹配原始模型的性能。随着每个后续模型的发布,社区的理解、经验和软件工具都在增加。在开发BloombergGPT时,我们受益于作为BLOOM努力Scao et al.(2022)一部分开发的现有代码,表明一个中等规模的团队可以在特定领域的数据上产生具有竞争力的模型。我们详细描述了我们培训BloombergGPT的经验,以支持未来的培训工作,并解决上述每个主题。

参考链接:

https://www.bloomberg.com/company/press/bloomberggpt-50-billion-parameter-llm-tuned-finance/