大型语言模型(LLMs)在自然语言处理(NLP)领域凭借其出色的语言理解和生成能力取得了显著进步。然而,由于受限于领域特定知识和词汇的接触,它们在长尾或领域特定任务的表现可能不尽如人意。此外,大多数最先进的(SOTA)LLMs缺乏透明度,只能通过API访问,这阻碍了使用自定义数据进一步微调。而且,数据隐私是一个重要问题。为了应对这些挑战,我们提出了一种创新的参数知识引导(PKG)框架,该框架为LLMs配备了一个知识引导模块,以在运行时访问相关知识,而无需更改LLMs的参数。我们的PKG基于开源的“白盒”小型语言模型,允许将LLMs所需的任何知识进行离线存储。我们证明了我们的PKG框架可以增强“黑盒”LLMs在一系列长尾和领域特定下游任务的表现,这些任务需要事实、表格、医学和多模态知识。

https://www.zhuanzhi.ai/paper/4bf640cc7e3ca1bf060a6aafc401de8e

1. 引言

诸如GPT3 [Brown et al., 2020]的大型语言模型(LLMs)在各种自然语言处理(NLP)任务中展示出令人印象深刻的熟练程度。这些模型通常在广泛的互联网数据上进行训练,从而使它们能够将大量的隐式世界知识融入到其参数中。因此,LLMs已成为既适用于NLP研究又适用于工业应用的多功能工具。例如,它们可用于机器翻译 [Jiao et al., 2023],段落摘要 [Yang et al., 2023]和推荐系统 [Gao et al., 2023]。凭借其卓越的语言理解和生成能力,LLMs为各种工业应用提供了新的机会,如最近推出的New Bing [Microsoft, 2023]和ChatGPT插件 [OpenAI, 2023a]。 尽管在一般自然语言处理(NLP)任务上表现出色,但在长尾或领域特定任务上,LLMs可能会因受限于相关知识和词汇而难以获得最佳结果 [Chalkidis, 2023; Kasai et al., 2023; Nascimento et al., 2023]。虽然LLMs在预训练过程中获取了隐式知识,但这种知识可能对某些任务来说是有损失或不足的,导致准确度降低和效果不佳。此外,许多最先进(SOTA)的LLMs被认为是“黑箱”模型,只能通过API访问。这种缺乏透明度使得微调这些模型对大多数研究人员和公司来说变得困难和昂贵。此外,能够承担微调费用的用户必须向LLM所有者提供他们的私人数据,将其暴露于滥用、违规或其他安全威胁的风险中 [BBC, 2023]。这些限制阻碍了LLMs适应特定用例或领域的能力。

最近的研究主要集中在使用基于检索的方法从外部知识库中提取领域特定知识,以提高LLMs的性能 [Liu, 2022; Shi et al., 2023; Peng et al., 2023a]。虽然这种方法取得了有前景的结果,但它还存在一些局限性。首先,它严重依赖外部知识来源,这些来源可能并不总是容易获得或可用。此外,这些方法可能无法处理需要从多个来源或模态整合信息的复杂查询。

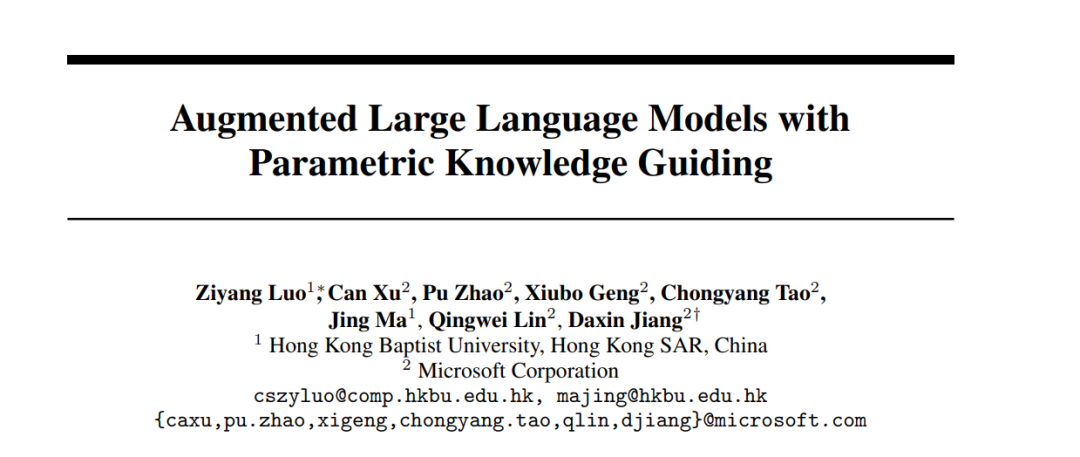

为了克服这些局限性,我们提出了一种名为参数知识引导(PKG)的新框架,它将检索替换为生成,如图1所示。PKG模块是一个额外的背景知识生成模块,使LLMs能够在运行时访问相关信息,而无需更新它们的参数。通过提供必要的知识,增强型LLMs可以在长尾或领域特定任务上取得更好的性能。

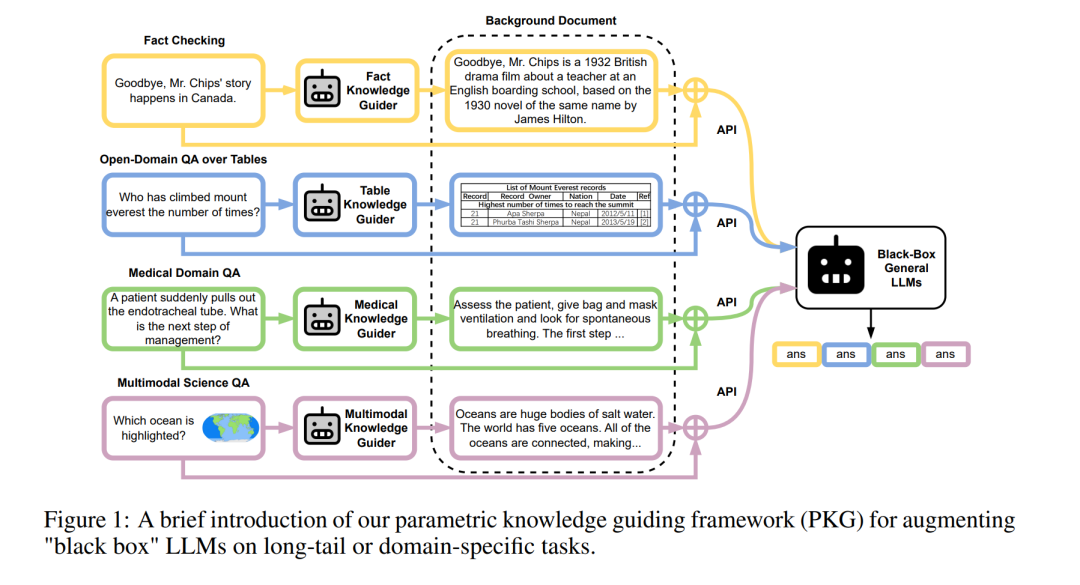

我们的PKG框架基于开源且免费使用的“白盒”小型语言模型,使其能够被更广泛的用户所使用。为了与给定任务或领域所需的特定知识保持一致,我们引入了一种基于指令微调的两步知识对齐方法 [Ouyang et al., 2022]。参数模块可以存储LLMs所需的任何知识,并且可以在离线情况下高效地进行更新。

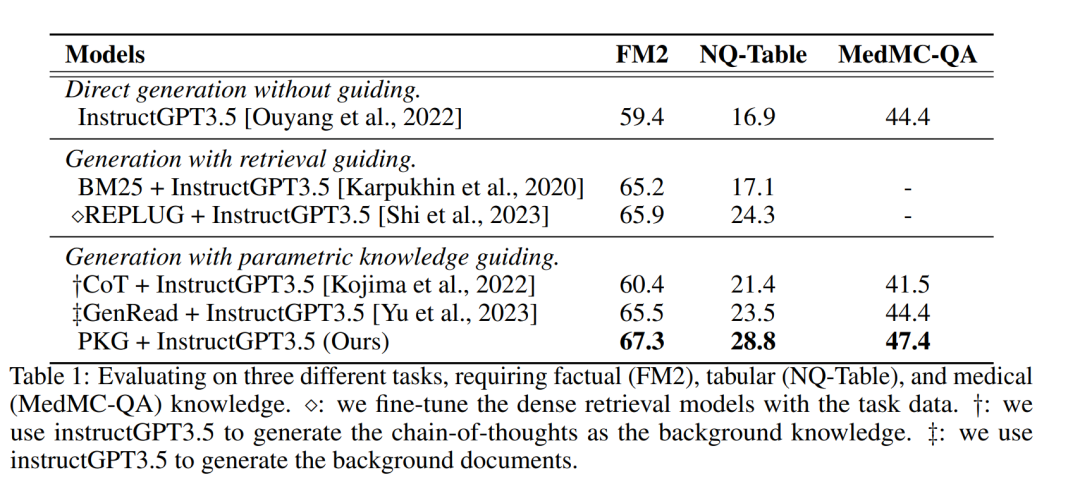

我们的实验表明,所提出的PKG框架能够提高“黑箱”LLMs在需要领域特定背景知识的各种下游任务上的性能,包括事实知识(FM2 [Eisenschlos et al., 2021], +7.9%)、表格知识(NQ-Table [Herzig et al., 2021], +11.9%)、医学知识(MedMC-QA [Pal et al., 2022], +3.0%)和多模态知识(ScienceQA [Lu et al., 2022], +8.1%)。我们将我们的贡献总结如下:

我们提出了一种创新的参数知识引导(PKG)框架,通过集成一个额外的背景知识生成模块来增强语言模型(LMs)的能力。

我们引入了一种两步知识对齐方法,将PKG模块与给定任务或领域所需的特定知识对齐。该方法基于指令微调,并使参数模块能够进行高效的离线更新。

我们对各种下游任务进行了广泛的实验,以评估我们提出的PKG框架的有效性。这些实验的结果表明,我们的PKG框架可以提高LLMs在这些任务上的能力。

2 参数化知识引导

在本节中,我们介绍了一种名为参数知识引导(PKG)的创新框架,旨在提高“黑箱”LLMs在长尾或领域特定任务上的性能。PKG利用一个离线参数知识生成模块,该模块与LLM集成,以在运行时提供相关知识,指导其推理。为实现这一目标,我们首先利用一个小型开源语言模型来高效地与领域特定知识对齐,这些知识通常是长尾的或不存在于LLM的训练数据中。然后,给定一个输入问题或句子,PKG提供相应的背景文档,扩展LLMs的输入上下文,使它们能够处理更广泛的任务。

**2.1 导引器的知识对齐 **

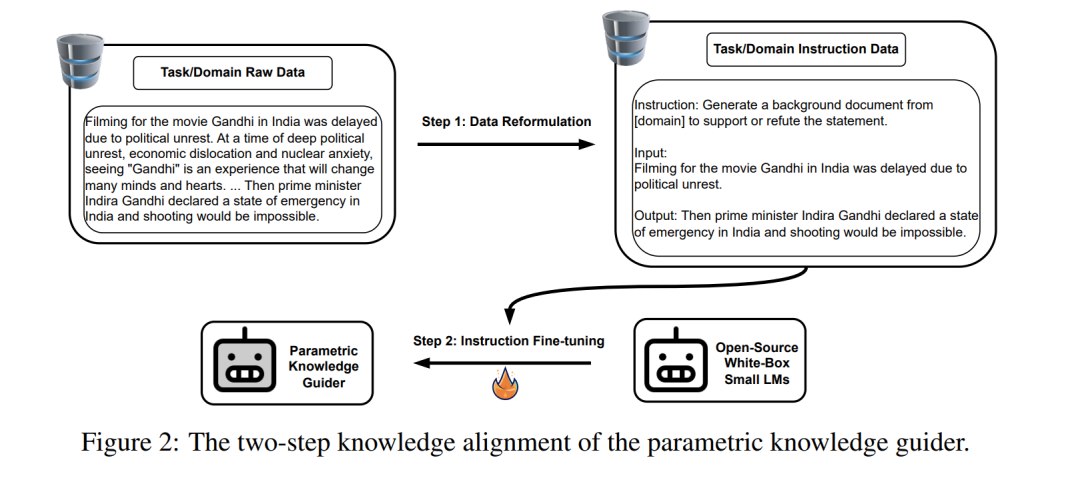

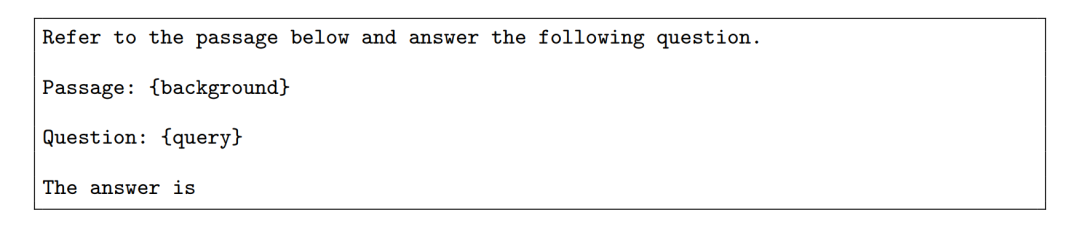

针对特定任务或领域,我们通过指令微调 [Ouyang et al., 2022] 将导引器模块与相关知识对齐。如图2所示,我们将此过程分为两个步骤。首先,我们收集有关目标任务/领域的原始数据,作为我们的知识来源。然后,我们将数据转换为一组(指令,输入,输出)三元组。指令作为输入的提示,并指导模块与预期输出对齐。接下来,采用这组三元组来调整我们的基本PKG模块,优化其为给定任务或领域的LLMs提供相关且有效指导的能力。这个过程使PKG模块能够学习并生成领域特定知识,并在运行时提供给LLMs。指令提示的示例是:

指令作为提示,指导模型提供与特定领域或任务相关的背景知识。输入是一个提示,提示模型在指定的领域或任务中生成一句话或回答问题。输出是模型基于给定指令和输入生成的相关知识。为生成输出,我们以自回归方式训练基本的导引器模块,其中模型在给定先前上下文的情况下生成输出。一旦训练完成,基本模型就会演变成参数化知识导引器,可以根据相应的指令生成特定领域/任务的背景知识。

2.2 用PKG增强LLMs

在许多情况下,使用“黑箱”LLMs的标准方法是将输入句子/问题作为提示,并请求LLMs使用API返回响应/答案。然而,这种方法对于需要超出输入本身所含知识的复杂任务可能并不有效。为了克服这个限制,一种常见的方法是为LLMs提供额外的上下文,使它们能够访问与任务相关的更多相关信息。在PKG的情况下,我们增强输入与领域特定的背景知识,扩展输入上下文。这个补充信息作为LLMs的指南,使它们能够访问更丰富的任务上下文,从而潜在地提高它们生成响应的准确性。一个增强的提示的例子是:

3 实验

在本节中,评估了所提出的PKG框架在四种不同类型的知识上的有效性:事实性、表格性、医学和多模态知识。将所提出方法的性能与几个基线方法进行了比较,表1和表2所示的结果表明,PKG比"黑盒" LLM取得了显著的改进。这些发现为所提出方法的通用性和有效性提供了令人信服的证据。