大型语言模型(LLMs)如ChatGPT具有理解用户意图和提供合理回应的能力,这使得它们近来变得非常受欢迎。在本文中,我们关注使用7个细粒度信息抽取(IE)任务来评估ChatGPT的整体能力。特别是,我们通过衡量ChatGPT的性能、可解释性、校准和忠实度,以及从ChatGPT或领域专家那里得到的15个关键点,对其进行系统分析。我们的研究发现,ChatGPT在标准信息抽取设置下的性能较差,但在开放式信息抽取设置下,它表现出了出色的性能,这一点得到了人类评估的证实。此外,我们的研究表明,ChatGPT为其决策提供了高质量和可信的解释。然而,ChatGPT在预测中过于自信,导致校准性较低。此外,在大多数情况下,ChatGPT对原文的忠实度非常高。我们手动标注并发布了包含14个数据集的7个细粒度信息抽取任务的测试集,以进一步推动研究。数据集和代码可以在此网址找到

https://github.com/pkuserc/ChatGPT_for_IE

大型语言模型(LLMs)(例如 GPT3(Brown 等,2020),LaMDA(Thoppilan 等,2022)和 PaLM(Chowdhery 等,2022)等)极大地推动了自然语言处理(NLP)领域的发展。在给定适当的指令(通常是任务定义)(Ouyang 等,2022;Kojima 等,2022;Chung 等,2022;Wang 等,2022)和思维链(CoT)提示(Wei 等,2022b)的情况下,LLMs 在处理未见过的任务时表现出令人惊讶的优秀表现。 ChatGPT 目前是最受欢迎的大型语言模型(LLM),以其令人印象深刻的理解用户意图和生成类似人类回应的能力而闻名。ChatGPT 是基于 GPT 系列(Brown 等,2020;Artetxe 等,2022;Ouyang 等,2022)采用人类反馈强化学习(RLHF)(Christiano 等,2017)和高质量对话式数据集进行训练的。除了令人惊讶的对话能力,ChatGPT 还有许多其他方面吸引了研究人员进行探索。一些研究人员深入研究了 ChatGPT 对人类生活的潜在影响(Haque 等,2022;Zhuo 等,2023;Susnjak,2022;Basic 等,2023)。其他研究人员对于探索 ChatGPT 在各种 NLP 任务中的能力感兴趣(Zhang 等,2022a;Qin 等,2023;Mitrovic 等,2023;Guo 等,2023)。通过以上研究,ChatGPT 的能力已初步得到探索,并得出了有价值的结论。

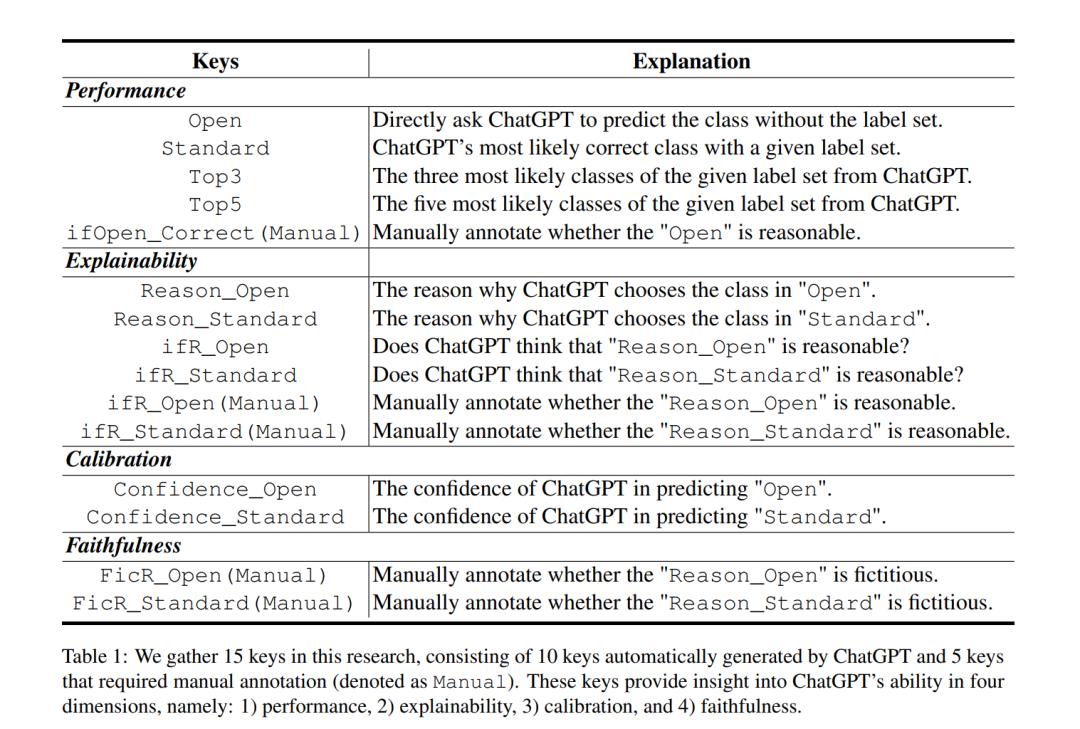

考虑到ChatGPT是一个封闭的模型,不提供关于其训练细节的信息,而且模型的任何回应都包含了观点。模型的回应可能会显著影响用户的体验,并在今后塑造他们的信仰(Aiyappa et al., 2023; Santurkar et al., 2023; Deshpande et al., 2023; Huang et al., 2023)。因此,评估ChatGPT不仅应涉及评估其实现高性能的能力,还应衡量其提供答案的可靠性。为了帮助用户更好地了解ChatGPT回应的整体质量,并使其能力的系统衡量成为可能,我们设计了以下四个度量维度:我们考虑的第一个维度是性能,它反映了ChatGPT在多个角度上处理各种信息提取任务的整体表现。第二个度量维度是可解释性(Explainability)(Rajani et al., 2019; Aghajanyan et al., 2021; Zini 和 Awad, 2023),评估ChatGPT是否能为其预测提供合理的理由,从而提供关于ChatGPT决策过程的洞察。第三个是校准(Calibration)(Guo et al., 2017; Kumar et al., 2019; Thulasidasan et al., 2019; Minderer et al., 2021),衡量模型预测不确定性,我们使用这个指标来评估ChatGPT在预测上是否过于自信。最后一个维度是忠实度(Faithfulness)(Maynez et al., 2020; Koto et al., 2022; Creswell 和 Shanahan, 2022; He et al., 2023),它经常用于摘要任务,以确定摘要是否准确反映了输入。在我们的研究中,我们采用忠实度作为衡量ChatGPT给出的解释是否真实反映输入,或者它们是否是伪造的。总之,根据以上四个维度,我们从ChatGPT或领域专家那里收集15个关键指标进行评估(§ 3)。

该研究旨在通过各种信息抽取(information extraction, IE)任务对ChatGPT的性能进行全面研究和详细分析。IE涉及异构结构提取、事实知识使用和多样化目标(Yamada等人,2020;Paolini等人,2021;Lu等人,2022),使其成为评估ChatGPT能力的理想场景。总之,我们基于7个细粒度IE任务的14个数据集进行了实验和分析(§4)。此外,我们通过自检和人工检对ChatGPT回复的可解释性、校准和忠实度进行了评估(§5)。

为了评估ChatGPT的整体能力,我们从四个维度进行全面、系统的评估:1)性能,2)可解释性,3)校准,4)忠实度。然后,我们从ChatGPT或领域专家中收集了15个属于上述维度的关键点进行研究。所有手动标注的数据集和代码都已公开,供未来研究使用。• 我们全面评估了ChatGPT在标准信息抽取(Standard-IE)和开放信息抽取(OpenIE)设置下各种任务的整体性能,并将其与其他热门模型进行了比较。我们的研究表明,ChatGPT在标准信息抽取设置下的表现并不令人满意。然而,我们发现,在开放信息抽取设置下,它提供了出人意料的好结果,这一点得到了人类评估的证实。此外,我们还发现ChatGPT为其决策提供了高质量且可信的解释。尽管如此,它在预测中表现出过度自信,导致校准较低。此外,ChatGPT在大多数情况下对原文保持了很高的忠实度。