大模型只有参数和算力?这款国产大模型证明:落地为王!

![]()

新智元报道

新智元报道

编辑:好困 David

【新智元导读】搞大模型,什么最重要?突破天际的参数规模?不差钱的海量算力?还是一刷再刷的SOTA?这些可能都不是!

谁都知道,大模型是当下人工智能领域最重要的前沿技术方向。

世界上以AI为核心抓手的科技巨头,如谷歌、微软、OpenAI、英伟达等,最近几年基本上都在搞自己的大模型。

从BERT、GPT-3、再到风光无限的Switch Transformer,模型参数数量突破天际,SOTA性能记录一刷再刷。

在国内,相关方也在推出超大规模智能模型。但这些在论文和实验中大显神威「刷榜如喝水」的大模型,最后都要面对一个绕不过去的问题:

如何落地?如何让各行各业真正用得起?

要知道,不是每个行业、每家公司都像科技巨头般财大气粗,中小公司面对天量的参数规模,高昂的训练成本,往往只能选择放弃。

在百度WAVE SUMMIT 2022深度学习开发者峰会上,百度集团副总裁、深度学习技术及应用国家工程研究中心副主任吴甜针对这个问题给出了清晰的答案:

大模型要「降低门槛,匹配需求」

吴甜提出,今年是大模型的落地关键年,要做好落地,需要解决的关键问题是前沿的大模型技术如何与真实场景的方方面面要求相匹配。

大模型是工具,但不能只是「刷榜」的工具,要成为促进产业发展的工具。作为工具的大模型,需要有「自降门槛」的觉悟,进一步贴近产业实际。

为此,百度提出了支撑大模型落地的三个关键路径:

一是要建设更适配应用场景的模型体系。

二是提供更有效的配套工具和方法,充分考虑落地应用的全流程问题。

三是打造开放的生态,以生态促创新。

模型十连发,目的只有一个

我们先来简单回顾一下百度在WAVE SUMMIT 2022深度学习开发者峰会上带来的大模型新发布。

与那些用一个大模型通吃所有问题的思路不同,百度的目的是要建设一个可以产业落地、全面的、有层次的体系。

这个模型体系,包含学习了足够多数据与知识的基础大模型,面向常见AI任务专门学习的任务大模型,以及引入行业特色数据和知识的行业大模型。

基础大模型具有学习的数据、知识量大、参数规模大特点,通用性最高。本次的重点发布是融合任务相关知识的千亿大模型ERNIE 3.0 Zeus和多任务视觉表征学习VIMER-UFO 2.0。

但直接使用基础模型往往会与场景上苛刻的应用需求会有一定差距,所以百度在通用模型基础上,增加了两类模型:任务大模型和行业大模型。

任务大模型主要面向特定任务,如NLP领域的信息抽取、对话、搜索等,以及视觉领域的商品图文搜索,文档图像理解等。

不过,无论大模型的性能有多强,参数量如何突破天际,最终还是要看它在哪个领域真正发挥作用,看它能给千千万万从业者和普通人带来什么实际便利。

换句话说,大模型的厉害,不仅要体现在论文里的SOTA,还要让行业内的用户真正用得上、用得好,进而带动产业发展和升级。

所以,我们看到了最后一类「行业大模型」的发布。

还是业内首发的那种。

行业大模型,顾名思义,可以理解为针对特定行业进行知识增强后的大模型。

行业大模型基于通用的文心大模型挖掘相关的行业数据,再融合学习行业特有的大数据和知识,进一步提升大模型对行业应用的适配性。

除了引入了行业里特有的知识和特有的数据外,为了更好地学习行业中的特色知识,行业大模型的研发团队还和拥有深度行业Know-how认知的专家们一起设计了相应的预训练任务,将通用模型真正变成对于行业来说效果更适用的模型。

最后再对模型进行大规模无监督的联合训练,进一步提升大模型的行业应用能力。

值得一提的是,这次百度选择了两个与人们日常生活距离最近的行业:能源和金融。

原因也很简单,一是这两个领域的数字化转型智能化升级的基础较好;二是智能化升级的诉求比较强烈,有场景,有需求。

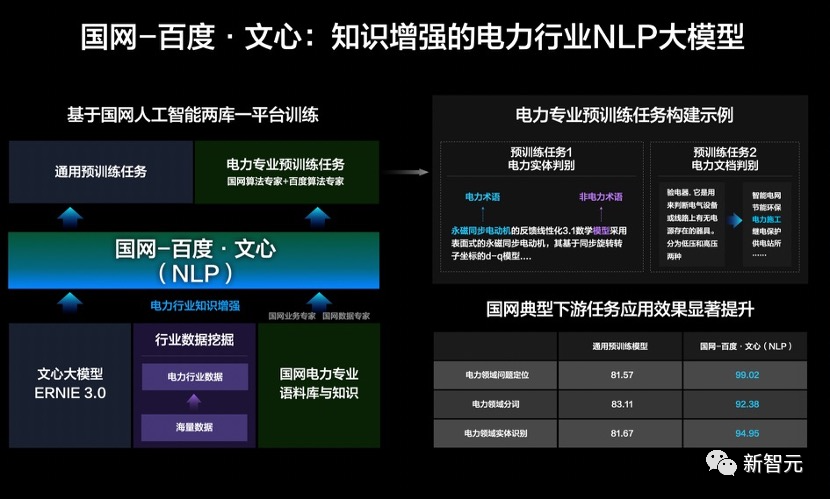

具体来说,在能源电力行业,百度和国网联合研发了知识增强的NLP大模型国网-百度·文心。

基于通用文心大模型,在海量数据中挖掘了电力行业数据,百度与国网专家们一起,引入电力业务积累的样本数据和特有知识。

在训练中,结合双方在预训练算法和电力领域业务与算法的经验,设计出电力领域实体判别、电力领域文档判别等算法作为预训练任务,让文心大模型深入学习电力专业知识,在国网场景任务应用效果提升。

从结果上看,国网-百度·文心大模型不仅提升了传统电力专用模型的精度,而且大幅降低了研发门槛,实现了算力、数据、技术等资源的统筹优化。

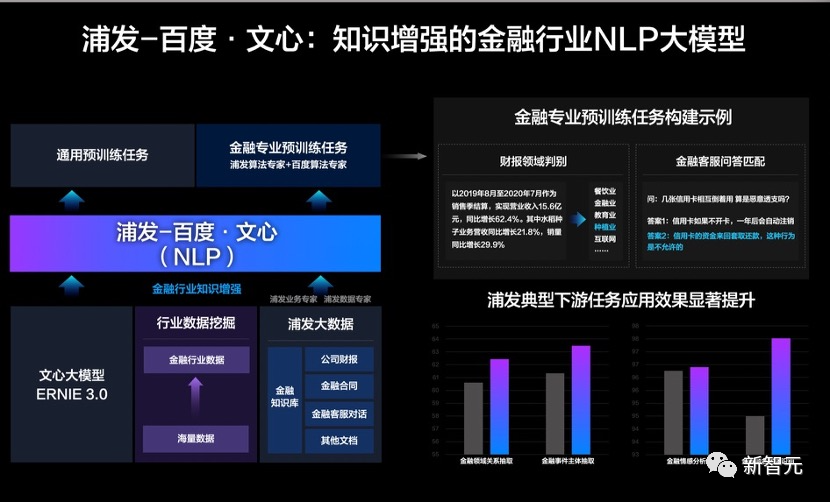

相似的思路,在金融领域,百度和浦发联合研发了知识增强的金融行业NLP大模型浦发-百度·文心。

基于通用文心大模型挖掘金融行业数据,结合浦发场景积累的行业数据与知识,进行大规模无监督数据联合训练。

其中,双方技术和业务专家一起设计了针对性的财报领域判别、金融客服问答匹配等预训练任务,实现了金融行业结构化知识增强。

最后,浦发-百度·文心不仅能够很好的支持金融语义相似度、金融事件主体抽取等各类行业场景中的NLP任务,而且在一系列典型的应用中取得了显著提升。

此外,飞桨文心大模型已经在媒体、医疗等行业都产生了巨大价值。

例如在保险领域应用中,智能解析能力将文本处理效率提升30倍;在医疗领域应用中,将每份病历的检查时间,从30分钟缩短到了秒级别。

「榨干」模型性能

高性能的大模型是基础,现在基础有了,下一个问题就是,用户怎样才能用着舒服,把模型的性能发挥到极致?

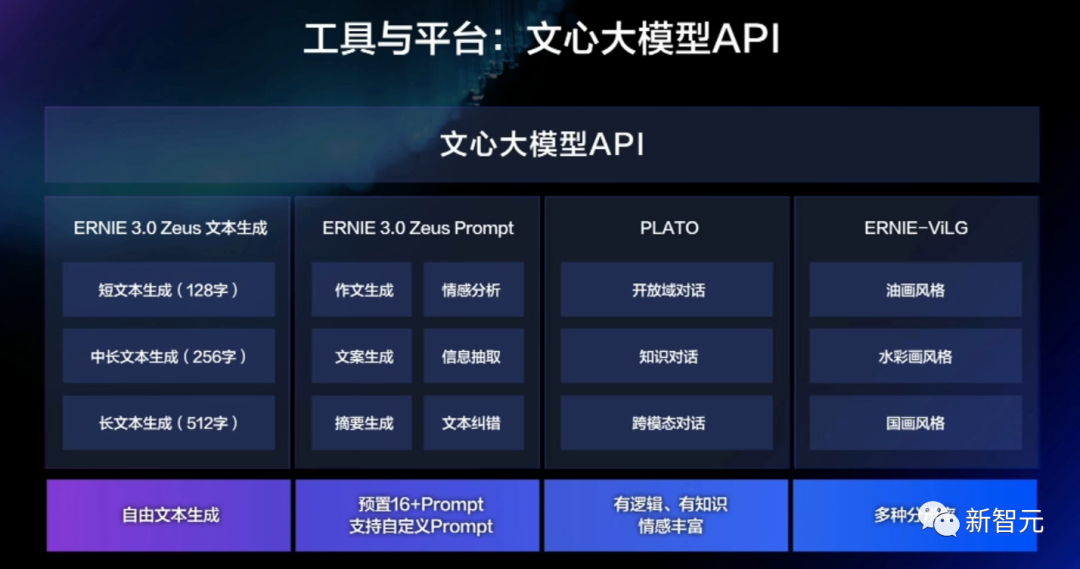

为了尽可能地实现这个目标,本次百度与10个大模型一同发布的,还有一套全方位的工具和平台,包括大模型开发套件、大模型API、内嵌了大模型能力的EasyDL和BML开发平台,面向不同类型的开发者,全面释放大模型的使用效能,进一步降低应用门槛。

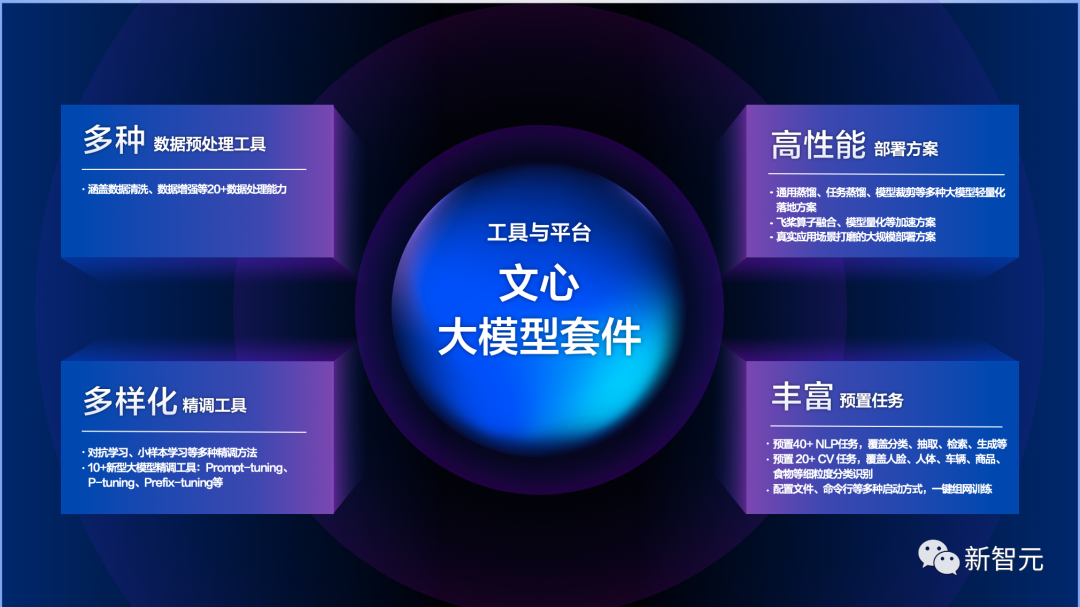

「文心大规模套件」主要包括四个方面的工具:

多种数据预处理工具:覆盖数据清洗、数据增强等20种以上的数据处理能力。

多样化精调工具:涵盖对抗学习、小样本学习等多种精调方法。提供10余种大模型精调工具,如Prompt-turning、P-turning、Prefix-turning等。

高性能部署方案:涵盖通用蒸馏、任务蒸馏、模型裁剪等大规模轻量化落地方案、以及飞桨算子融合、模型量化等加速方案。以及经历真实场景打磨的大规模部署方案。

丰富的预置任务:预设了多领域的丰富任务。包括40多种NLP任务,涵盖分类、抽取、检索、生成等。20多种计算机视觉任务,涵盖人脸、人体、车辆、商品、食物等细粒度分类识别。

在这些预制任务下,提供配置文件、命令行等多种启动方式、实现一键组网训练。

如果想要更直接简便的服务,可以直接使用大模型API、内置了文心大模型能力的EasyDL和BML开发平台,面向不同算法能力的开发者,全面释放大模型的使用效能。

无论是文本生成、信息提取、对话还是AI画家,这套API都能满足用户多角度、全方位的需求。

目前,ERNIE 3.0 Zeus、PLATO、ERNIE-ViLG都可以供使用者通过API直接访问调用。

目前在EasyDL和BML平台上已有1万多用户用到了预训练大模型,创建了超过3万任务,通过大模型机制进行AI应用模型开发,数据标注量平均降低70%,效果平均提升10.7%。

开放生态促创新

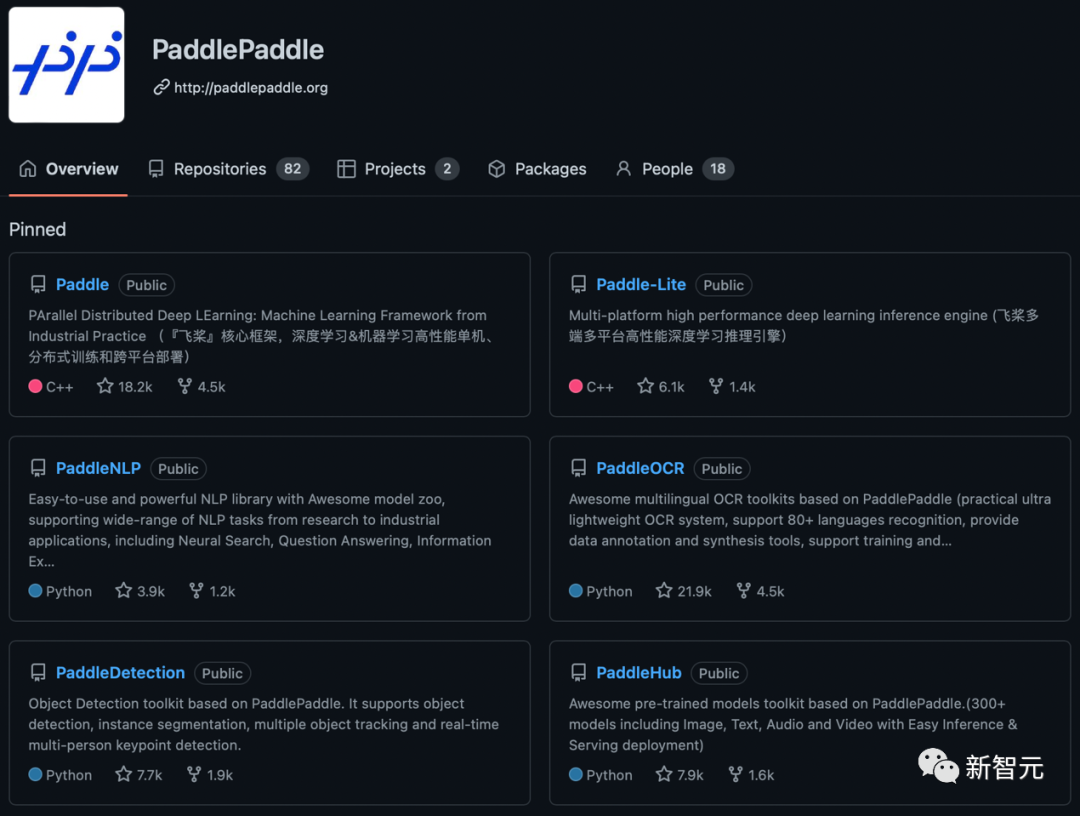

在生态系统搭建上,文心大模型共创共享飞桨生态,同时为促进大模型惠及最广泛的行业与人群,新发布基于文心大模型的创意社区——「旸谷」大模型创意与探索社区。

「旸谷」一词在传说中是「日出的地方」。未来有望进一步将文心带给千行百业,带给越来越多渴望知识的人。

按照百度的设计理念,旸谷社区是文心大模型支持下的一个创意应用空间,是开发者尽情展现自己脑洞的地方,比如智能作画、AI智能对话、智能写歌、AI写故事等等。

以「AI造梦师」为例,就是以核心大模型ERNIE 3.0为基础,利用文本生成技术,根据用户的输入线索,进行梦境内容的生成,创作出充满想象力、画面感的各种各样的梦境。

相信依托文心大模型在开放生态上的持续发力,百度AI生态建设无论是在深度和广度上都将迈上了新的台阶。

国产模型配国产架构,一个字:香

有大模型,也必然会有相应的训练框架。

而文心模型的背后,就是百度自主研发,国内首个开源开放、功能丰富的产业级深度学习平台「飞桨」了。

文心大模型的训练、推理都依托深度学习平台的支撑,同时,大模型作为飞桨平台中产业级模型库的重要一员,成为了飞桨平台支持AI创新必不可少的能力。

说回到模型上来,大模型可谓是成也「大」,难也「大」。

巨大的参数规模,以及不同模型和算力平台之间的差异,给训练带来了极大的挑战。

飞桨分布式架构统筹考虑这些差异性问题,实现了端到端自适应分布式架构,根据模型和算力平台的特点,自动选择并行策略,自动调优,高效执行,实现方案既具备通用性,又兼顾了高效性。

在并行训练策略上有创新,对异构硬件支持自适应并行训练,打造了框架与算力、算法相结合三位一体的大模型训练解决方案,实现了端到端的极致性能优化。

相对训练而言,大模型推理面临更大的挑战,如何实现高效是实现产业应用落地的关键所在。

因此,飞桨推出了一个针对大模型的压缩、推理、服务化全流程部署方案。

其中,通过面向大模型的精度无损模型压缩技术、自适应分布式推理技术,可自动感知硬件特性,完成模型压缩、自动切分和混合并行推理计算。

首先通过精度无损模型压缩技术让模型轻量化,然后通过自适应分布式推理技术,充分调动算力资源,比如千亿级模型,只有分布式推理才能跑得起来。

整体方案通用且可扩展,能广泛支持不同种类的模型结构,实现高速推理,目前已支撑了如自然语言理解、对话、跨模态生成等大模型的实时在线应用。

最后通过大规模服务化部署,让大模型真正落成应用。

飞桨的这套训练推理一体化技术也使文心大模型的规模化生产成为了可能,让大模型更接近产业,落地在产业当中,而不仅仅是实验室技术。

从ERNIE1.0到文心·行业大模型:百度这3年的大模型研发之路

实际上,对于百度而言,这次发布的10个大模型,尤其是两个行业大模型的诞生,是过去3年多来日夜耕耘的结果。

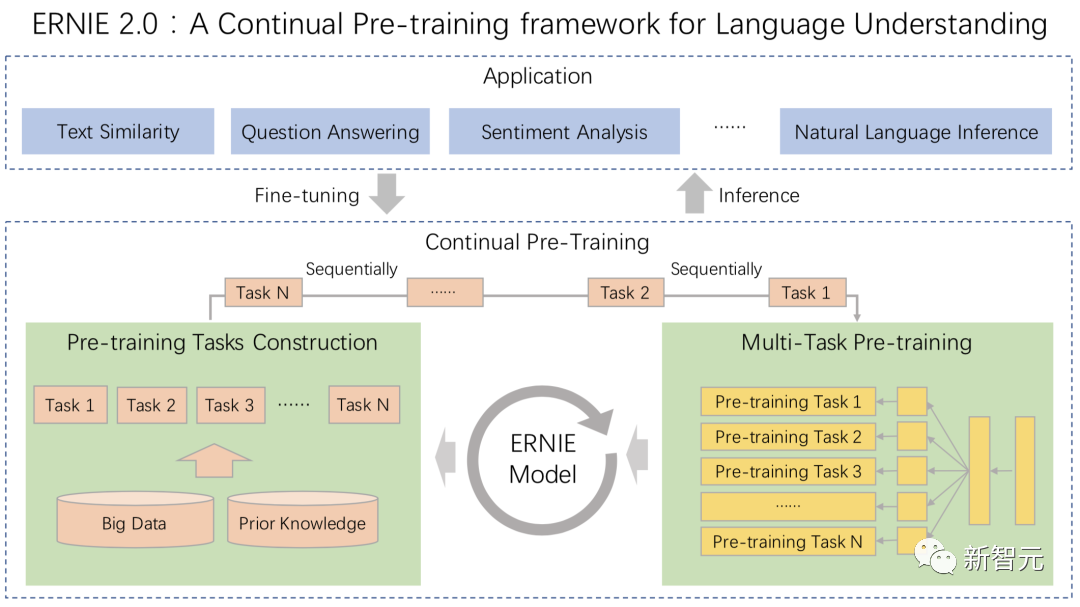

如果从大模型的诞生讲起,它其实始于NLP领域的一种新的范式:「预训练-微调」范式。

这种范式基本思路是,选定一个通用的、表示能力强的模型为「语义表示模型」。在预训练阶段,用大量语料和特定的任务训练,使其编码海量的语义知识。在微调阶段再加上不同的简单输出层,解决下游的 NLP 任务。

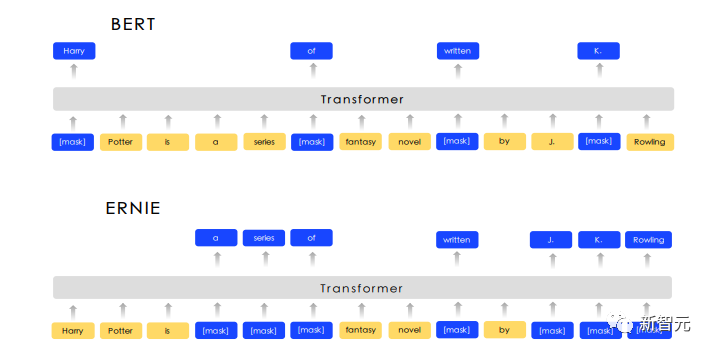

2019年3月,百度率先发布国内首个正式开放的预训练模型「ERNIE 1.0」。

ERNIE和BERT在mask学习策略上的差异

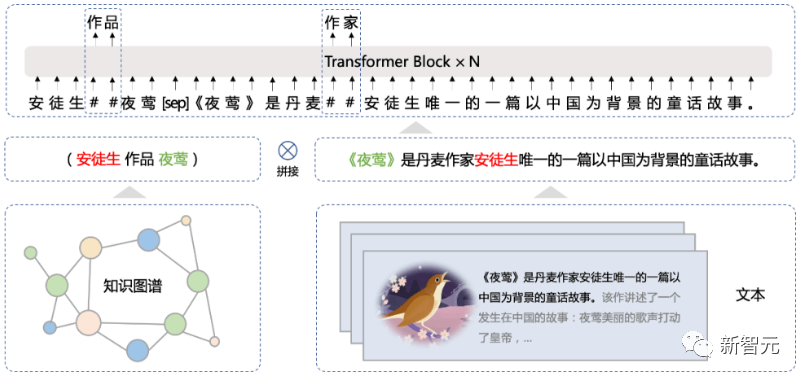

ERNIE(Enhanced Representation through kNowledge IntEgration)就是百度自己提出的语义表示模型。相较于BERT,ERNIE在预训练过程利用了更丰富的语义知识和更多的语义任务,在多个NLP任务上取得了比BERT更好的效果。

2019 年 12 月,ERNIE 2.0以 9 个任务平均得分首次突破 90 大关的成绩登顶国际权威排行榜GLUE榜首。

经历两年的开发,2021年7月,百度百亿参数规模的知识增强型预训练模型ERNIE 3.0问世。这是当时业界首次在百亿级预训练模型中引入大规模知识图谱。

ERNIE 3.0 一举刷新54个中文NLP任务基准,其英文模型在国际权威的复杂语言理解任务评测SuperGLUE上,以超越人类水平0.8个百分点的成绩登顶全球榜首。

ERNIE 3.0同时具备超强语言理解能力以及写小说、歌词、诗歌、对联等文学创作能力。

同年12月,百度联合鹏城实验室打造了「鹏城-百度·文心」(代号ERNIE 3.0 Titan)。

这是全球首个知识增强千亿大模型,参数规模达到2600亿,是当时全球最大中文的单体模型,在60多项任务中取得了SOTA。

而在这次WAVE SUMMIT 2022深度学习开发者峰会上,ERNIE家族再添新成员!名字也从「泰坦」升级到了万神之王——「宙斯」。

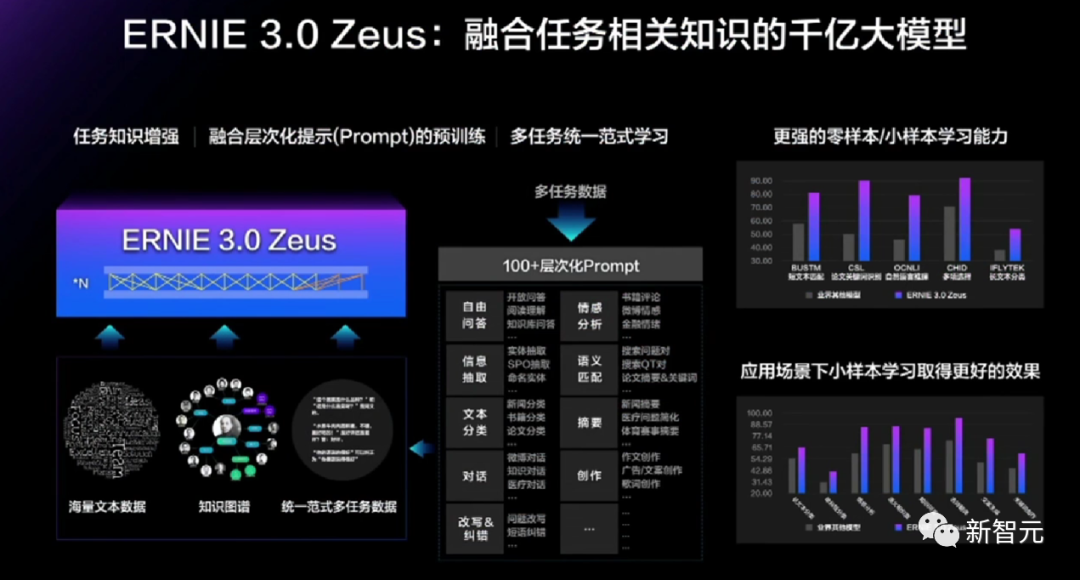

ERNIE 3.0 Zeus是ERNIE3.0系列模型的全新升级,是融合了任务相关知识的千亿大模型,也是国内首个开放API调用的千亿大模型。

除了对无标注数据和知识图谱的学习之外,还通过持续学习对百余种不同形式的任务数据,实现了任务知识增强,显著提升了模型的零样本/小样本学习能力。

如此出色的表现是如何实现的?多学、杂学、持续学!

除了对海量文本和知识图谱的学习之外,ERNIE 3.0 Zeus通过持续学习技术对百余种不同形式的任务数据学习,通过引入任务相关的知识,增强模型的效果。

此外,还设计了任务相关的prompt层次化分类体系,通过融合层次化提示的预训练,更好地建模不同任务的共性与特性。同时通过将不同的任务组织成统一的自然语言形式,使用统一的建模范式增强了模型的泛化能力。

可以说,正是ERNIE 3.0 Zeus 等基础大模型的发布,为百度文心「大模型体系」架构的全面布局铺下了最坚实的路基。

在此基础之上,百度才得以面向细分任务和行业场景,推出任务大模型和行业大模型,全面满足产业应用需求。

让技术赋能产业,让AI助推工业大生产

伴随中国人工智能走进产业规模化应用的「深水区」,百度在大模型上搭建了适配场景需求的体系,提供全流程支持应用落地的工具和方法,建设激发创新的开放生态。这套思路是与AI不断深入产业相吻合的。

尤其是百度与行业头部企业联合研发系列文心·行业大模型,为企业搭建AI基础设施,共同推进大模型在行业的深度应用,更体现了百度AI技术对产业落地的前沿洞察和独有思考。

当然,行业大模型也并非是把AI技术和行业场景的简单叠加,而是强调多个层面的强强联合,探索方法与机制,实现群智创新、深度协同。

此次百度首发行业大模型,就是探索出一套行之有效的大模型产业落地打法,让大模型「能用、可用」,规模化落地价值显现。

让企业和生产机构成为真正主体,把新技术引入和吸纳进来,极大助推工业大生产。

如果说拥有自己的算力、算法是一个科技公司的本职;那一口气发布10个大模型,形成基础大模型、任务大模型、行业大模型三级模型体系,并在产业里持续埋头深耕,大概更符合飞桨「源于产业实践,服务于产业应用」的建设思路,也呼应了百度「成为最懂用户,并能帮助人们成长的全球顶级高科技公司」愿景吧。