关键词**:**柔性物体操作 仿真模拟和评估基准

导 读

本文是对发表于计算机人工智能领域顶级会议 NeurIPS 2024 的论文 GarmentLab: A Unified Simulation and Benchmark for Garment Manipulation 的解读。

该论文由北京大学董豪课题组完成,共同第一作者为北京大学拔尖计划本科生鲁浩然,计算机学院博士生吴睿海和清华大学本科生李宜桐共同完成。

GarmentLab,这是一个模拟场景丰富,模拟方法多样的基准测试平台和贴近于真实世界的模拟环境,专为柔体及衣物操作设计。GarmentLab 基准涵盖了多种类型的衣物、机器人系统以及末端效应器,旨在提供广泛而深入的研究基础。该平台包含的任务丰富多样,进一步探索了衣物、柔体、刚体、流体与人体之间的交互作用。

此外,通过整合多种模拟方法,如有限元法(FEM)和基于位置的动力学(PBD),以及我们提出了一系列 Sim-To-Real 算法,并提出了第一个真实世界柔性物体基准,我们的目标是显著缩小模拟与现实之间的差距。GarmentLab 不仅为研究人员提供了一个强大的工具来开发和评估新的操作策略和技术,还促进了学术界和工业界在智能衣物和柔性体处理领域的进步与发展。 论文链接:

https://arxiv.org/abs/2411.01200 项目主页:

https://garmentlab.github.io/ 开源代码:

https://github.com/GarmentLab/GarmentLab

图1. GarmentLab 为具有不同物理属性的衣物提供仿模拟,并在模拟和真实世界中基准测试各种新颖的衣物操作任务。

01

研究背景

在智能机器人和自动化系统的发展中,衣物操作因其复杂性成为研究的关键领域。为应对这一挑战,我们推出了 GarmentLab,一个集成了丰富内容的基准测试平台和逼真的模拟环境,旨在解决衣物操作中的主要难题。

衣服的操作主要面临以下问题:

**1. 无限多样的状态与复杂的物理特性:**每件衣物都能呈现出近乎无限的状态变化,这对模型理解衣物的各种形态提出了极高的要求,通常需要大量训练数据来捕捉这些复杂特性。

**2. 多样化的交互对象:**衣物操作涉及与其他多种物体(如刚体、铰接体、流体和人体)的交互,增加了任务复杂性,要求模型能够理解和预测不同物理介质间的相互作用。

**3. 显著的 sim-to-real 差距:**衣物操作策略复杂,视觉感知困难,导致从模拟到现实应用时面临较大差距,需要先进的 sim-to-real 方法来确保技能的有效迁移。

通过提供多样化且高质量的任务集、真实的模拟环境以及创新的 sim-to-real 方法,GarmentLab 致力于帮助研究人员克服上述三大挑战,推动衣物操作技术的进步与发展。

02

特点与贡献

GarmentLab 模拟器具备三大核心特点,旨在高效应对衣物操作中的主要挑战: **

**

高效(Efficient):

高度并行化的 GPU 加速模拟器提供大规模并行训练,支持更大批量处理和更快数据收集,显著缩短基于感知和强化学习算法的训练时间,有效解决衣物结构和变形理解所需的大量数据需求。

丰富(Rich):

提供多样化的模拟内容和深层次物理交互,涵盖刚体、关节体、可变形物体、流体动力学及其相互作用,确保智能体能够理解复杂的真实世界物理特性。

真实(Real):

提供成熟的 sim-to-real 算法,如远程操作和视觉仿真-现实对齐算法,并集成 ROS 和 MoveIt,将真实机器人运动引入模拟,有效缩小模拟与现实之间的差距。

通过这些特性,GarmentLab 助力研究人员开发更先进的衣物操作技术,推动该领域的进步。

03

GarmentLab 环境

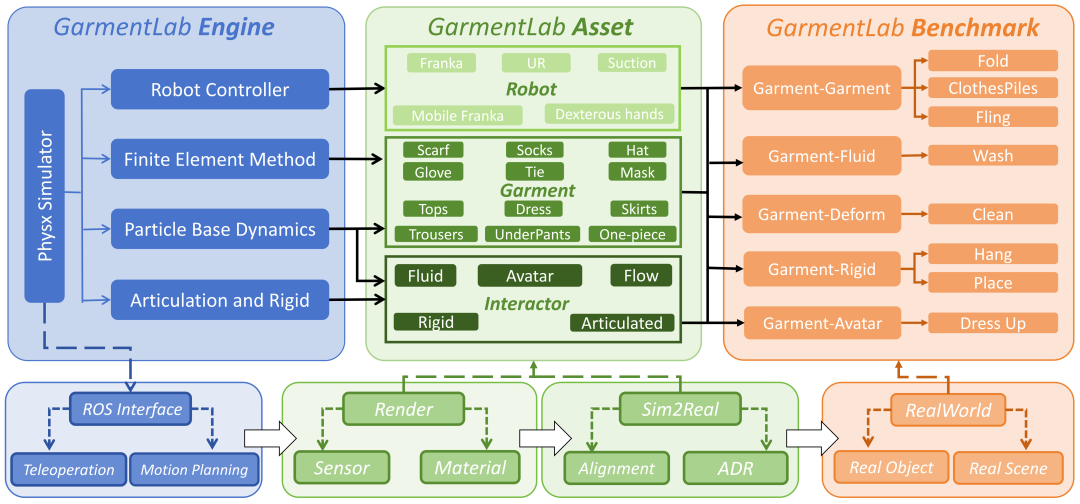

图2. GarmentLab 的架构。(左)基于 PhysX5,我们的环境支持多种模拟方法。(中)我们的环境能够提供多样化机器人、衣物及多种物理介质之间交互的仿真模拟。(右)我们可以利用这些内容构建跨多个类别的任务。(下)该框架支持真实世界的部署。

GarmentLab 致力于将最先进的物理模拟方法、现代图形渲染引擎和用户友好的机器人接口集成到一个统一框架中,特别注重多种物理模拟方法的探索及其交互。以下是 GarmentLab 的两个核心组成部分:

GarmentLab Engine

基于 NVIDIA 的 IsaacSim,GarmentLab 提供了高效的数据收集管道、逼真的渲染、多传感器支持及 ROS 集成。 **

**

**数据管道:**支持 RGB-D 观测和语义标签(2D/3D 边界框、法线、实例分割),并在 GPU 上实现多智能体并行训练。 * **渲染:**采用多视角摄像机设置和 GPU 加速光线追踪,增强真实感,减少 sim-to-real 差距。 * **ROS 集成:**使用 ROS 对齐真实与模拟环境中的机器人,并提供 MoveIt 框架用于运动规划。 * **传感器:**支持 RGB-D、机器人关节、衣物粒子等观测数据,以及其他 Omniverse 传感器。

GarmentLab Assets

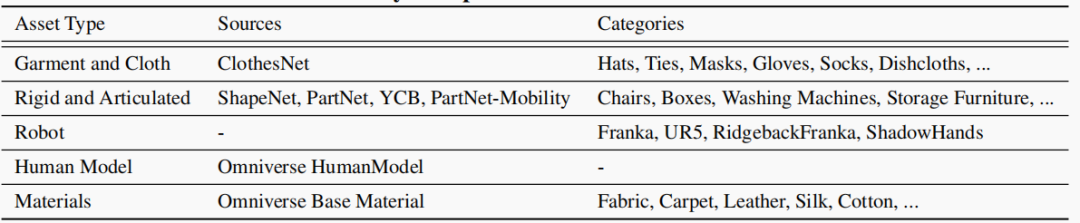

GarmentLab Assets 汇集了来自多个先进数据集的模拟内容,整合为包含机器人和传感器的即用型场景。所有资产以 Universal Scene Description 文件形式存储,包含物理、语义和渲染属性。通过这些特性,GarmentLab 提供了高度逼真和多样化的模拟环境,促进了从模拟到现实应用的有效迁移,为衣物操作研究提供了强有力的支持。具体支持的内容见表1。

表1. GarmentLab 模拟内容。

04

GarmentLab 物理

图3. GarmentLab 探索了不同模拟方法的潜力,并提供了多种物理参数,以模拟现实世界中不同材料的独特属性。

为了确保物理上的逼真模拟,GarmentLab 根据不同物体的物理特性采用定制化的模拟方法:

**大件衣物和流体:**使用基于粒子的动力学(PBD)来模拟,确保这些物体的自然流动和变形。 * **小型弹性衣物(如手套、袜子)和日常物品(如毛绒玩具、海绵):**应用有限元法(FEM),以精确捕捉其弹性和结构特性。 * **人体模拟:**采用带有旋转关节的骨架模型,并结合高保真的表面皮肤网格渲染,提供真实的视觉效果。 * **机器人模拟:**利用 PhysX 艺术系统实现精确的力量控制、P-D 控制和逆动力学。

不同于以往依赖单一模拟方法的工作,GarmentLab 提供了一个探索各种物体动力学和运动学及其相互作用的平台。通过多样化物理参数配置,GarmentLab 进一步增强了模拟的真实性和多样性。例如,调整粒子大小和刚度可以改变衣物的行为;对于流体,则设置了包括表面张力和内聚力在内的多种物理参数;刚体则考虑了摩擦系数等。此外,还包括了影响不同物体之间交互的接触偏移和复位偏移等参数。

05

GarmentLab 任务

图4. 短任务举例。

GarmentLab 基准旨在评估智能操作代理应具备的关键能力,即理解物体交互的物理特性,为长期、复杂的任务生成精确的动作序列,并将这些知识应用到现实世界中。

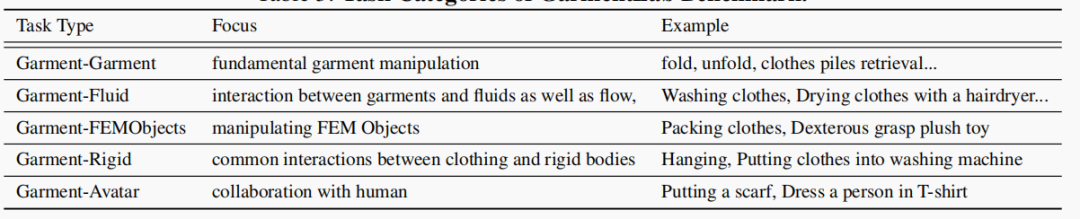

为了测试这些能力,我们将任务分类为五个基于物理交互的类别,并提出了一些复杂且长期的任务以推动未来的研究。为了充分利用模型在理解物理交互方面的能力,并对当前算法进行全面评估,我们将20项任务分为5大类。具体任务及其所属类别见表2。

表2. GarmentLab 任务。

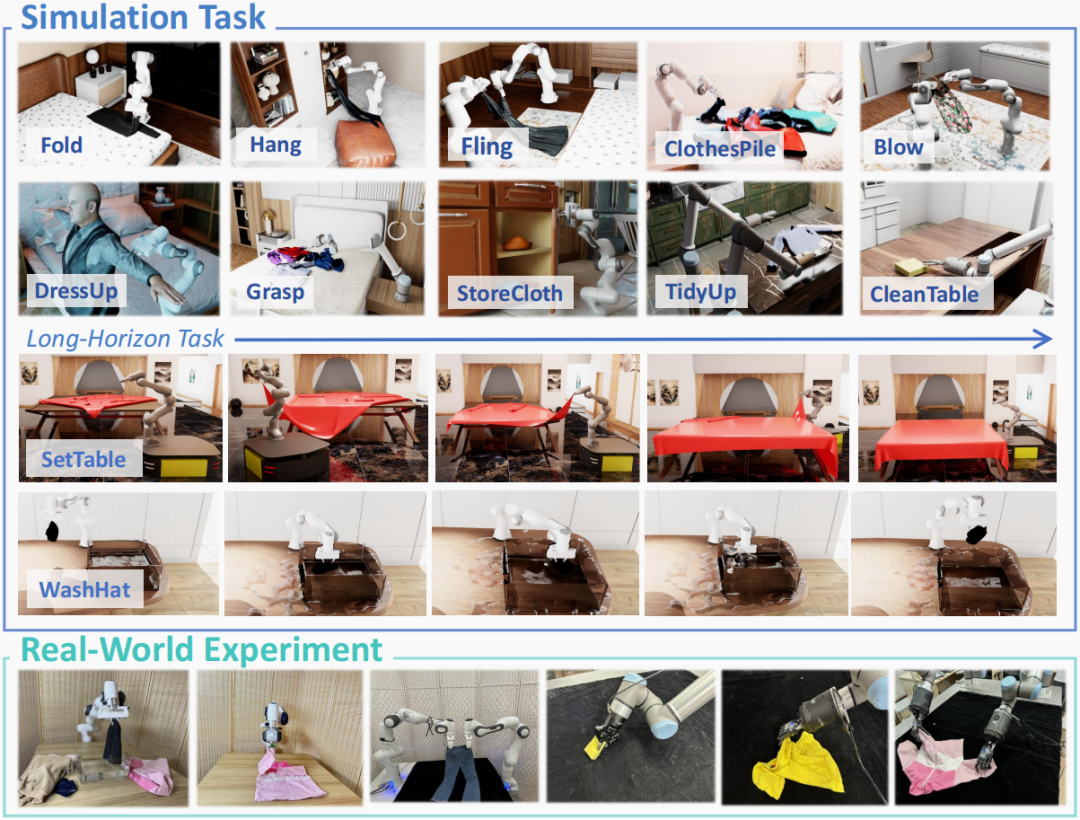

图5. GarmentLab 基准测试的多样任务。我们引入了20项衣物和柔性物体操作任务,其中包括复杂的长期任务。最后一行展示了这些任务在真实世界中的执行情况。

随着机器人技术的发展,完成长期任务成为研究的重点,这类任务集成了 3D 感知、操作和导航等技能。因此,我们提出了几项长期衣物操作任务,例如整理衣物、洗衣、布置桌子和穿衣。这些任务不仅仅是简单地按顺序执行子任务,而是需要综合规划如何根据环境条件来完成整个任务。在执行过程中,算法必须考虑操作的位置、放置地点,并精心规划路径以避免碰撞。

通过这些精心设计的任务分类和长期任务,GarmentLab 基准不仅能够全面评估现有算法的有效性,还为未来的衣物操作研究提供了重要的参考和挑战。

06

真实世界柔体操作基准

图6. 真实世界基准测试。部分 a 展示了将真实世界物体转换为模拟资产的完整流程。部分 b 展示了不同类别物体在模拟和真实世界中的表现(第一行),以及这些物体被机器人操作后的结果(第二行)。

真实世界基准测试对于评估不同方法的实际性能至关重要,同时也为研究人员提供了一个标准化的平台以重现和交流方法。

鉴于已存在针对刚体、关节物体及家具的真实世界数据集或基准测试,我们引入了首个专门针对可变形物体和衣物的真实世界基准测试。不同于可以通过 CAD 文件 3D 打印的刚体或关节物体,可变形物体通常没有 CAD 文件,并且容易受到外部力量的影响,难以用传统的多摄像机校准和表面重建方法准确建模。因此,我们使用带有激光和光源的商业扫描设备进行网格扫描,确保模型的准确性。选择的物体涵盖了各种类型的衣物(如上衣、裤子、袜子、帽子)、毛绒玩具、家用物品(如包、手拿包)和清洁用品,这些物品主要来自知名国际品牌,以保证耐用性和易获取性。为了确保多样性,物体具有不同的形状、大小、透明度、可变形性和纹理,例如由冲锋衣、羽绒服、衬衫和马甲等材料制成的各种上衣,涵盖了广泛的物理属性。

此外,我们还为物体部分掩码和关键点提供了语义人类标注,支持诸如抓取特定部位和利用关键点进行物体跟踪等灵巧操作。参照 YCB,我们提出了系统化的操作协议和基准测试方法,详细规定了每个任务的实验设置和程序指南,确保了实验的一致性和可比性。通过这一全面的真实世界基准测试,GarmentLab 不仅为评估和改进衣物操作算法提供了重要工具,还促进了该领域的研究和发展。

07

Sim-To-Real Method

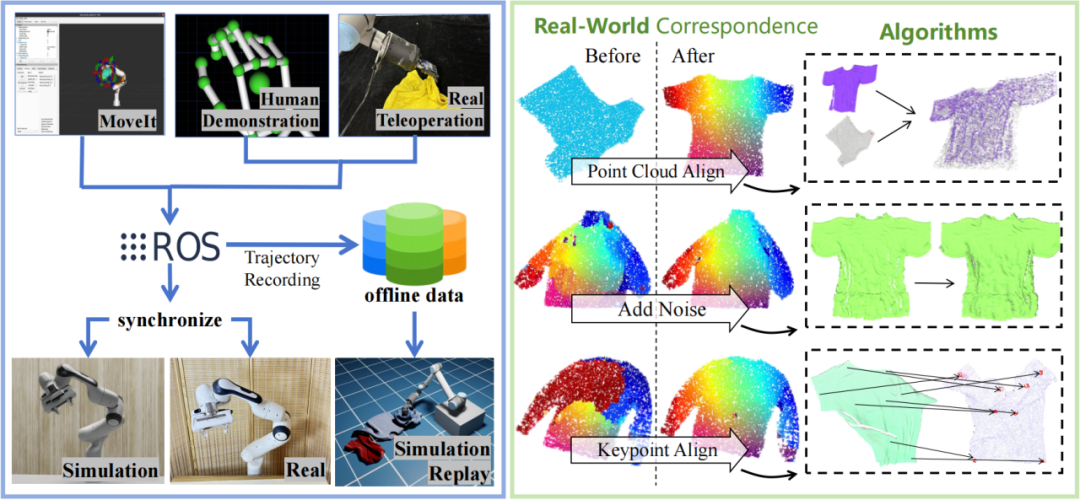

图7. Sim2Real 框架。在左侧,我们突出了基于 ROS 构建的 MoveIt 和远程操作系统,这是一个轻量且易于部署的系统。在右侧,我们介绍了提出的三种视觉 sim-to-real 算法,展示了在部署这些算法后模型性能的显著提升。

GarmentLab 提供了两类 sim-to-real 方法,包括视觉 Sim-To-Real 方法以及** Action Sim-To-Real 方法**。

视觉 Sim-To-real 方法

GarmentLab 集成了多种自动化和自监督的 sim-to-real 方法,验证了其在预测密集视觉对应关系以辅助操作任务中的有效性(图6右)。

**关键点嵌入对齐:**通过 self-play 获取真实的关键点对,并使用 InfoNCE 对齐骨架点表示,减小模拟与现实之间的表示差距,使模型适应真实世界分布。 * **噪声观察:**训练时向点云添加噪声,提高模型鲁棒性,减少初始查询错误,实现更准确和平滑的表示。 * **点云对齐:**优化仿射矩阵并通过 Chamfer 距离作为损失函数对齐点云,显著改善了模型对真实物体表面的预测准确性。

这些方法共同提升了从模拟到现实应用中的视觉一致性,确保了操作任务的成功率。

Action Sim-To-Real 方法

为了使模拟生成的动作轨迹更贴近真实场景,我们引入了两种方法:

遥操作(Teleoperation)**:**开发了一键部署的轻量级远程操作系统,可同时控制真实和模拟环境中的灵巧手和夹具(图6),支持离线训练的数据收集。 * **MoveIt 集成:**将 MoveIt 集成到框架中,提升运动规划和障碍规避能力,并辅助视觉算法改进。通过适应 MoveIt 生成的轨迹,减少 sim-to-real 差距。

这两种方法确保模拟动作轨迹更贴近真实操作需求,提高了从模拟到现实应用的迁移效果。

08

基准测试

论文在 GarmentLab 环境中进行了多项视觉和强化学习(RL)基准测试。视觉基准测试采用了包括一系列最先进方法,如 affordance、UniGarmentManip 和 DIFT;而 RL 基准测试则主要采用了基于状态(RL-State base)和基于视觉(RL-vision base)的两种方法进行评测。

09

总 结

这篇论文提出了 GarmentLab 是一个全面的衣物和柔体操作环境与基准平台,包含以下核心组件:

**GarmentLab Engine:**支持多种模拟方法和 ROS 集成,提供高效的数据收集管道和逼真的渲染。 * **GarmentLab Assets:**包含多样化的机器人、材料和衣物数据集,涵盖物理、语义和渲染属性。 * **GarmentLab Benchmark:**提出了若干创新任务,并提供了首个真实世界可变形物体基准测试,以及多种 sim-to-real 方法。

通过这些特性,GarmentLab 为衣物和柔体操作研究提供了高度逼真和多样化的模拟环境,促进了从模拟到现实应用的有效迁移,推动了该领域的技术进步。