【可控图像合成与编辑的合成生成先验学习】SemanticStyleGAN: Learning Compositonal Generative Priors for Controllable Image Synthesis and Editing

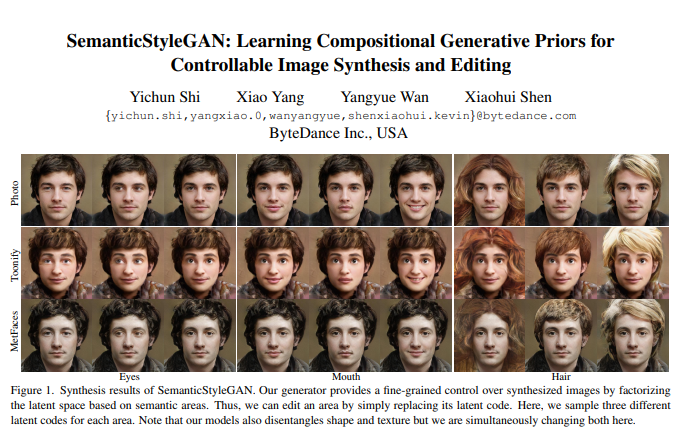

● 论文摘要:最近的研究表明,StyleGANs为图像合成和编辑的下游任务提供了有前途的预先模型。然而,由于StyleGANs的潜代码是设计来控制全局样式的,因此很难对合成的图像实现细粒度的控制。我们提出了SemanticStyleGAN,它训练一个生成器分别建模局部语义部分,并以合成的方式合成图像。不同局部部位的结构和纹理由相应的潜码控制。实验结果表明,我们的模型提供了不同空间区域之间的强解纠缠。当与为StyleGANs设计的编辑方法相结合时,它可以实现更细粒度的控制来编辑合成的或真实的图像。该模型还可以通过迁移学习扩展到其他领域。因此,作为一个具有内置解纠缠的通用先验模型,它可以促进基于gan的应用程序的开发,并支持更多潜在的下游任务。

● 论文主页:https://semanticstylegan.github.io/

● 论文链接:https://arxiv.org/abs/2112.02236

● 论文代码:(待更新)

● 数据集:FFHQ,DeepFashion

● 论文视频:https://semanticstylegan.github.io/videos/demo.mp4

● 作者单位:字节跳动

成为VIP会员查看完整内容

相关内容

专知会员服务

27+阅读 · 2022年3月3日

Arxiv

0+阅读 · 2022年4月19日

Arxiv

1+阅读 · 2022年4月18日