题目: Laplacian Regularized Few-Shot Learning

简介:

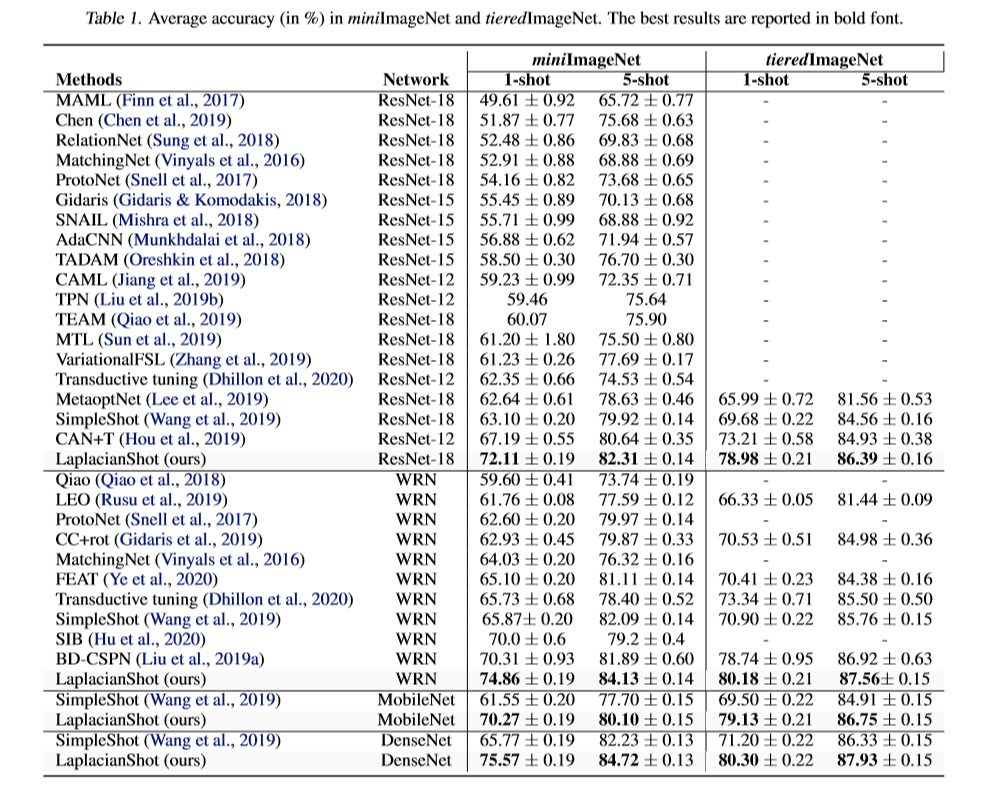

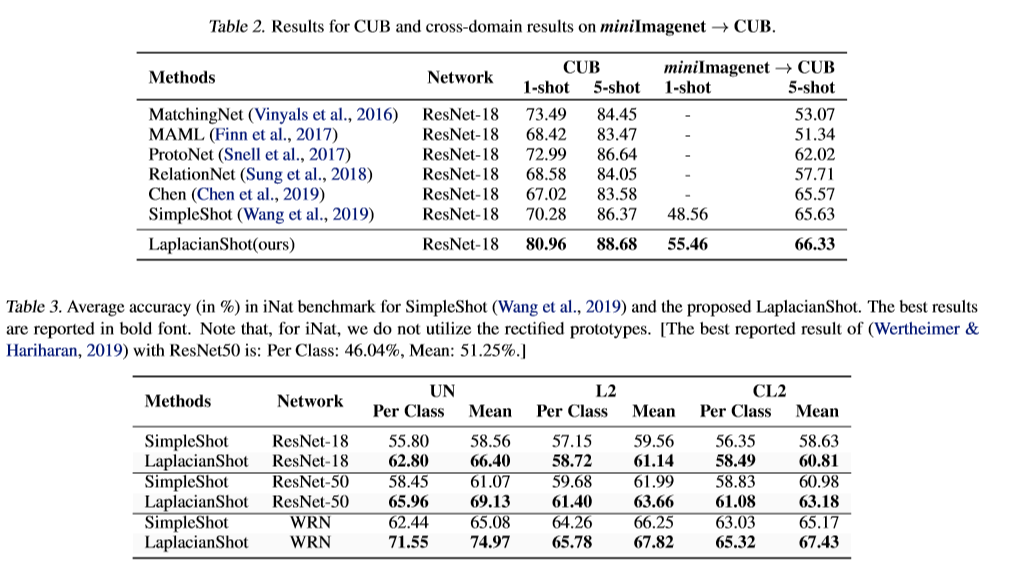

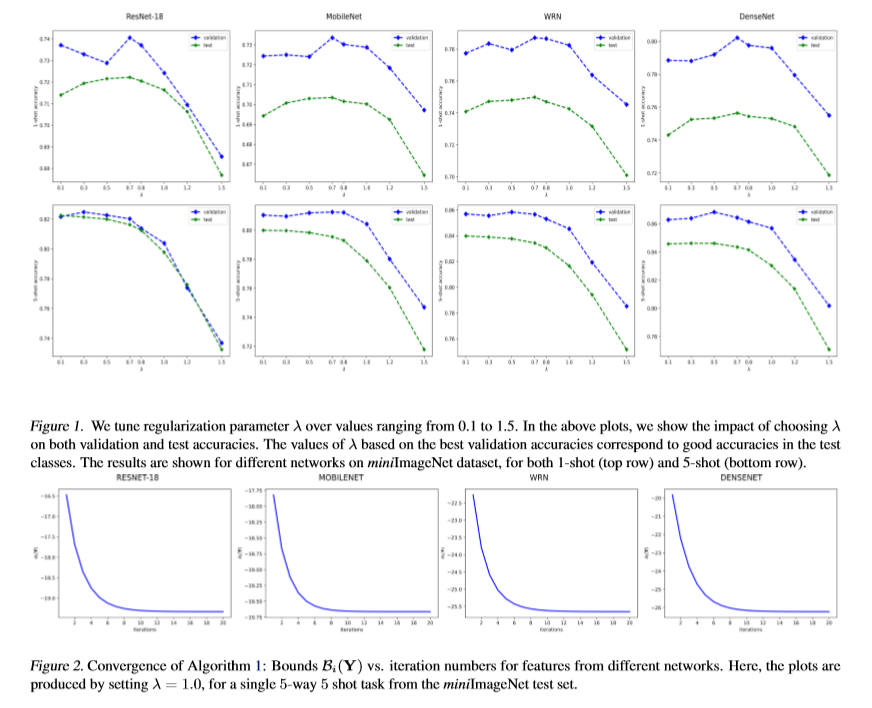

我们为小样本学习提出了一个拉普拉斯正则化推断。给定从基类中学习到的任何特征嵌入,我们将包含两个项的二次二进制赋值函数最小化:(1)将查询样本分配给最近的类原型的一元项,以及(2)鼓励附近查询样本成对使用的成对拉普拉斯项具有一致的标签。我们的推论不会重新训练基本模型,并且可以将其视为查询集的图形聚类,但要受到支持集的监督约束。我们导出了函数松弛的计算有效边界优化器,该函数在保证收敛的同时为每个查询样本计算独立(并行)更新。在基础类上进行简单的交叉熵训练,并且没有复杂的元学习策略后,我们对五个基准进行了全面的实验。我们的LaplacianShot在不同模型,设置和数据集上具有显着优势,始终优于最新方法。此外,我们的归纳推理非常快,其计算时间接近于归纳推理,可用于大规模的一次性任务。

成为VIP会员查看完整内容

相关内容

专知会员服务

16+阅读 · 2020年3月27日