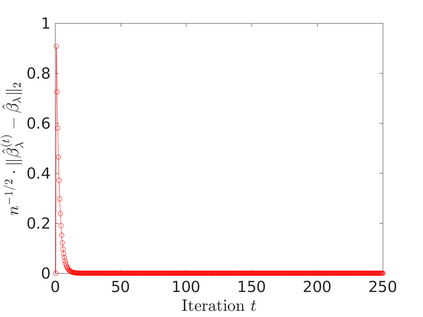

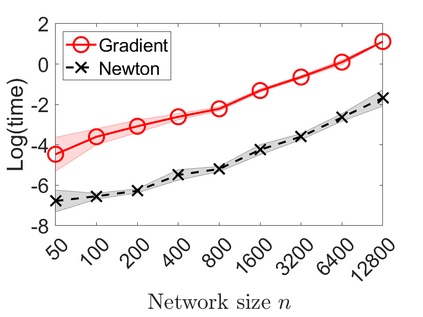

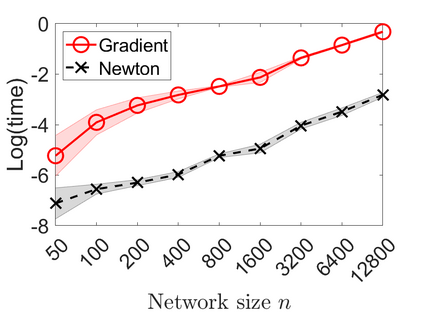

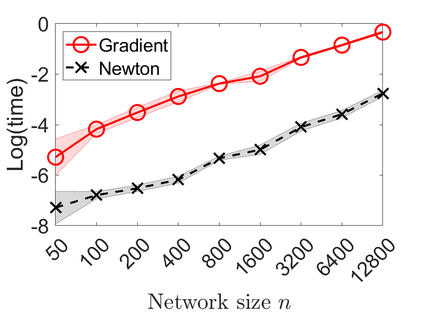

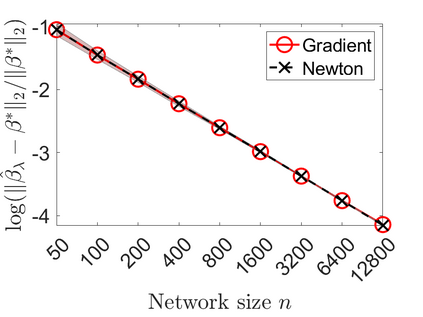

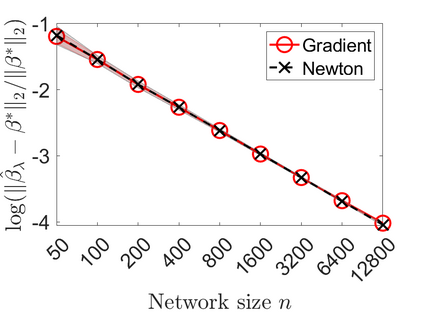

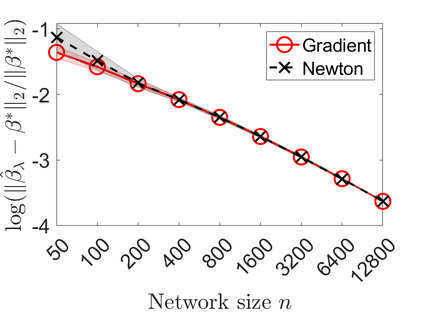

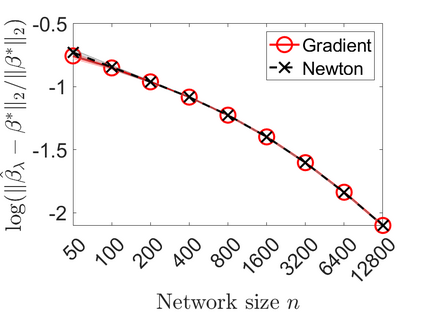

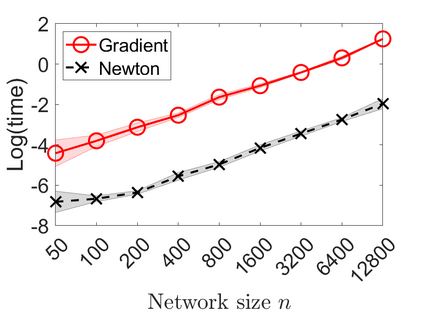

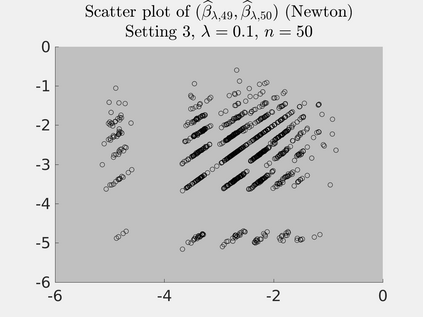

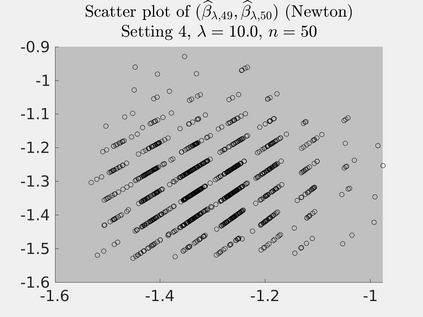

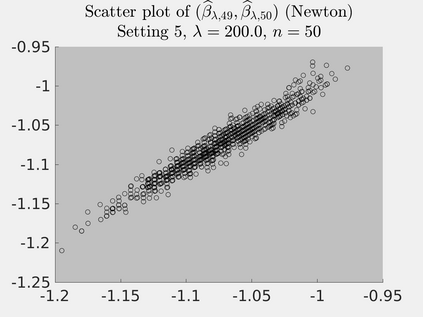

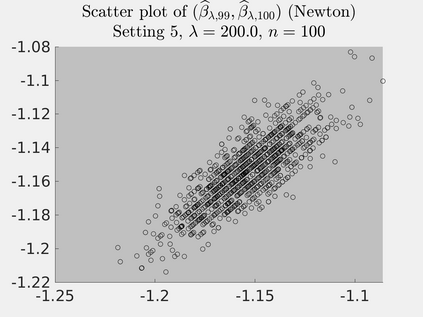

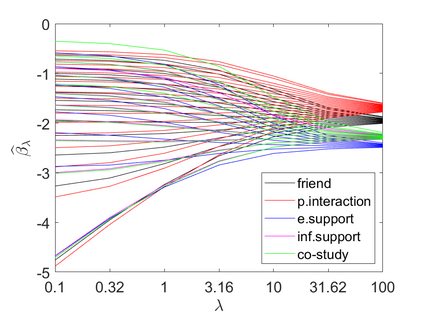

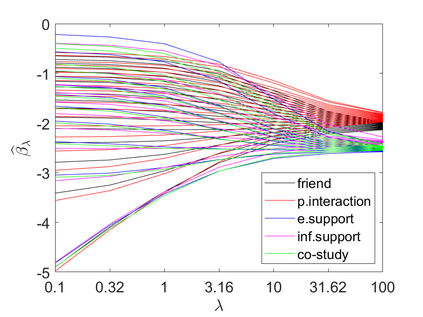

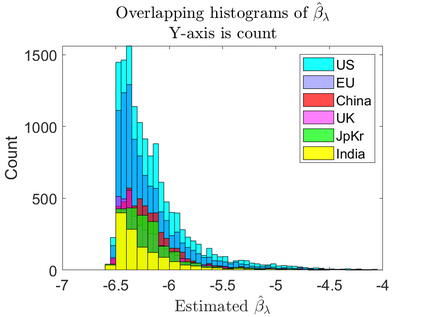

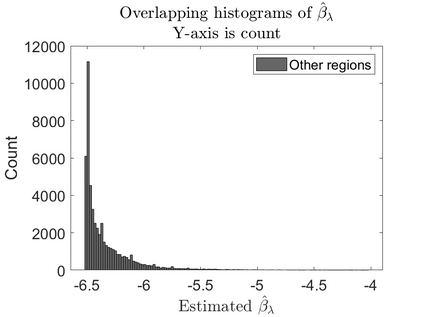

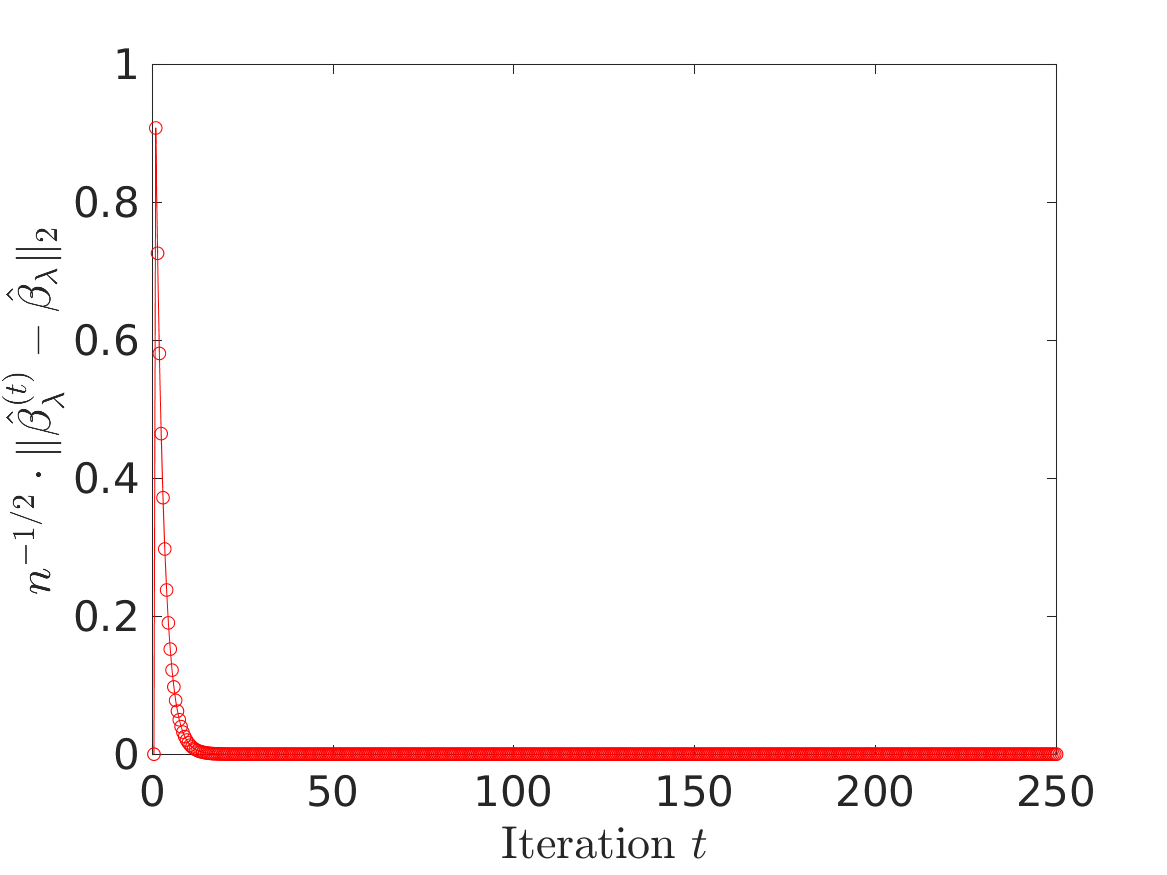

The $\beta$-model is a powerful tool for modeling network generation driven by node degree heterogeneity. Its simple yet expressive nature particularly well-suits large and sparse networks, where many network models become infeasible due to computational challenge and observation scarcity. However, existing estimation algorithms for $\beta$-model do not scale up; and theoretical understandings remain limited to dense networks. This paper brings several major improvements to the method and theory of $\beta$-model to address urgent needs of practical applications. Our contributions include: 1. method: we propose a new $\ell_2$ penalized MLE scheme; we design a novel algorithm that can comfortably handle sparse networks of millions of nodes, much faster and more memory-parsimonious than any existing algorithm; 2. theory: we present new error bounds on beta-models under much weaker assumptions; we also establish new lower-bounds and new asymptotic normality results; distinct from existing literature, our results cover both small and large regularization scenarios and reveal their distinct asymptotic dependency structures; 3. application: we apply our method to large COVID-19 network data sets and discover meaningful results.

翻译:$\ beta$ 模型是建模网络生成的强大工具, 由节点异质驱动。 它简单而明确的性质, 特别是井井井有条的大型网络, 许多网络模型由于计算方面的挑战和观测稀缺而变得不可行。 但是, $\ beta$模型的现有估算算法并不扩大; 理论理解仍然局限于密集的网络。 本文对 $\ beta$ 模型的方法和理论做了一些重大改进, 以解决实际应用的迫切需要。 我们的贡献包括: 1. 方法: 我们提出一个新的 $\ ell_ 2$ 惩罚的 MLE 方案; 我们设计了一种新型的算法, 能够舒适地处理数百万节点、 更快和更多的记忆- 差异性网络的稀少网络; 2. 理论: 我们在较弱的假设下对乙型模型提出新的错误; 我们还建立了新的低限制和新的无症状正常性结果; 与现有文献不同, 我们的结果覆盖了大小的正规化假设情景, 并揭示了它们独特的依赖性结构; 3. 应用我们的方法对大型的COVI 和有意义的数据探索结果。