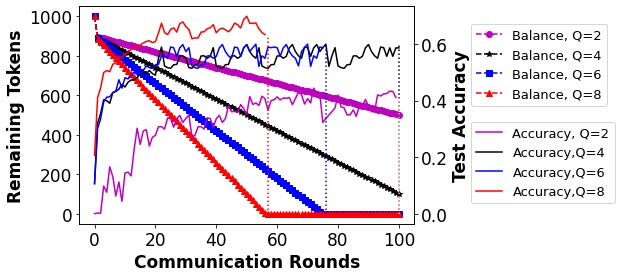

Incentives that compensate for the involved costs in the decentralized training of a Federated Learning (FL) model act as a key stimulus for clients' long-term participation. However, it is challenging to convince clients for quality participation in FL due to the absence of: (i) full information on the client's data quality and properties; (ii) the value of client's data contributions; and (iii) the trusted mechanism for monetary incentive offers. This often leads to poor efficiency in training and communication. While several works focus on strategic incentive designs and client selection to overcome this problem, there is a major knowledge gap in terms of an overall design tailored to the foreseen digital economy, including Web 3.0, while simultaneously meeting the learning objectives. To address this gap, we propose a contribution-based tokenized incentive scheme, namely \texttt{FedToken}, backed by blockchain technology that ensures fair allocation of tokens amongst the clients that corresponds to the valuation of their data during model training. Leveraging the engineered Shapley-based scheme, we first approximate the contribution of local models during model aggregation, then strategically schedule clients lowering the communication rounds for convergence and anchor ways to allocate \emph{affordable} tokens under a constrained monetary budget. Extensive simulations demonstrate the efficacy of our proposed method.

翻译:补偿联邦学习联合会(FL)模式分散培训所涉费用的奖励措施,是客户长期参与的关键刺激因素,然而,由于缺少:(一) 关于客户数据质量和属性的充分信息;(二) 客户数据贡献的价值;(三) 受信任的货币奖励提供机制,这往往导致培训和沟通效率低下。虽然若干工作的重点是战略激励设计和客户选择,以解决这一问题,但在根据设想的数字经济设计的整体设计方面,包括网络3.0,同时实现学习目标,存在着重大知识差距,难以说服客户高质量参与FL。为弥补这一差距,我们提议了一个基于捐款的象征性激励计划,即\ textt{FedToken},由能够确保客户在模型培训期间公平分配与其数据估值相匹配的象征性物品的链式技术提供支持。利用设计基于Shaply的计划,我们首先在模型集成过程中,然后在战略时间表上,在满足预期的数字经济目标方面,存在重大知识差距。为了解决这一差距,我们提议了一个基于捐款的象征性激励计划,即确保用户降低我们的拟议通信效率的趋同在模拟中的主要方法。