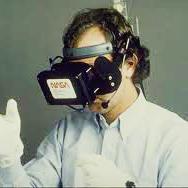

Virtual Reality headsets enable users to explore the environment by performing self-induced movements. The retinal velocity produced by such motion reduces the visual system's ability to resolve fine detail. We measured the impact of self-induced head rotations on the ability to detect quality changes of a realistic 3D model in an immersive virtual reality environment. We varied the Level-of-Detail (LOD) as a function of rotational head velocity with different degrees of severity. Using a psychophysical method, we asked 17 participants to identify which of the two presented intervals contained the higher quality model under two different maximum velocity conditions. After fitting psychometric functions to data relating the percentage of correct responses to the aggressiveness of LOD manipulations, we identified the threshold severity for which participants could reliably (75\%) detect the lower LOD model. Participants accepted an approximately four-fold LOD reduction even in the low maximum velocity condition without a significant impact on perceived quality, which suggests that there is considerable potential for optimisation when users are moving (increased range of perceptual uncertainty). Moreover, LOD could be degraded significantly more in the maximum head velocity condition, suggesting these effects are indeed speed dependent.

翻译:虚拟虚拟耳机使用户能够通过自引起运动来探索环境。这种运动产生的视网膜速度降低了视觉系统解决细细细节的能力。我们测量了自我引起的头部旋转对在浸泡式虚拟现实环境中检测现实的3D模型质量变化的能力的影响。我们通过以不同严重程度的旋转头部速度函数而将尾部水平(LOD)改变为四倍左右。我们使用心理物理方法,请17名与会者确定在两种不同的最大速度条件下,在两种显示的间隔中哪一个含有更高质量模型。在将与对液晶件操作的侵袭性正确反应的百分比有关的数据相适应后,我们确定了参与者能够可靠地检测低液晶件模型的临界严重性(75 ⁇ )。与会者接受了即使低最大速度条件下的低热量水平(LOD)降低约四倍,但不会对所觉察到的质量产生重大影响。这说明,在用户移动时,有相当的优化潜力(视界不确定性范围扩大 ) 。此外,在最大速度条件下,LODDD可能大大降低最大速度状态,表明这些影响取决于速度。