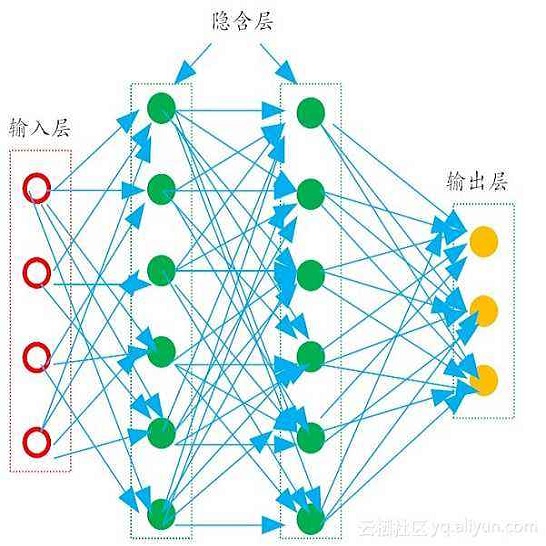

Hyperspectral images, which record the electromagnetic spectrum for a pixel in the image of a scene, often store hundreds of channels per pixel and contain an order of magnitude more information than a typical similarly-sized color image. Consequently, concomitant with the decreasing cost of capturing these images, there is a need to develop efficient techniques for storing, transmitting, and analyzing hyperspectral images. This paper develops a method for hyperspectral image compression using implicit neural representations where a multilayer perceptron network $\Phi_\theta$ with sinusoidal activation functions ``learns'' to map pixel locations to pixel intensities for a given hyperspectral image $I$. $\Phi_\theta$ thus acts as a compressed encoding of this image. The original image is reconstructed by evaluating $\Phi_\theta$ at each pixel location. We have evaluated our method on four benchmarks -- Indian Pines, Cuprite, Pavia University, and Jasper Ridge -- and we show the proposed method achieves better compression than JPEG, JPEG2000, PCA-DCT, and HVEC at low bitrates.

翻译:超光谱图像记录了像素的电磁频谱, 通常每像素存储数百个频道, 并包含比典型的类似彩色图像数量更多的数量级信息。 因此, 随着捕获这些图像的成本不断下降, 需要开发高效的存储、 传输和分析超光谱图像的技术。 本文开发了一种使用隐性神经表征的超光谱图像压缩方法, 多层透视网络 $\ Phi ⁇ theta$, 并带有正弦激活功能的“ learns” 将像素位置映射为超光谱图像的像素强度。 因此, $\ Phi ⁇ theta$ 成为了该图像的压缩编码。 原始图像通过对每个像素位置的 $\ Phi ⁇ theta$进行评估来重建。 我们在四个基准上评估了我们的方法 -- 印度派恩斯、 Cuprite、 Pavia 大学和 Jasper Ridge -- 我们展示了拟议方法比低位数的JPEG、 JEG2000、 CP-DCT和HVVVEC得到更好的压缩。