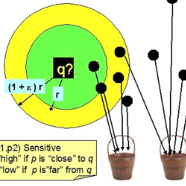

The indexing algorithms for the high-dimensional nearest neighbor search (NNS) with the best worst-case guarantees are based on the randomized Locality Sensitive Hashing (LSH), and its derivatives. In practice, many heuristic approaches exist to "learn" the best indexing method in order to speed-up NNS, crucially adapting to the structure of the given dataset. Oftentimes, these heuristics outperform the LSH-based algorithms on real datasets, but, almost always, come at the cost of losing the guarantees of either correctness or robust performance on adversarial queries, or apply to datasets with an assumed extra structure/model. In this paper, we design an NNS algorithm for the Hamming space that has worst-case guarantees essentially matching that of theoretical algorithms, while optimizing the hashing to the structure of the dataset (think instance-optimal algorithms) for performance on the minimum-performing query. We evaluate the algorithm's ability to optimize for a given dataset both theoretically and practically. On the theoretical side, we exhibit a natural setting (dataset model) where our algorithm is much better than the standard theoretical one. On the practical side, we run experiments that show that our algorithm has a 1.8x and 2.1x better recall on the worst-performing queries to the MNIST and ImageNet datasets.

翻译:具有最坏的保证的近距离近距离搜索高维的索引算法( NNS ) 以随机的局部敏感散列( LSH) 及其衍生物为基础。 在实践中, 许多超自然法方法都存在“ 清除” 最佳索引方法, 以加速 NNS, 关键地适应给定数据集的结构。 这些超自然比基于LSH 的算法在真实数据集上的性能更优, 但几乎总是以在对抗性查询中丧失正确性能或强力性能的保证, 或以假设的额外结构/ 模型适用于数据集为代价。 在本文中, 我们为Hamming 空间设计了一种“ 清除” 最佳索引方法, 以加速 NNS, 以加速给给给定的数据集结构做出至关重要的调整。 通常, 这些超自然法方法比实际性能查询更优。 我们评估算法的能力, 以最优的理论角度和实用性能模型展示了我们最差的模型。