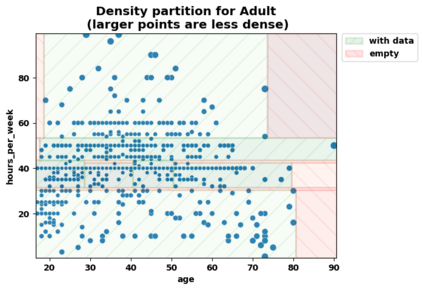

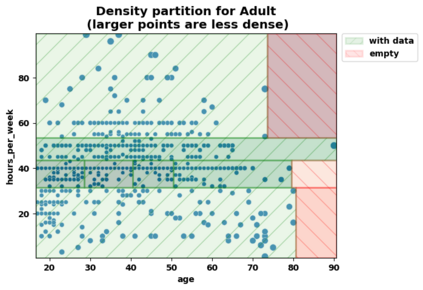

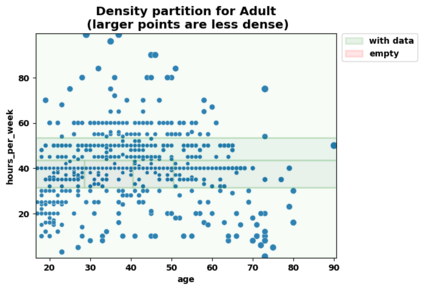

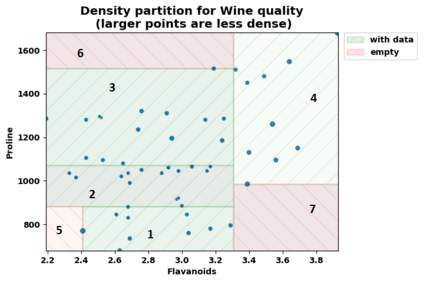

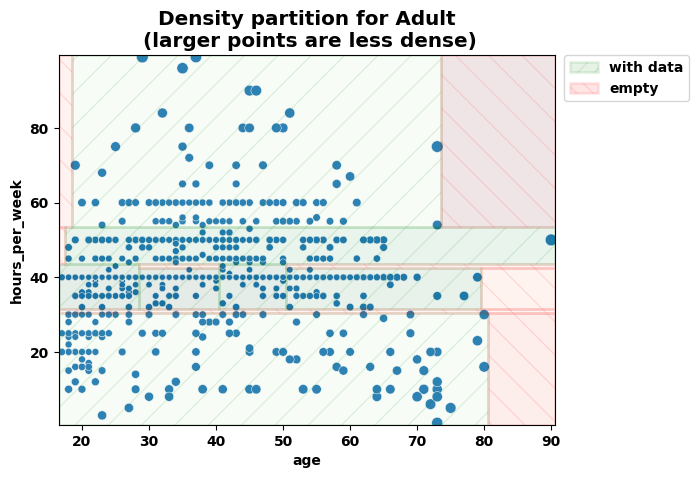

Consider a structured dataset of features, such as $\{\textrm{SEX}, \textrm{INCOME}, \textrm{RACE}, \textrm{EXPERIENCE}\}$. A user may want to know where in the feature space observations are concentrated, and where it is sparse or empty. The existence of large sparse or empty regions can provide domain knowledge of soft or hard feature constraints (e.g., what is the typical income range, or that it may be unlikely to have a high income with few years of work experience). Also, these can suggest to the user that machine learning (ML) model predictions for data inputs in sparse or empty regions may be unreliable. An interpretable region is a hyper-rectangle, such as $\{\textrm{RACE} \in\{\textrm{Black}, \textrm{White}\}\}\:\&$ $\{10 \leq \:\textrm{EXPERIENCE} \:\leq 13\}$, containing all observations satisfying the constraints; typically, such regions are defined by a small number of features. Our method constructs an observation density-based partition of the observed feature space in the dataset into such regions. It has a number of advantages over others in that it works on features of mixed type (numeric or categorical) in the original domain, and can separate out empty regions as well. As can be seen from visualizations, the resulting partitions accord with spatial groupings that a human eye might identify; the results should thus extend to higher dimensions. We also show some applications of the partition to other data analysis tasks, such as inferring about ML model error, measuring high-dimensional density variability, and causal inference for treatment effect. Many of these applications are made possible by the hyper-rectangular form of the partition regions.

翻译:考虑一个结构化的功能数据集, 例如 ${textrm{SEX},\ textrm{ INCOME},\ textrm{ RACE},\ textrm{ EXPERIEN} 。 用户可能想知道在特性空间观测中哪里集中, 哪里是稀疏或空的。 大量稀疏或空区域的存在可以提供软性或硬性特性限制的域知识( 例如, 典型的收入范围是什么, 或者它不太可能有高收入, 工作经历几年。 此外, 这些可以向用户表明, 机器学习( ML) 用于在稀薄或空区域输入数据输入数据的模型预测值可能不可靠 。 这样的可解释区域, 例如 $\ textrm{ { { black} 、\ textrumrm{ { { { { { } { { { {dextleq\\ :\\\\ textrm=q 13} 13_\\\\\\\\\\\\\\\\\\\\\\\\\\\ la, 包含所有观测限制, 包含所有观察限制 ; ral deal real real real real real real deal deal deal dealessalessaless; mapsal deal deal made mads made made dis madeal deal deal deal ral ral deal deal deal deal deal deal ral deal deal mads mads mads mads mas mas 。