题目: Interpreting Interpretability: Understanding Data Scientists’Use of Interpretability Tools for Machine Learning

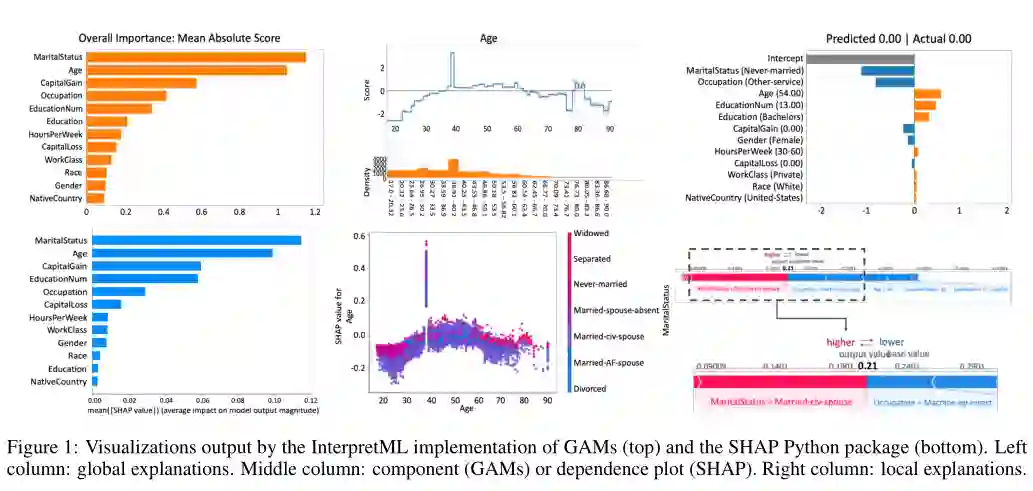

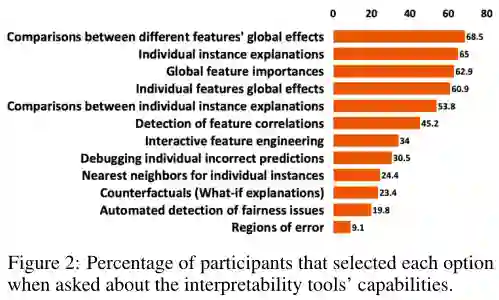

摘要: 机器学习(ML)模型现在经常应用于从刑事司法到医疗保健的各个领域。随着这种新发现的普遍性,ML已经超越了学术界,发展成为一门工程学科。为此,设计了解释工具来帮助数据科学家和机器学习实践者更好地理解ML模型的工作方式。然而,很少有人评估这些工具在多大程度上实现了这一目标。我们研究数据技术人员使用两种现有的解释性工具,GAMs的解释性ml实现和SHAP Python包。我们对数据科学家进行了背景调查(N=11)和调查(N=197),以观察他们如何使用可解释性工具来发现在构建和计算ML模型时出现的常见问题。我们的结果表明,数据科学家过度信任和滥用解释工具。此外,我们的参与者很少能够准确地描述这些工具的可视化输出。我们为数据科学家强调可解释工具的心智模型的定性主题。我们总结了对研究人员和工具设计者的启示,并将我们的发现置于社会科学文献的背景中。

成为VIP会员查看完整内容