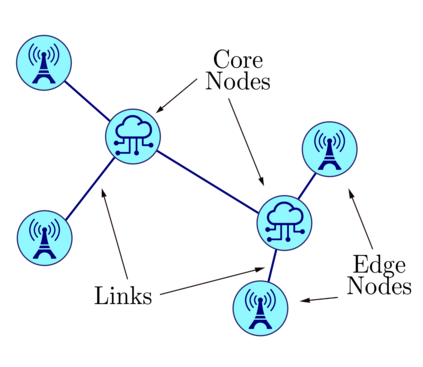

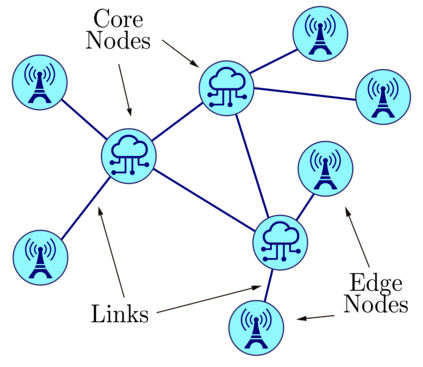

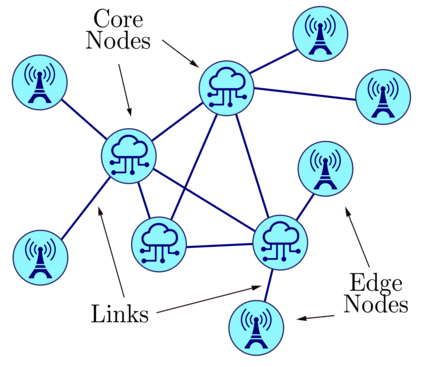

The Network Slicing (NS) paradigm enables the partition of physical and virtual resources among multiple logical networks, possibly managed by different tenants. In such a scenario, network resources need to be dynamically allocated according to the slices' requirements. In this paper, we attack the above problem by exploiting a Deep Reinforcement Learning approach. Our framework is based on a distributed architecture, where multiple agents cooperate towards a common goal. The agents' training is carried out following the Advantage Actor Critic algorithm, which allows to handle continuous action spaces. By means of extensive simulations, we show that our approach yields better performance than both a static allocation of system resources and an efficient empirical strategy. At the same time, the proposed system ensures high adaptability to different scenarios without the need for additional training.

翻译:网络切除(NS)范式可以将物质和虚拟资源分成多种逻辑网络,可能由不同的租户管理。在这样的情况下,网络资源需要根据切片的要求进行动态分配。在本文中,我们通过利用深强化学习方法来应对上述问题。我们的框架基于一个分布式结构,其中多个代理机构为共同目标进行合作。代理机构的培训遵循“优势动因曲线算法”进行,该算法可以处理连续行动空间。通过广泛的模拟,我们证明我们的方法比静态分配系统资源和高效的经验战略都效果更好。与此同时,拟议的系统可以确保高度适应不同的情景,而不需要额外的培训。