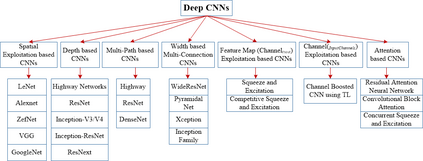

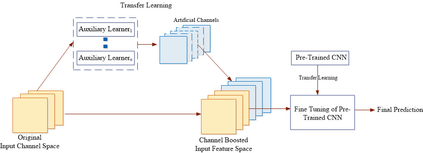

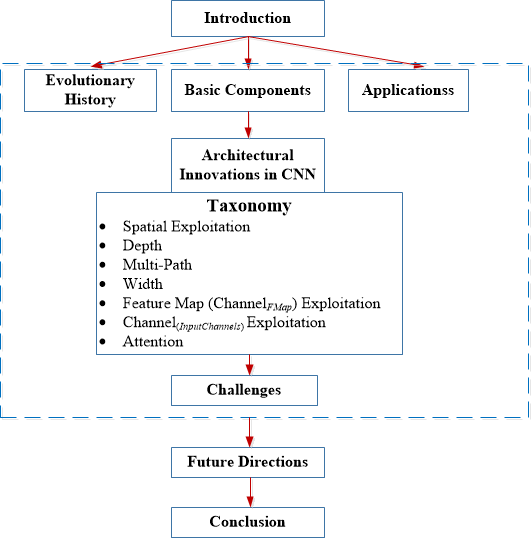

Deep Convolutional Neural Networks (CNNs) are a special type of Neural Networks, which have shown state-of-the-art results on various competitive benchmarks. The powerful learning ability of deep CNN is largely achieved with the use of multiple non-linear feature extraction stages that can automatically learn hierarchical representation from the data. Availability of a large amount of data and improvements in the hardware processing units have accelerated the research in CNNs and recently very interesting deep CNN architectures are reported. The recent race in deep CNN architectures for achieving high performance on the challenging benchmarks has shown that the innovative architectural ideas, as well as parameter optimization, can improve the CNN performance on various vision-related tasks. In this regard, different ideas in the CNN design have been explored such as use of different activation and loss functions, parameter optimization, regularization, and restructuring of processing units. However, the major improvement in representational capacity is achieved by the restructuring of the processing units. Especially, the idea of using a block as a structural unit instead of a layer is gaining substantial appreciation. This survey thus focuses on the intrinsic taxonomy present in the recently reported CNN architectures and consequently, classifies the recent innovations in CNN architectures into seven different categories. These seven categories are based on spatial exploitation, depth, multi-path, width, feature map exploitation, channel boosting and attention. Additionally, it covers the elementary understanding of the CNN components and sheds light on the current challenges and applications of CNNs.

翻译:深革命神经网络(CNNs)是一种特殊的神经网络,它显示了各种竞争性基准的先进成果。深有CNN的强大学习能力主要通过使用多种非线性特征提取阶段实现,这些阶段可以自动从数据中学习等级代表; 大量数据和硬件处理单位的改进加快了CNN和最近非常有趣的深层CNN结构的研究。 近些年来在深层次CNN结构中竞相争取在具有挑战性的基准上取得高绩效,这表明创新的建筑理念以及参数优化可以改进CNN在各种与愿景有关的任务方面的业绩。在这方面,对CNN设计中的不同想法进行了探索,例如使用不同的激活和损失功能、参数优化、规范化和调整处理单位的重组。然而,通过对处理单位的重组,代表能力有了重大改善。 特别是,利用一个区块作为结构而不是一个层的想法正在获得大量赞赏。本次调查侧重于最近报道的CNN结构结构中的内在分类以及参数优化,从而提升了CNN在各种愿景相关任务方面的业绩。在这方面,CNN设计中的不同想法已经根据最新的空间结构的深度,将最近对频道的探索,这些结构的深度进行了分类,这些结构的深度的深度,这些结构的深度进行了分类。