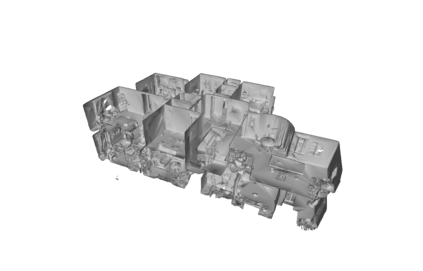

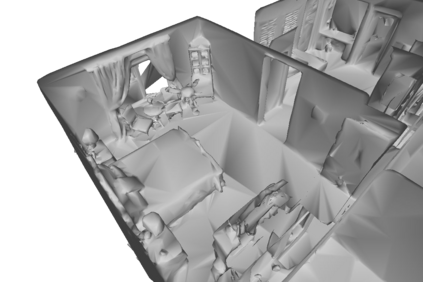

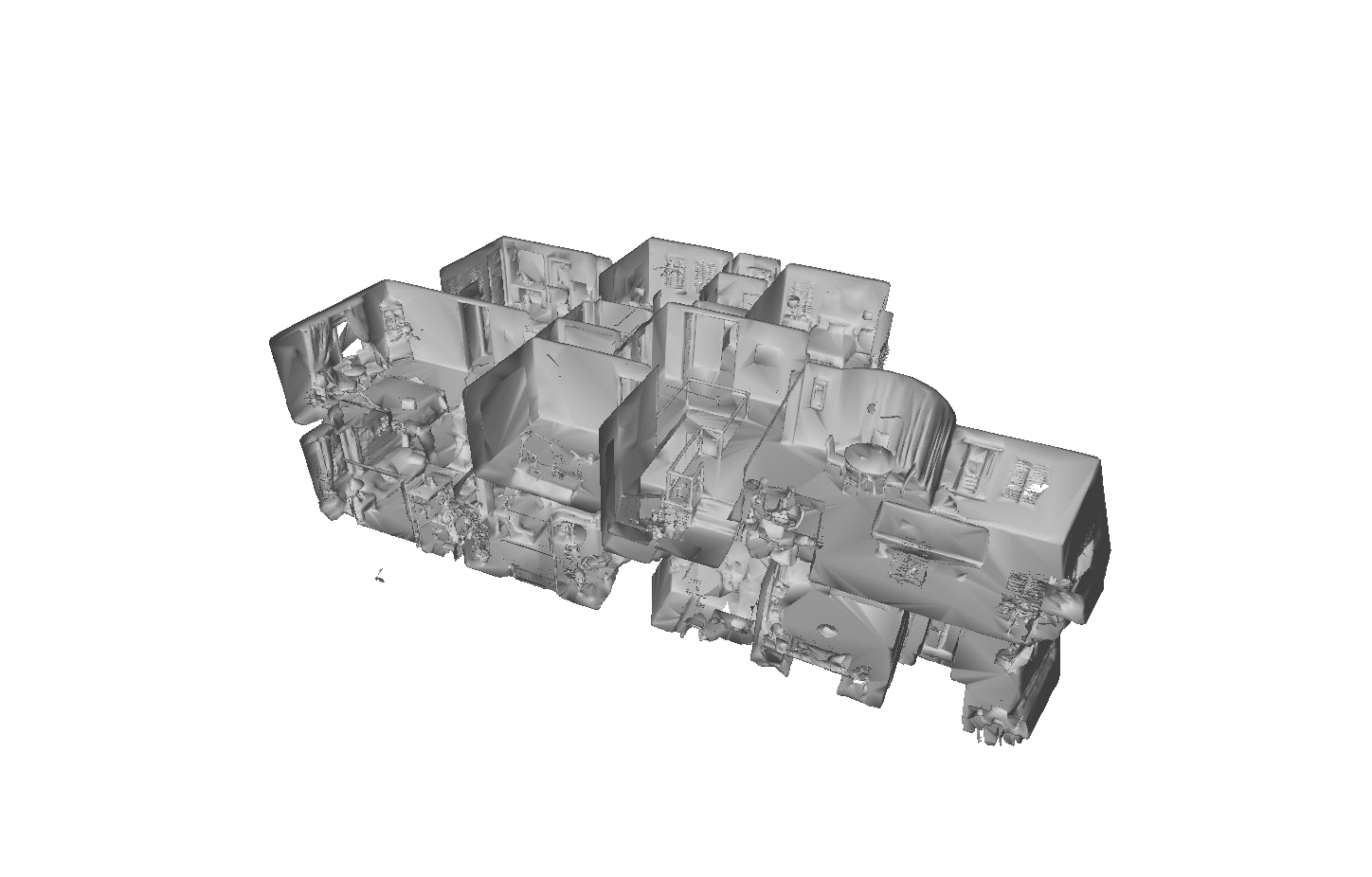

Graph Neural Networks (GNNs) have emerged as a flexible and powerful approach for learning over graphs. Despite this success, existing GNNs are constrained by their local message-passing architecture and are provably limited in their expressive power. In this work, we propose a new GNN architecture -- the Neural Tree. The neural tree architecture does not perform message passing on the input graph, but on a tree-structured graph, called the H-tree, that is constructed from the input graph. Nodes in the H-tree correspond to subgraphs in the input graph, and they are reorganized in a hierarchical manner such that the parent of a node in the H-tree always corresponds to a larger subgraph in the input graph. We show that the neural tree architecture can approximate any smooth probability distribution function over an undirected graph. We also prove that the number of parameters needed to achieve an $\epsilon$-approximation of the distribution function is exponential in the treewidth of the input graph, but linear in its size. We prove that any continuous $\mathcal{G}$-invariant/equivariant function can be approximated by a nonlinear combination of such probability distribution functions over $\mathcal{G}$. We apply the neural tree to semi-supervised node classification in 3D scene graphs, and show that these theoretical properties translate into significant gains in prediction accuracy, over the more traditional GNN architectures. We also show the applicability of the neural tree architecture to citation networks with large treewidth, by using a graph sub-sampling technique.

翻译:神经树结构( GNNs) 是一个灵活而有力的方法, 用于在图形上学习。 尽管取得了这一成功, 现有的 GNNs 仍然受到本地信息传递结构的限制, 并且其表达力也受到限制。 在此工作中, 我们提议一个新的 GNN 结构( 神经树 ) 。 神经树结构在输入图上并不显示信息传递方式, 而是在从输入图中构造的树结构图上, 称为 H树。 H树的节点与输入图中的子图相对应, 并且以等级方式重组, 使得 H树的传统节点的母端始终与输入图中的更大的子图相匹配。 我们显示, 神经树结构结构可以比任何光亮的概率分布功能, 而在输入图的树结构中, 我们证明, 连续的 $macal 直径直径直径网络的直径直径值 { GG} 直径直径直径直径直径直径直径的直径直径直径直径直径直径直径直径直径直径直径直径直线的直径直径直径直径直径, 。 我们证明, 直径直径直径直的直的直径直径直径直直的直直直直直直的直直直的直的直的直直直向直向直向直的直的直的直的直的直向直径直径直向直直的直的直的直的直的直的直的直的直的直的直的直的直方向的直方向的直方向直方向直方方方方方形的直方方形的直的直的直方向的直的直方形的直方形的直的直的直方形的直方形的直方形的直方形的直的直方方方方方方方方方的直方方方方方方方方方方方方方方方方方方方方的直方的直方的直方方方方方方方方方方方方方形的直方方方方方方形的直方形的直方方方方方方方方形方形方方方方方方方方方方方方方方方方方