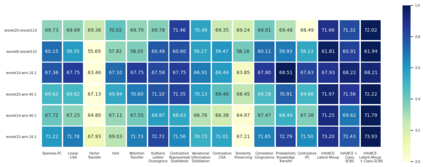

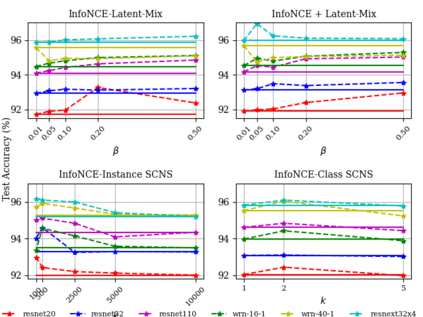

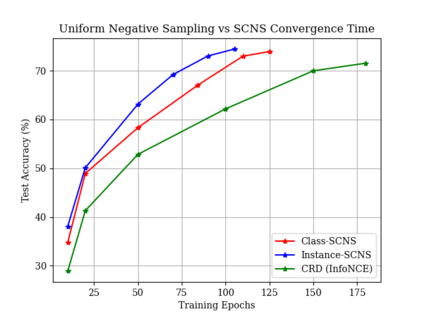

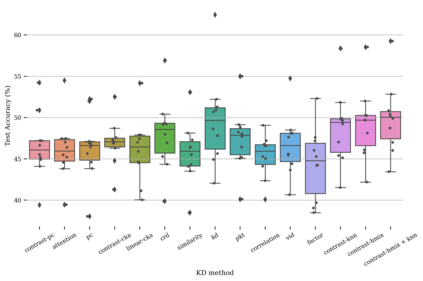

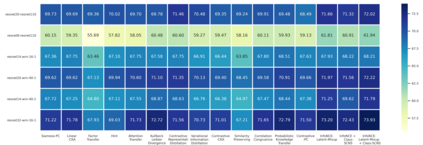

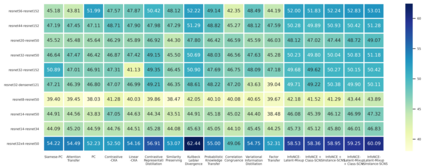

Negative sampling is a limiting factor w.r.t. the generalization of metric-learned neural networks. We show that uniform negative sampling provides little information about the class boundaries and thus propose three novel techniques for efficient negative sampling: drawing negative samples from (1) the top-$k$ most semantically similar classes, (2) the top-$k$ most semantically similar samples and (3) interpolating between contrastive latent representations to create pseudo negatives. Our experiments on CIFAR-10, CIFAR-100 and Tiny-ImageNet-200 show that our proposed \textit{Semantically Conditioned Negative Sampling} and Latent Mixup lead to consistent performance improvements. In the standard supervised learning setting, on average we increase test accuracy by 1.52\% percentage points on CIFAR-10 across various network architectures. In the knowledge distillation setting, (1) the performance of student networks increase by 4.56\% percentage points on Tiny-ImageNet-200 and 3.29\% on CIFAR-100 over student networks trained with no teacher and (2) 1.23\% and 1.72\% respectively over a \textit{hard-to-beat} baseline (Hinton et al., 2015).

翻译:负抽样是限制大量获得神经网络的通用系数。我们显示,统一的负抽样很少提供关于分类界限的信息,因此提出了三种新的有效负面抽样技术:从以下各种网络结构中从以下各种标准监督的学习环境中采集负样品:(1) 最上-美元最相似的细胞类,(2) 最上-美元最相似的细胞类,(3) 将对比性潜影图象间推,以产生假负数。我们在CIFAR-10、CIFAR-100和Tiny-ImagageNet-200的实验显示,我们拟议的“Textit{Smantical condiscrime 负抽样} 和Litetent Mixup 导致一致的性能改进。在标准监督的学习环境中,我们平均将CIFAR-10的测试精确度提高1.52个百分点。在知识蒸馏过程中,(1) 学生网络在Tini-ImageNet-200和3.29 ⁇ 方面的表现增加了4.56个百分点,在CFAR-100学生网络上,在没有受过师培训的学生网络上增加了(2) 1.23 ⁇ 和1.72× 和1.72* 基本基准(分别为2015)。