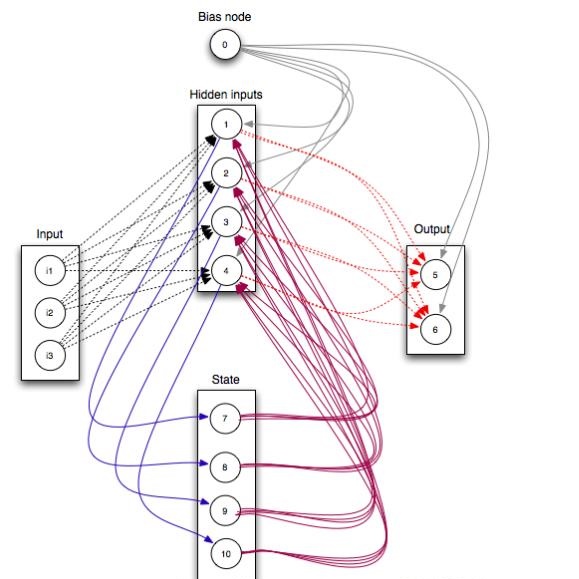

We study the type of distributions that Restricted Boltzmann Machines (RBMs) with different activation functions can express by investigating the effect of the activation function of the hidden nodes on the marginal distribution they impose on observed binary nodes. We report an exact expression for these marginals in the form of a model of interacting binary variables with the explicit form of the interactions depending on the hidden node activation function. We study the properties of these interactions in detail and evaluate how the accuracy with which the RBM approximates distributions over binary variables depends on the hidden node activation function and on the number of hidden nodes. When the inferred RBM parameters are weak, an intuitive pattern is found for the expression of the interaction terms which reduces substantially the differences across activation functions. We show that the weak parameter approximation is a good approximation for different RBMs trained on the MNIST dataset. Interestingly, in these cases, the mapping reveals that the inferred models are essentially low order interaction models.

翻译:我们通过调查隐藏节点的激活功能对观测到的二进制节点的边际分布的影响来研究具有不同激活功能的波尔兹曼机器(RBMs)能够表现的分布类型。我们以互动二进制变量模型的形式报告这些边际分布的确切表达方式,这种边际变量的明显形式取决于隐藏节点激活功能。我们详细研究这些互动的特性,并评估成果管理制如何精确地接近二进制变量的分布,取决于隐藏节点激活功能和隐藏节点的数量。当推断的BM参数较弱时,发现一种直观模式来表达互动术语的表达方式,这种互动术语大大缩小了不同激活功能之间的差异。我们表明,弱的参数近似度对于在MNIST数据集上培训的不同按成果管理制来说是一个很好的近似。有趣的是,在这些情况下,绘图显示所推断的模型基本上是低顺序互动模型。