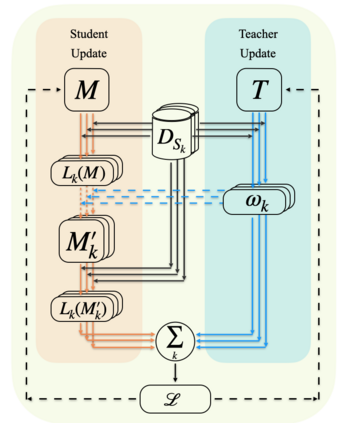

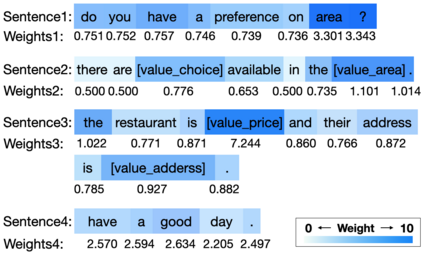

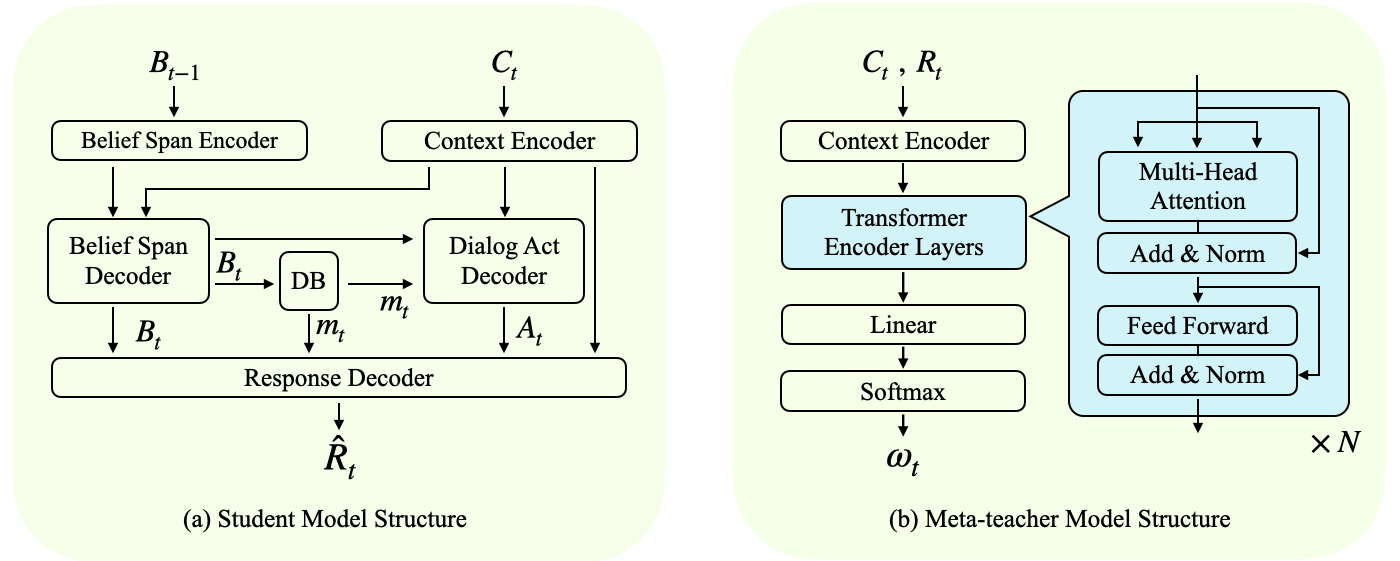

Numerous new dialog domains are being created every day while collecting data for these domains is extremely costly since it involves human interactions. Therefore, it is essential to develop algorithms that can adapt to different domains efficiently when building data-driven dialog models. The most recent researches on domain adaption focus on giving the model a better initialization, rather than optimizing the adaptation process. We propose an efficient domain adaptive task-oriented dialog system model, which incorporates a meta-teacher model to emphasize the different impacts between generated tokens with respect to the context. We first train our base dialog model and meta-teacher model adversarially in a meta-learning setting on rich-resource domains. The meta-teacher learns to quantify the importance of tokens under different contexts across different domains. During adaptation, the meta-teacher guides the dialog model to focus on important tokens in order to achieve better adaptation efficiency. We evaluate our model on two multi-domain datasets, MultiWOZ and Google Schema-Guided Dialogue, and achieve state-of-the-art performance.

翻译:在为这些域收集数据的同时,每天都在创建许多新的对话域,费用极高,因为它涉及人类互动。 因此,必须开发算法,在建立数据驱动的对话模型时,能够有效地适应不同领域。 最近关于域适应的研究侧重于使模型更好地初始化,而不是优化适应进程。 我们提议一个高效的域适应任务导向对话系统模型,其中包括一个元教师模型,以强调生成的标牌之间对上下文的不同影响。 我们首先在丰富资源域的元学习环境中对基本对话模型和元教师模型进行对抗性培训。 元教师学会在不同领域不同背景下量化标码的重要性。 在适应期间,元教师指导对话模型侧重于重要标码,以提高适应效率。 我们评估了我们关于两个多域数据集的模型,即多WOZ 和 Google Schema-Guided 对话, 并实现了最先进的业绩。