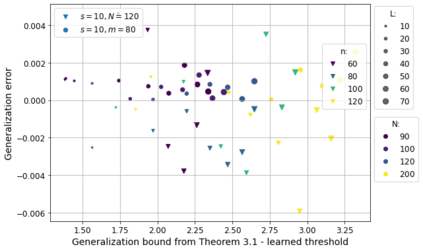

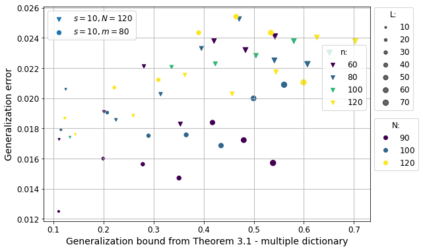

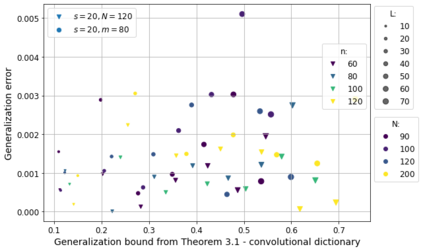

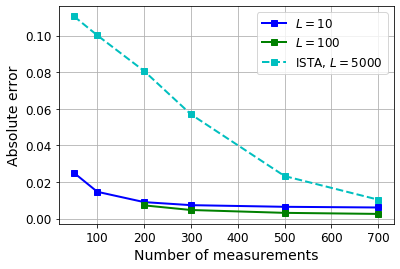

Motivated by the learned iterative soft thresholding algorithm (LISTA), we introduce a general class of neural networks suitable for sparse reconstruction from few linear measurements. By allowing a wide range of degrees of weight-sharing between the layers, we enable a unified analysis for very different neural network types, ranging from recurrent ones to networks more similar to standard feedforward neural networks. Based on training samples, via empirical risk minimization we aim at learning the optimal network parameters and thereby the optimal network that reconstructs signals from their low-dimensional linear measurements. We derive generalization bounds by analyzing the Rademacher complexity of hypothesis classes consisting of such deep networks, that also take into account the thresholding parameters. We obtain estimates of the sample complexity that essentially depend only linearly on the number of parameters and on the depth. We apply our main result to obtain specific generalization bounds for several practical examples, including different algorithms for (implicit) dictionary learning, and convolutional neural networks.

翻译:以学习的迭代软阈值算法(LISTA)为动力,我们引入了适合从少数线性测量中稀释重建的普通神经网络类别。通过允许各层之间进行广泛程度的权重共享,我们得以对非常不同的神经网络类型进行统一分析,从重复的神经网络到更类似于标准进料神经网络。根据培训样本,通过实验风险最小化,我们通过实验风险最小化,旨在学习最佳网络参数,从而从低维线性线性测量中重建信号的最佳网络。我们通过分析由这种深度网络组成的雷德马赫综合假设类别(Rademacher)的复杂度,并同时考虑到临界参数。我们获得了样本复杂性的估计,这些复杂性基本上仅线性地取决于参数数量和深度。我们的主要结果是为了获得几个实际实例的具体的概括界限,包括(隐蔽的)字典学习的不同算法和革命神经网络。