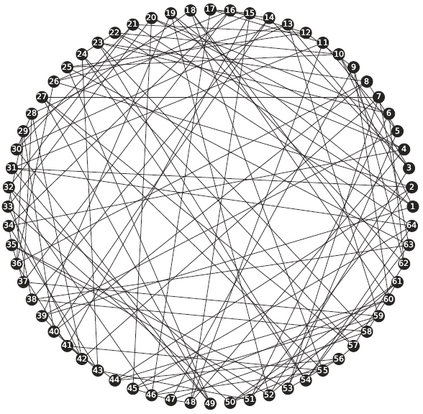

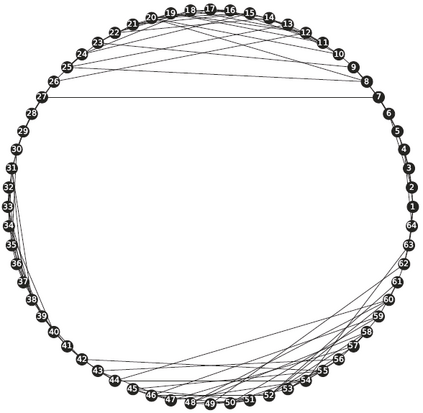

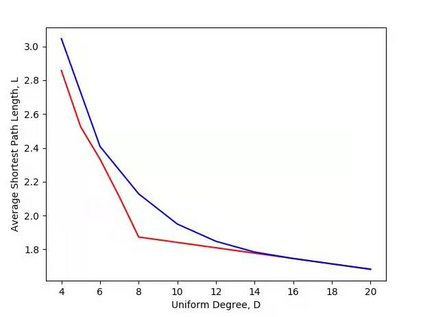

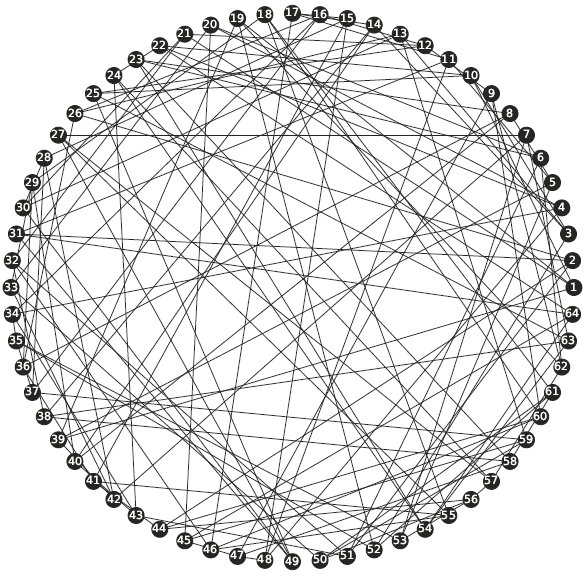

Lightweight model design has become an important direction in the application of deep learning technology, pruning is an effective mean to achieve a large reduction in model parameters and FLOPs. The existing neural network pruning methods mostly start from the importance of parameters, and design parameter evaluation metrics to perform parameter pruning iteratively. These methods are not studied from the perspective of model topology, may be effective but not efficient, and requires completely different pruning for different datasets. In this paper, we study the graph structure of the neural network, and propose regular graph based pruning (RGP) to perform a one-shot neural network pruning. We generate a regular graph, set the node degree value of the graph to meet the pruning ratio, and reduce the average shortest path length of the graph by swapping the edges to obtain the optimal edge distribution. Finally, the obtained graph is mapped into a neural network structure to realize pruning. Experiments show that the average shortest path length of the graph is negatively correlated with the classification accuracy of the corresponding neural network, and the proposed RGP shows a strong precision retention capability with extremely high parameter reduction (more than 90%) and FLOPs reduction (more than 90%).

翻译:轻量制模型设计已成为应用深层学习技术的一个重要方向, 修剪是实现大幅削减模型参数和 FLOPs 的有效手段。 现有的神经网络修剪方法主要从参数的重要性开始, 设计参数评价度量来进行参数的迭接。 这些方法不是从模型地形学的角度研究的, 可能有效, 但效率不高, 并且要求对不同的数据集进行完全不同的修剪。 在本文中, 我们研究神经网络的图形结构, 并提议以图形为基础的常规修剪线( RGP) 来进行单向神经网络修剪裁。 我们生成一个常规图形, 设定图形的节度值以适应修剪裁率, 并通过对边缘进行交换以获得最佳边缘分布来缩短图形的平均最短路径长度。 最后, 获得的图形被映射到神经网络结构中, 以实现修剪裁。 实验显示, 该图的平均最短路径长度与相应的神经网络的分类精度存在负关联性关系, 以及拟议的 RGP 90 精确性递减率( 比 90 % ) 强, 和精确性缩缩缩 。