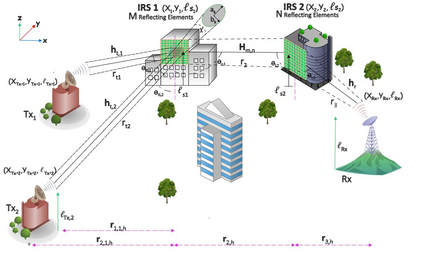

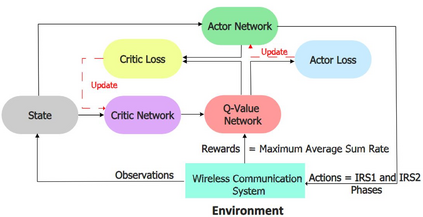

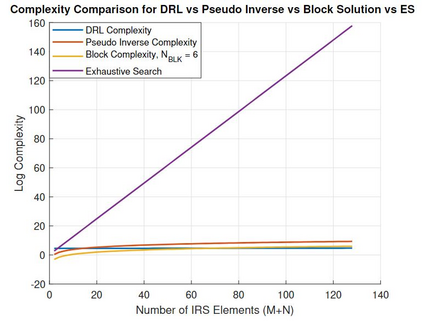

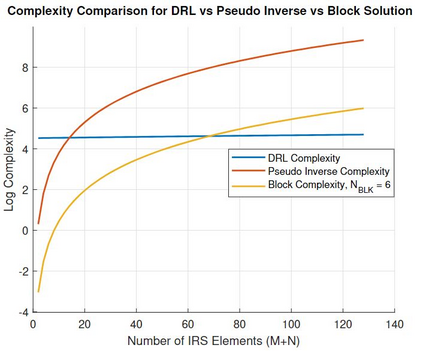

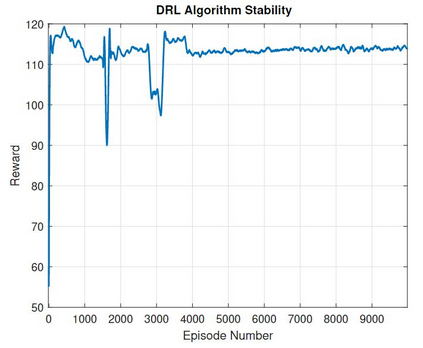

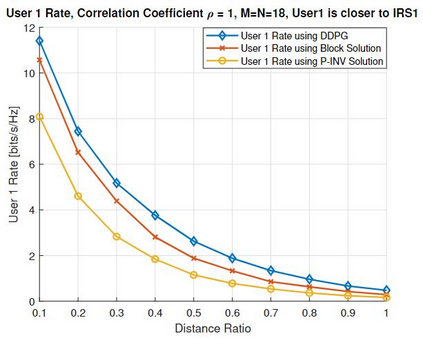

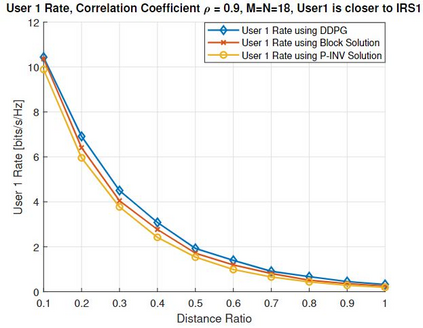

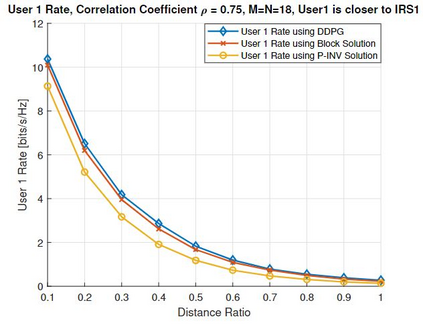

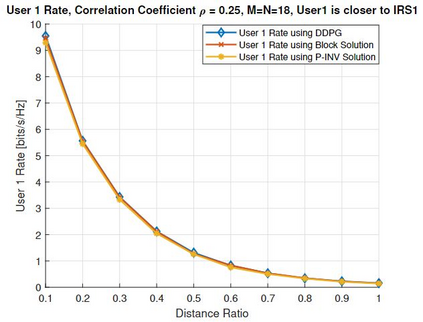

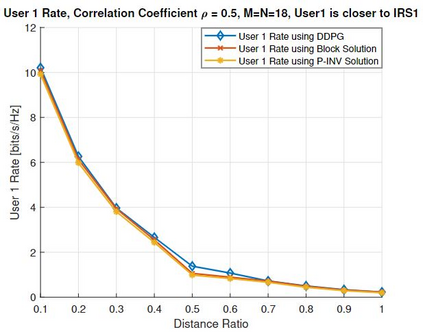

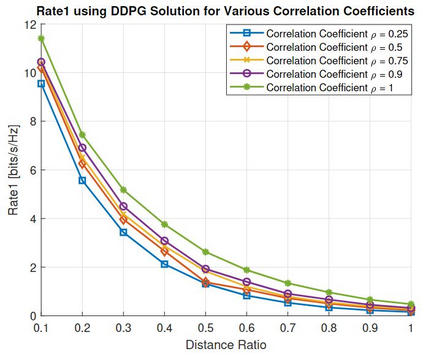

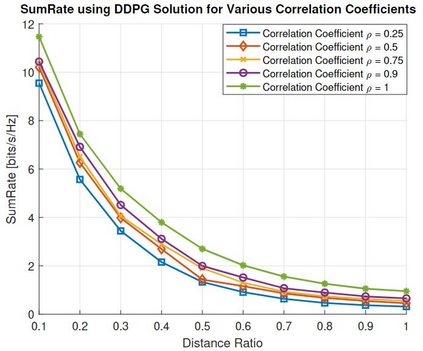

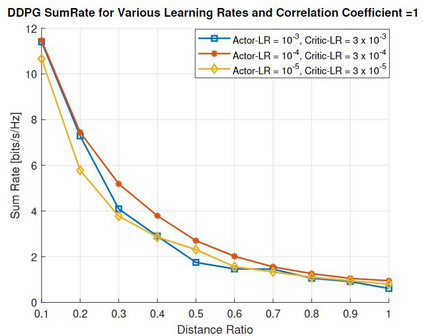

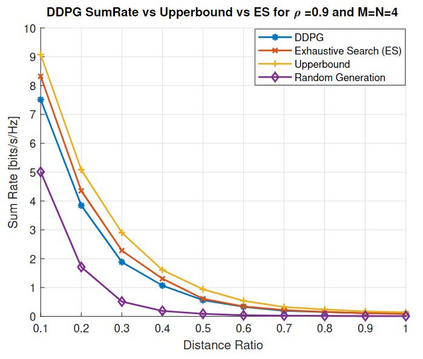

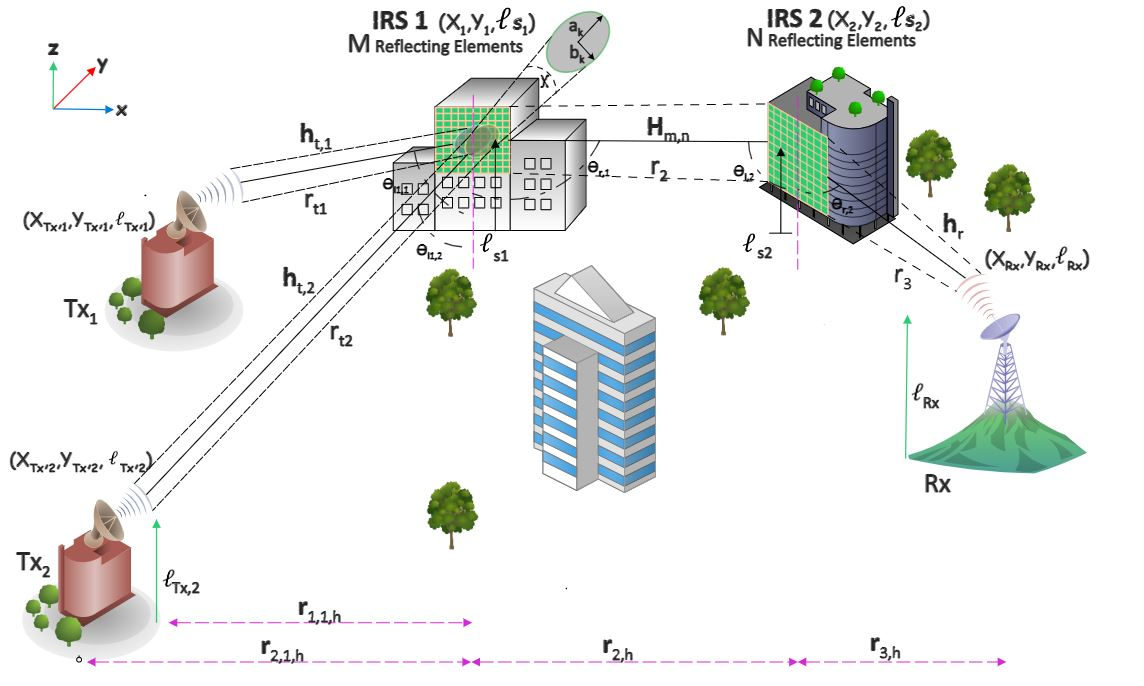

We investigate THz communication uplink multiple access using cascaded intelligent reflecting surfaces (IRSs) assuming correlated channels. Two independent objectives to be achieved via adjusting the phases of the cascaded IRSs: 1) maximizing the received rate of a desired user under interference from the second user and 2) maximizing the sum rate of both users. The resulting optimization problems are non-convex. For the first objective, we devise a sub-optimal analytical solution by maximizing the received power of the desired user, however, this results in an over determined system. Approximate solutions using pseudo-inverse and block-based approaches are attempted. For the second objective, a loose upperbound is derived and an exhaustive search solution is utilized. We then use deep reinforcement learning (DRL) to solve both objectives. Results reveal the suitability of DRL for such complex configurations. For the first objective, the DRL-based solution is superior to the sub-optimal mathematical methods, while for the second objective, it produces sum rates almost close to the exhaustive search. Further, the results reveal that as the correlation-coefficient increases, the sum rate of DRL increases, since it benefits from the presence of correlation in the channel to improve statistical learning.

翻译:我们调查THZ通信上链接多重访问,使用级联智能反射表面(IRS),假设相关渠道。通过调整级联IRS的阶段,将实现两个独立的目标:1)在第二个用户的干扰下,最大限度地提高理想用户的接收率,2)使两个用户的总和率最大化。因此产生的优化问题是非康维克斯。关于第一个目标,我们设计了一个亚最佳分析解决方案,最大限度地提高理想用户的接收力,但这一分析解决方案的结果是一个过度确定的系统。尝试了使用伪反向和块基方法的近似解决方案。关于第二个目标,取出一个松散的上限,并使用一个详尽的搜索解决方案。我们随后使用深度强化学习(DRL)来解决这两个目标。结果显示DRL适合这种复杂的配置。关于第一个目标,基于DRL的解决方案优于亚最佳数学方法,而对于第二个目标,其总和率几乎接近于详尽的搜索。此外,结果显示,随着相关性的提高,DRL的统计流点的学习率从统计渠道的学习得益。</s>