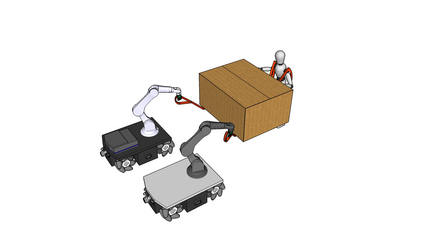

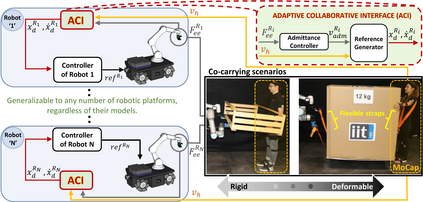

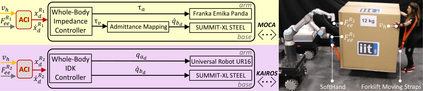

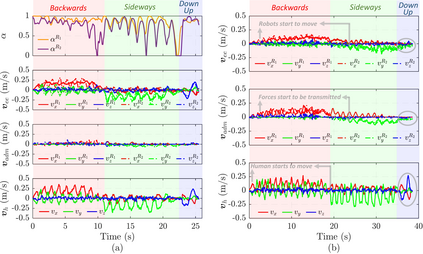

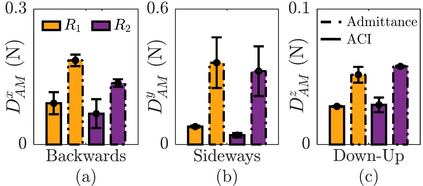

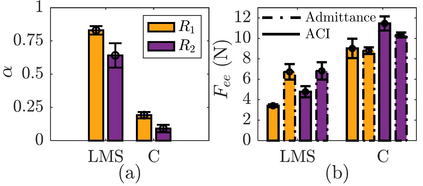

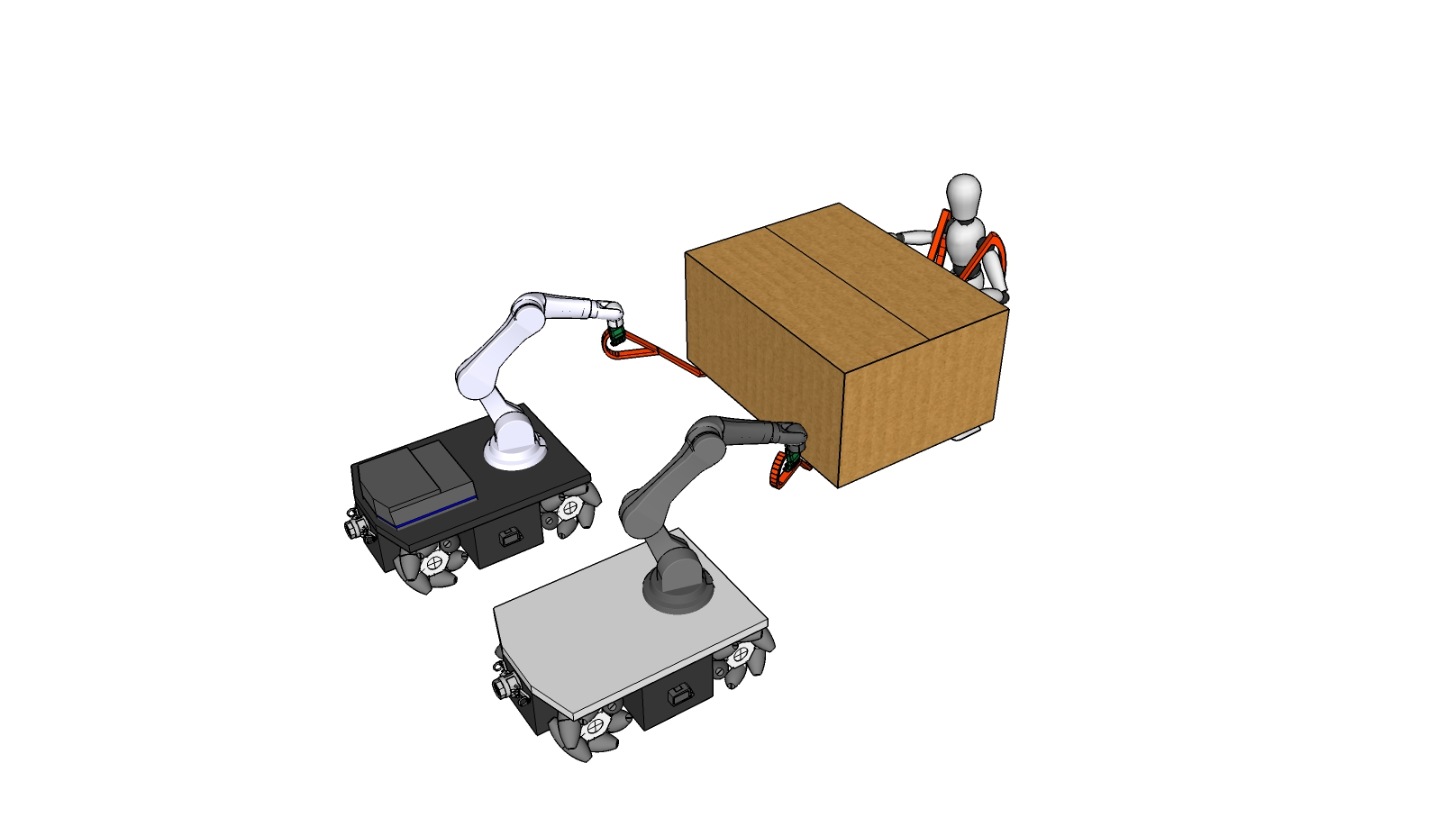

This manuscript introduces an object deformability-agnostic framework for co-carrying tasks that are shared between a person and multiple robots. Our approach allows the full control of the co-carrying trajectories by the person while sharing the load with multiple robots depending on the size and the weight of the object. This is achieved by merging the haptic information transferred through the object and the human motion information obtained from a motion capture system. One important advantage of the framework is that no strict internal communication is required between the robots, regardless of the object size and deformation characteristics. We validate the framework with two challenging real-world scenarios: co-transportation of a wooden rigid closet and a bulky box on top of forklift moving straps, with the latter characterizing deformable objects. In order to evaluate the generalizability of the proposed framework, a heterogenous team of two mobile manipulators that consist of an Omni-directional mobile base and a collaborative robotic arm with different DoFs is chosen for the experiments. The qualitative comparison between our controller and the baseline controller (i.e., an admittance controller) during these experiments demonstrated the effectiveness of the proposed framework especially when co-carrying deformable objects. Furthermore, we believe that the performance of our framework during the experiment with the lifting straps offers a promising solution for the co-transportation of bulky and ungraspable objects.

翻译:本手稿引入了个人与多个机器人共同承担的共载任务对象变形-不可知性框架, 由个人和多个机器人共享。 我们的方法允许在与多个机器人根据对象的大小和重量与多个机器人共享负载的同时, 完全控制个人共同携带的轨迹。 这是通过将通过天体传输的偶然信息与从运动抓捕系统中获取的人类运动信息合并而实现的。 这个框架的一个重要优点是, 机器人之间不需要严格的内部通信, 不论物体大小和变形特点。 我们用两种具有挑战性的现实世界情景来验证这个框架: 木制僵硬衣柜和在叉式移动带顶部的散装箱共同运输, 而后一则以可变形物体为特征。 为了评估拟议框架的可概括性, 一个由两部移动操纵器组成的杂乱的团队, 以及一个与不同的DoFs合作的机器人臂。 我们的控制器和基线控制器( i. i. accred contraction controduction contralation) 在这些实验期间展示了我们特别有希望的升级的系统框架。