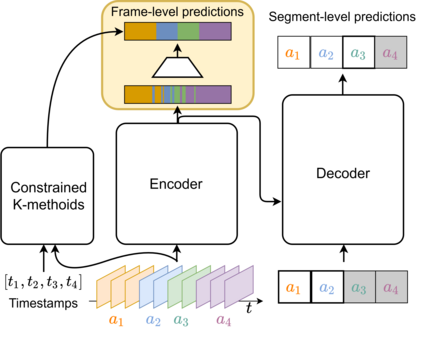

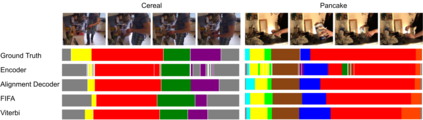

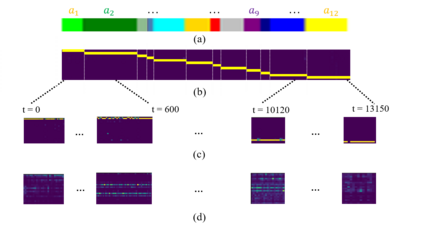

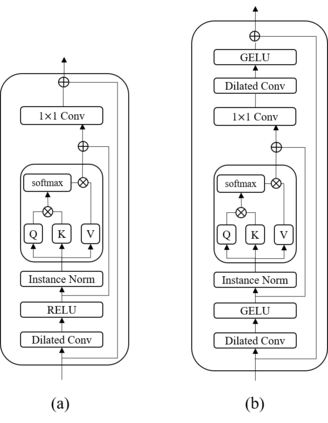

This paper introduces a unified framework for video action segmentation via sequence to sequence (seq2seq) translation in a fully and timestamp supervised setup. In contrast to current state-of-the-art frame-level prediction methods, we view action segmentation as a seq2seq translation task, i.e., mapping a sequence of video frames to a sequence of action segments. Our proposed method involves a series of modifications and auxiliary loss functions on the standard Transformer seq2seq translation model to cope with long input sequences opposed to short output sequences and relatively few videos. We incorporate an auxiliary supervision signal for the encoder via a frame-wise loss and propose a separate alignment decoder for an implicit duration prediction. Finally, we extend our framework to the timestamp supervised setting via our proposed constrained k-medoids algorithm to generate pseudo-segmentations. Our proposed framework performs consistently on both fully and timestamp supervised settings, outperforming or competing state-of-the-art on several datasets.

翻译:本文引入了通过序列序列( seq2seq) 转换视频动作分解的统一框架。 与当前最先进的框架级预测方法相比, 我们将动作分解视为一个后继2seq 翻译任务, 即将视频框架的序列映射到一个动作区段的序列中。 我们的拟议方法涉及标准的变换器后继2seq 翻译模型上的一系列修改和辅助损失功能, 以应对与短输出序列相对的长输入序列和相对较少的视频。 我们通过框架损失为编码器添加了一个辅助监督信号, 为隐含的时间段预测建议一个单独的校正解码器 。 最后, 我们扩展了我们的框架, 通过我们提议的限制 k- medoids 算法监督的时间戳设置生成假拼图 。 我们的拟议框架在完全和时间设置上都运行一致, 在多个数据集上表现优于或相互竞争的状态 。