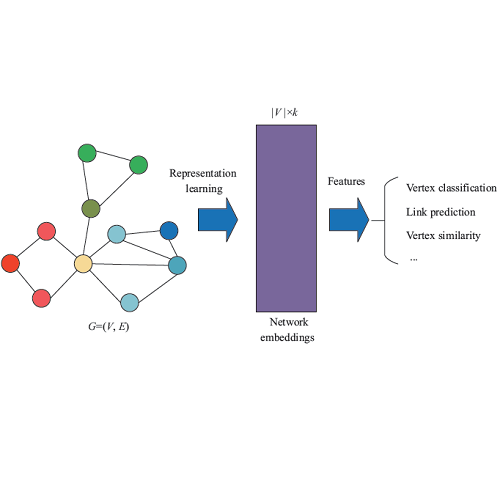

There has been appreciable progress in unsupervised network representation learning (UNRL) approaches over graphs recently with flexible random-walk approaches, new optimization objectives and deep architectures. However, there is no common ground for systematic comparison of embeddings to understand their behavior for different graphs and tasks. In this paper we theoretically group different approaches under a unifying framework and empirically investigate the effectiveness of different network representation methods. In particular, we argue that most of the UNRL approaches either explicitly or implicit model and exploit context information of a node. Consequently, we propose a framework that casts a variety of approaches -- random walk based, matrix factorization and deep learning based -- into a unified context-based optimization function. We systematically group the methods based on their similarities and differences. We study the differences among these methods in detail which we later use to explain their performance differences (on downstream tasks). We conduct a large-scale empirical study considering 9 popular and recent UNRL techniques and 11 real-world datasets with varying structural properties and two common tasks -- node classification and link prediction. We find that there is no single method that is a clear winner and that the choice of a suitable method is dictated by certain properties of the embedding methods, task and structural properties of the underlying graph. In addition we also report the common pitfalls in evaluation of UNRL methods and come up with suggestions for experimental design and interpretation of results.

翻译:在未经监督的网络代表性学习(UNRL)方法方面,最近采用灵活的随机随机方法、新的优化目标和深层结构来对图表采用的方法取得了显著进展。然而,对于系统比较嵌入以了解其不同图表和任务的行为方式的嵌入方法,没有共同的基础。在本文件中,我们理论上在一个统一的框架内将不同方法分组,对不同的网络代表性方法的有效性进行了经验性调查。特别是,我们争辩说,UNRL大多数采用明确或隐含的模式,并利用了一个节点的背景资料。因此,我们提议了一个框架,将各种方法 -- -- 随机步行法、矩阵乘数和深层学习法 -- -- 划入一个统一的基于环境的优化功能。我们系统地根据这些方法的相似性和差异对方法进行分类,我们对这些方法的不同进行详细研究,我们以后用这些方法来解释其业绩差异(在下游任务方面)。我们进行了大规模的经验研究,考虑到9种流行和最近的UNRL技术以及11个具有不同结构特性和两个共同任务的真实世界数据集 -- -- 节点分类和链接预测。我们发现,没有一种单一的方法是未来一个清晰的赢家可选取者,并且将某种结构性图表用于联合国设计方法的基础方法。我们也要求采用某种方法。