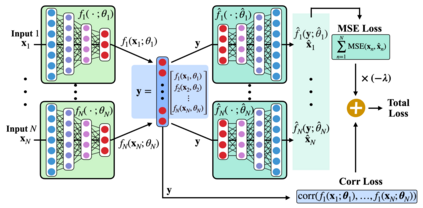

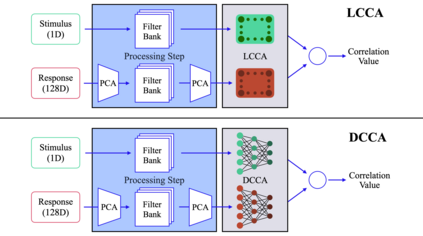

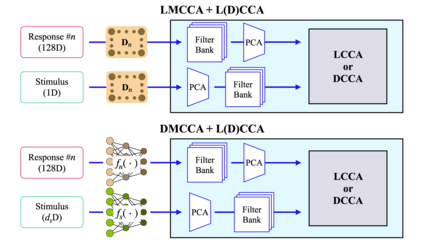

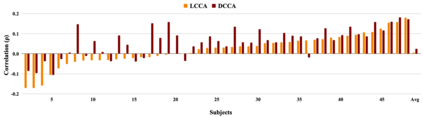

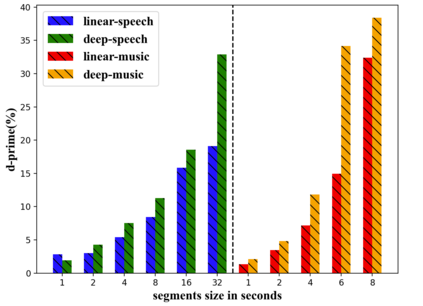

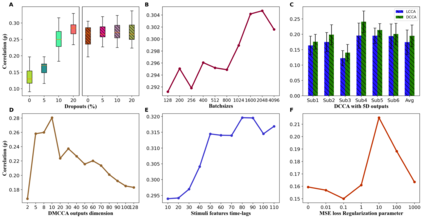

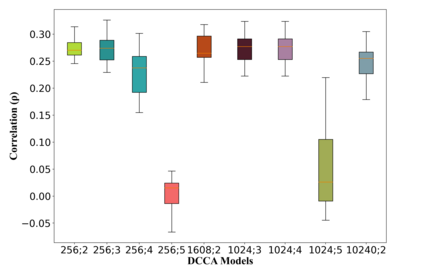

The electroencephalography (EEG), which is one of the easiest modes of recording brain activations in a non-invasive manner, is often distorted due to recording artifacts which adversely impacts the stimulus-response analysis. The most prominent techniques thus far attempt to improve the stimulus-response correlations using linear methods. In this paper, we propose a neural network based correlation analysis framework that significantly improves over the linear methods for auditory stimuli. A deep model is proposed for intra-subject audio-EEG analysis based on directly optimizing the correlation loss. Further, a neural network model with a shared encoder architecture is proposed for improving the inter-subject stimulus response correlations. These models attempt to suppress the EEG artifacts while preserving the components related to the stimulus. Several experiments are performed using EEG recordings from subjects listening to speech and music stimuli. In these experiments, we show that the deep models improve the Pearson correlation significantly over the linear methods (average absolute improvements of 7.4% in speech tasks and 29.3% in music tasks). We also analyze the impact of several model parameters on the stimulus-response correlation.

翻译:电子脑摄影是记录脑活化的最容易的方式之一,由于记录对刺激-反应分析产生不利影响的人工制品,常常被扭曲。迄今为止,最突出的技术试图用线性方法改进刺激-反应的相互关系。在本文中,我们提出了一个基于神经网络的关联分析框架,大大改进了视听模拟线性方法的线性方法。在直接优化相关损失的基础上,为学科间音频-EEG分析提出了一个深层模型。此外,还提议了一个神经网络模型,配有共同的编码器结构,以改善主体间刺激-反应的相互关系。这些模型试图压制EEG人工制品,同时保存与刺激有关的部件。一些实验是在使用听话和音乐刺激主题的 EEG记录进行的。在这些实验中,我们表明深层模型大大改进了皮尔逊与线性方法的关联(平均完全改进7.4%的语音任务和29.3%的音乐任务)。我们还分析了几个模型参数对刺激-反应相互关系的影响。