【泡泡图灵智库】平面匹配:鲁棒RGB-D重建下的共面区块预测

泡泡图灵智库,带你精读机器人顶级会议文章

标题:PlaneMatch: Patch Coplanarity Prediction for Robust RGB-D Reconstruction

作者:Yifei Shi, Kai Xu, Matthias Nießner, Szymon Rusinkiewicz, andThomas Funkhouser

来源:ECCV 2018

播音员:

编译:李鑫

审核:夏友杰

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——平面匹配:鲁棒RGB-D重建下的共面区块预测,该文章发表于ECCV 2018。

本文提出一种新颖的RGB-D块描述子,用于检测SLAM重建中的共面平面。该方法的核心是深度卷积神经网络,其输入是图像中平面区块的RGB、深度和法线信息,并输出可用于其他图像找到共面区块的描述子。作者在1000万个共面和非共面区块的三元组上训练网络,且在商用的RGB-D扫描上创建新的共面基准并进行评估。实验表明,本文方案学习到的描述子比针对这个新任务进行扩展的其他描述子的性能要好很多。此外,还在此具有鲁棒性的RGBD重建框架中证明了共面匹配的好处。同时发现使用本文方法检测到的共面约束足以在大多数场景下获得与当下最先进的框架相当的重建结果,而当结合传统的关键点匹配时,在新建立的基准上则优于其他方法。

主要贡献

1、一项新的任务:为了RGB-D图像配准,预测图像块的共面性。

2、一种自监督的过程,用于训练深度网络以产生用于预测两个图像块是否有共面的特征。

3 、扩展了一种鲁棒优化算法,用于求解具有共面约束的相机姿态。

4 、共面预测的一种新的训练和测试基准。

5 、重建结果表明,共面性可以在基于关键点的方法无法找到回环时用于对齐扫描。

算法流程

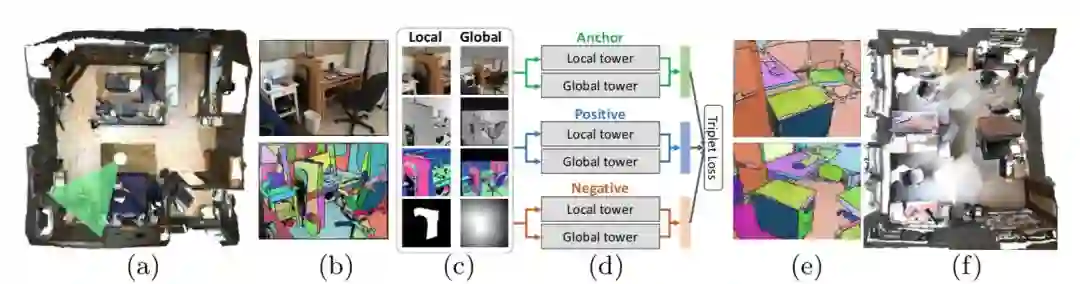

图1 本文方法的概述

本文的方法由两个部分组成:1、深度神经网络训练生成描述子,可以用于发现共面的RGB-D块对而无需初始配准;2、一种充分利用检测到的共面区块对的全局SLAM重建算法。

1、共面性网络

1.1 网络设计

本文的共面网络是由三组平面区块训练而成的,每组都包含一个锚点、一个共面区块(阳性)和一个非共面区块(阴性)。

1.2 训练网络

作者网络的训练数据来源于三维室内场景的RGB-D扫描数据集,数据集提供了高质量的摄像机姿态。对于每个RGB-D帧,使用深度通道上的凝聚聚类将其分割成平面块。对于每个平面区块,我们还根据深度信息估计其法线。这些提取出的区块将被投影到图像空间,以生成网络输入的所有必要通道。针对那些非常小的区块,如果其局部掩码图像包含的具有有效深度像素小于300个,将被丢弃。

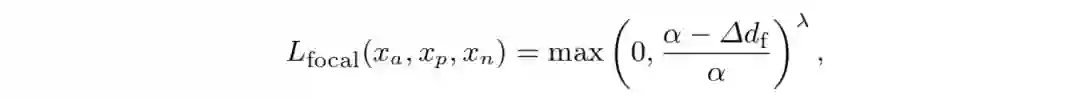

1.3 三元组焦点损失

在准备使用三元组来寻来训练网络时,作者遇到了众所周知的负面和正面区块对数量严重不平衡的问题。最终选择了通过动态地和有区别地针对不同难度的三元组进行调整损失来解决不平衡的问题。具体的三元组焦点损失函数如下:

图2 不同的三元组损失函数的可视化和比较

2 基于共面性的鲁棒重建

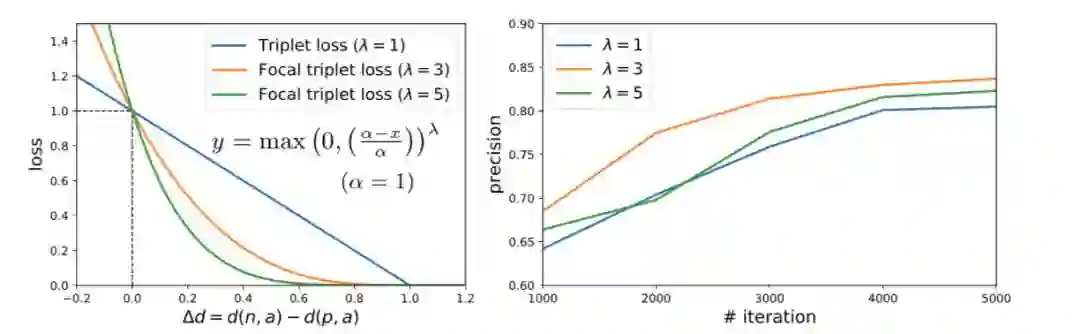

为了研究这种平面区块描述子和共面检测方法在三维重建中的应用,本文开发了一种全局配准算法,利用共面区块匹配和关键点匹配的两两约束估计RGB-D视频中相机姿态。

2.1 目标函数

2.2 优化

对上式进行迭代式的优化,其中每次迭代将变换矩阵T和选择变量s的优化交叉进行。理想情况下,优化可以将序列中的每对帧都作为全局优化的输入。

主要结果

1、 网络评估

据作者所知,本文提出的网络是第一个为共面预测而训练的网络。因此,作者与基线和对照实验进行比较。

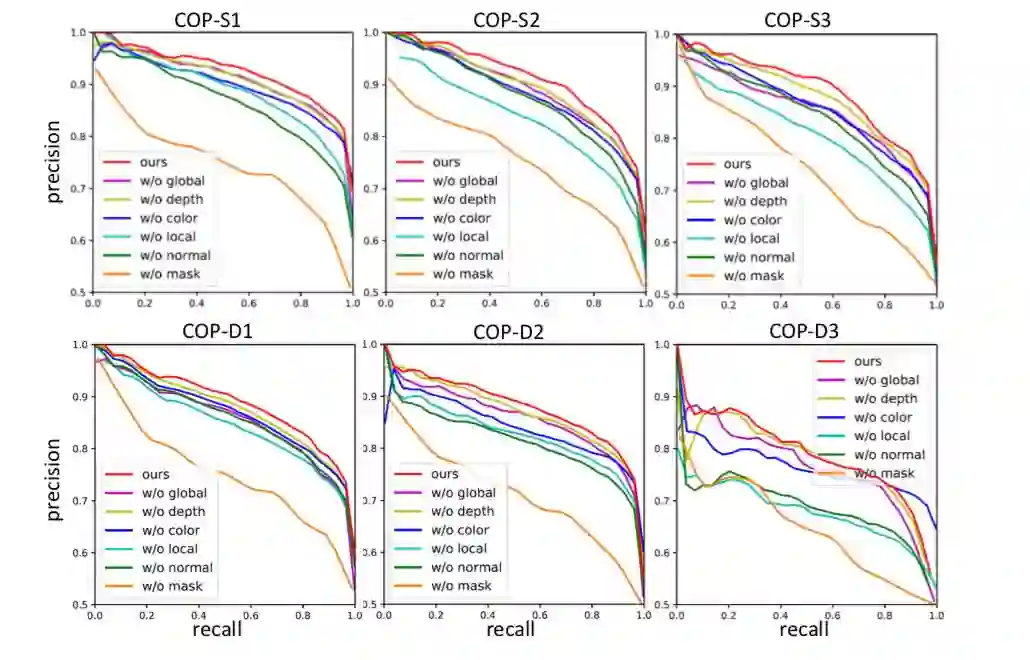

图3 与基线进行对比

图4 共面网络的对照研究

2、重建评估

定量结果: 利用具有相机轨迹真值的TUM RGB-D数据集,对所提出方法的重建结果进行了定量评价。

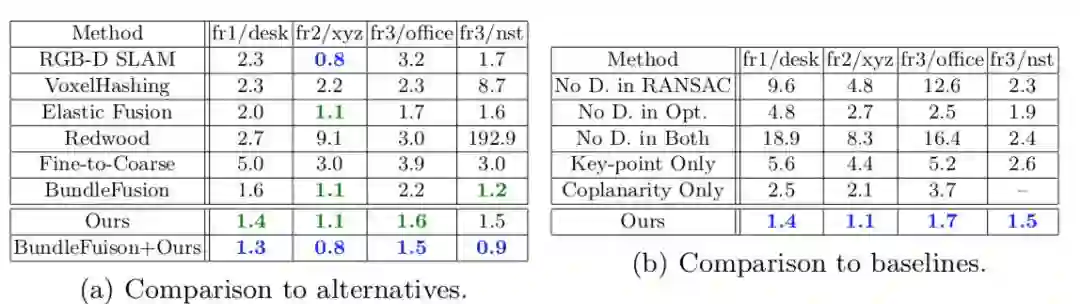

表1 TUM序列上以cm为单位的ATE和RMSE的比较结果

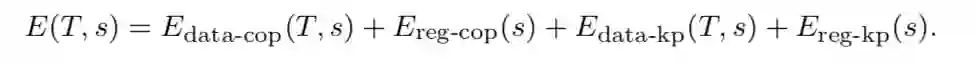

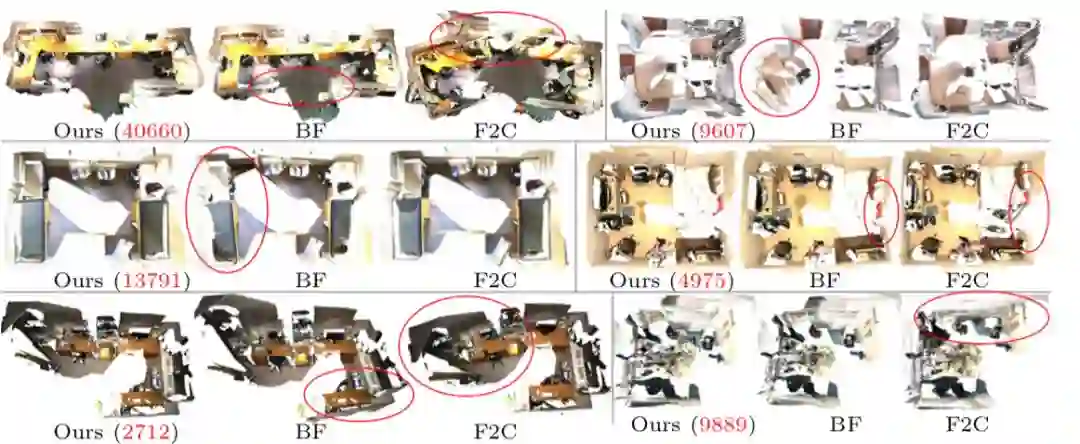

定性结果:图5为ScanNet与作者扫描的新序列重建的可视化比较。本文将该方法的重构结果与目前最先进的基于关键点的方法(BundleFusion)和基于平面结构的方法进行了比较。

图5 本文的方法、BundleFusion(BF)和Fine-to-Coares(F2C)在六个不同的序列上的可视化比较

Abstract

We introduce a novel RGB-D patch descriptor designed fordetecting coplanar surfaces in SLAM reconstruction. The core of ourmethod is a deep convolutional neural network that takes in RGB, depth,and normal information of a planar patch in an image and outputs a descriptor that can be used to find coplanar patches from other images. Wetrain the network on 10 million triplets of coplanar and non-coplanarpatches, and evaluate on a new coplanarity benchmark created fromcommodity RGB-D scans. Experiments show that our learned descriptor outperforms alternatives extended for this new task by a significantmargin. In addition, we demonstrate the benefits of coplanarity matchingin a robust RGBD reconstruction formulation. We find that coplanarityconstraints detected with our method are sufficient to get reconstructionresults comparable to state-of-the-art frameworks on most scenes, butoutperform other methods on established benchmarks when combinedwith traditional keypoint matching.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com