【泡泡图灵智库】使用深度特征重建的单目深度估计和视觉里程计的无监督学习方法(CVPR)

标题:Unsupervised Learning of Monocular Depth Estimation and Visual Odometry with Deep Feature Reconstruction

作者:Huangying Zhan , Ravi Garg, Chamara Saroj Weerasekera, Kejie Li , Harsh Agarwal, Ian Reid

来源: CVPR 2018

编译:肖勇

审核:李伟

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——使用深度特征重建的单目深度估计和视觉里程计的无监督学习方法,该文章发表在CVPR2018。

本文探索使用双目序列学习深度和视觉里程计。使用双目序列可以利用空间(左右图片对)和时间(前后图片对)光测误差并且能将场景深度和相机运动控制在绝对尺度。测试时,该方法也可以从单目序列估计单视图深度和双视图里程。该方法也展示了可以使用深度特征提高传统的光学变形(warping)误差损失函数。通过大量实验证明了(1)由于使用了深度联合训练单目深度估计和视觉里程计能提高深度估计的效果;(2)基于深度特征的图像变形损失函数相比于简单的光学变形误差函数可以提高单视图深度估计和里程计效果。源代码在https://github.com/Huangying-Zhan/Depth-VO-Feat

主要贡献

1、提出一个联合学习深度估计和视觉里程计的框架,能够解决尺度模糊性;

2、利用空间和时间序列图片的约束提高单视图的深度估计;

3、在基于颜色的图片重建损失函数的基础上提出的特征构建损失函数极大地提高深度估计和里程计的精度。

算法流程

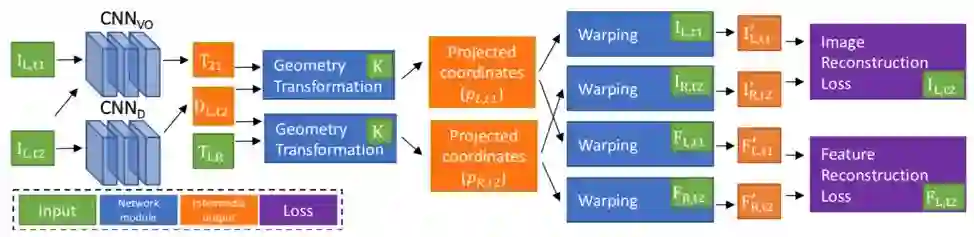

图 1 算法训练框架

算法训练的框架如图1所示。要是同时训练学习单视图深度估计网CNN_D和视觉里程计CNN_VO.

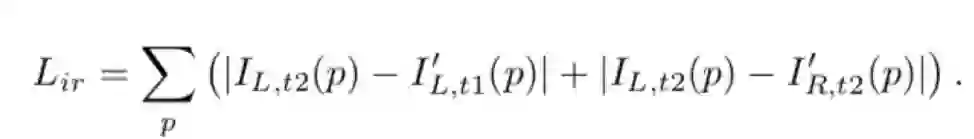

1、监督图片重建

网络使用双目图片作为训练样本,其中包含时间图片对和双目图片对。本文通过两个综合函数f(.)变换得到参考试图。综合函数f(.) 融合了两个可以偏微分的操作(对极几何变换和图像变形)以方便ConvNet训练时的反向传播。变换图片重建的损失函数作为训练CNN_D和CNN_VO的损失函数:

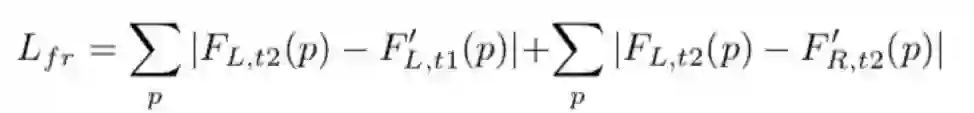

2、监督特征重建

上述方法假设场景是朗伯体,即亮度不会因为视角变换而变化,为提高方法的鲁棒性,加入了利用深度特征的重建损失函数作为另外一个监督信号。 使用和上述方法类似的综合过程,可以得到和,然后构建如下损失函数:

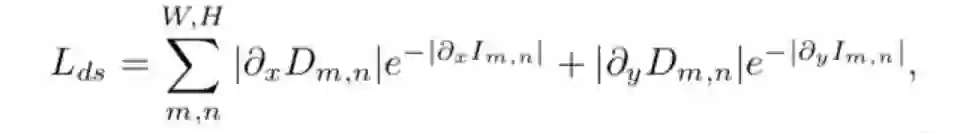

3 、训练损失函数

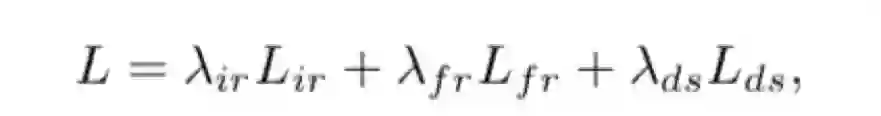

为了保证平滑的深度估计,本文也引入了深度平滑性损失函数L_ds,因此得到最终的损失函数L:

4、 网络结构

深度估计网络含有encoder和decoder,其中encoder使用了计算更快的ResNet50-1by2,decoder首先使用1x1的核函数将1024维的特征转为为单通道特征图,然后使用传统的双线性上采样核函数;预测层之后使用了ReLU。

视觉里程计使用融合的两张彩色试图作为输入,输出6个自由度的变换矩阵。其网络包含6个stride-2的卷积层和3个全卷积网络。

主要结果

本文实验主要使用KITTI数据集训练以比较单视图深度估计和里程估计。

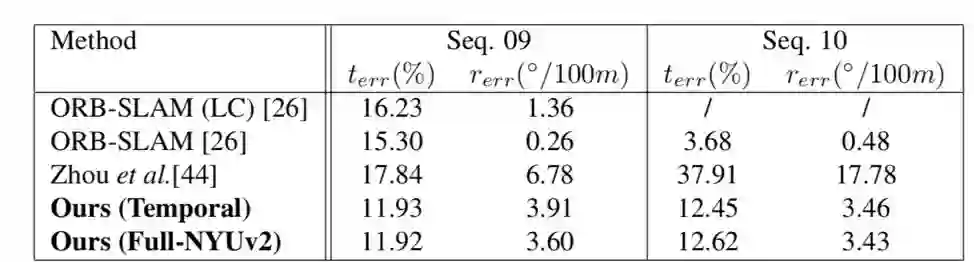

1、 视觉里程计结果

表1 列出了视觉里程计的结果,可以看到基于双目学习的里程计比单目的方法效果好,且不需要额外修改平移的尺度。实验也证明,当平移量小时,该方法效果优于ORB-SLAM.

表 1 视觉里程计在KITTI 里程数据09和10序列的结果

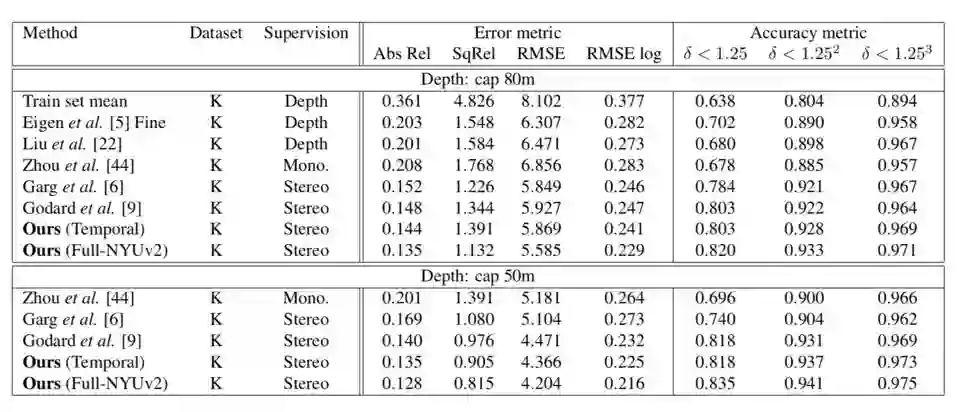

2、单目深度估计

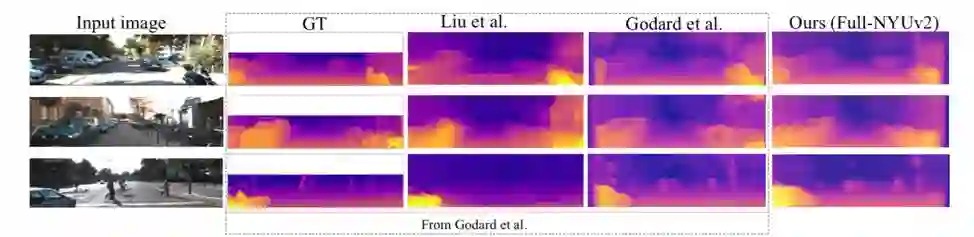

表2显示了深度估计的结果评价。图2展示了深度估计的一些结果。实验结果表明使用双目训练结果比使用单目的好。由于使用深度特征损失函数以及里程计网络中的图像变形,该方法可以得到合理的边缘。

表 2 单视图深度估计结果对比

图 2 单视图深度估计的一些例子

Abstract

Despite learning based methods showing promising re-sults in single view depth estimation and visual odometry,most existing approaches treat the tasks in a supervisedmanner. Recent approaches to single view depth estima-tion explore the possibility of learning without full super-vision via minimizing photometric error. In this paper, weexplore the use of stereo sequences for learning depth andvisual odometry. The use of stereo sequences enables theuse of both spatial (between left-right pairs) and temporal(forward backward) photometric warp error, and constrainsthe scene depth and camera motion to be in a common, real-world scale. At test time our framework is able to estimatesingle view depth and two-view odometry from a monocu-lar sequence. We also show how we can improve on a stan-dard photometric warp loss by considering a warp of deepfeatures. We show through extensive experiments that: (i)jointly training for single view depth and visual odometryimproves depth prediction because of the additional con-straint imposed on depths and achieves competitive resultsfor visual odometry; (ii) deep feature-based warping lossimproves upon simple photometric warp loss for both sin-gle view depth estimation and visual odometry. Our methodoutperforms existing learning based methods on the KITTIdriving dataset in both tasks. The source code is avail-able at https://github.com/Huangying-Zhan/Depth-VO-Feat.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com