关系图注意力网络-Relational Graph Attention Networks

关系图卷积网络(RGCNs)是GCNS对关系图域的一种扩展。本文以RGCN为出发点,研究了一类关系图注意力网络(RGATs)模型,将关注机制扩展到关系图域。

作者 | Dan Busbridge, Dane Sherburn, Pietro Cavallo & Nils Y. Hammerla

编译 | Xiaowen

【论文便捷下载】

请关注专知公众号(点击上方蓝色专知关注)

后台回复“RGAT”就可以获取《关系图注意力网络》的论文PDF下载链接~

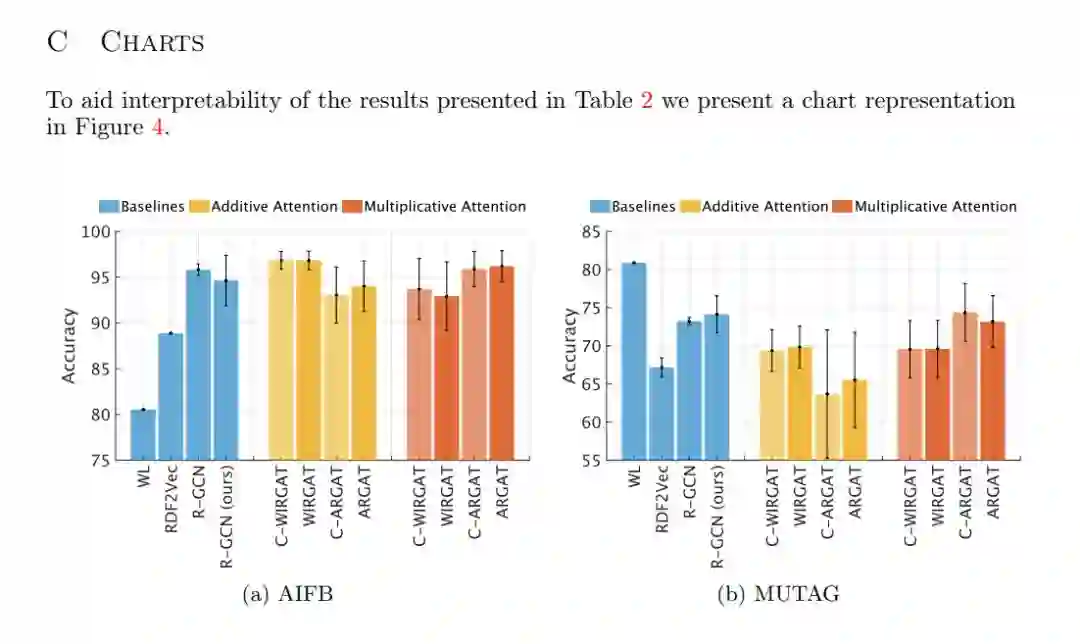

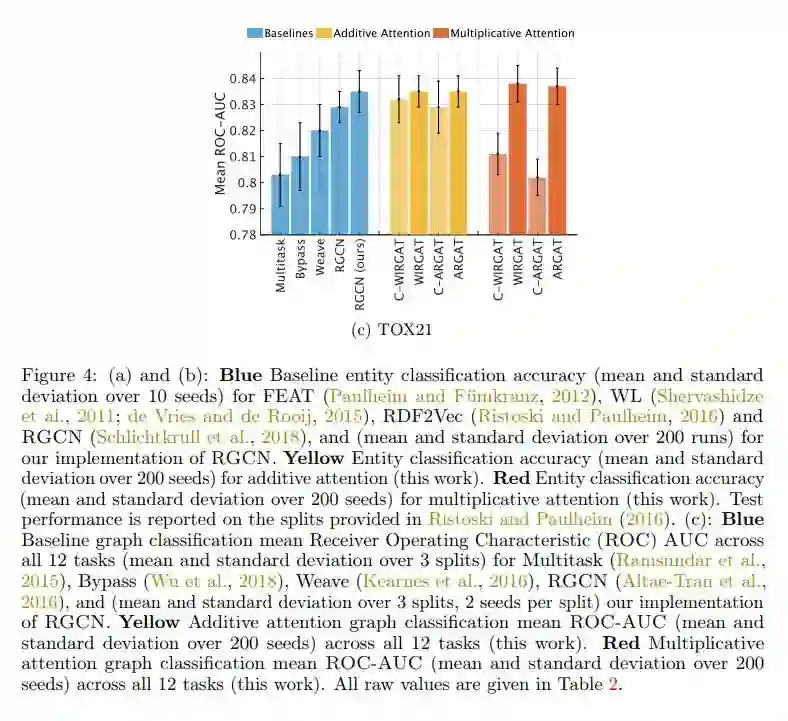

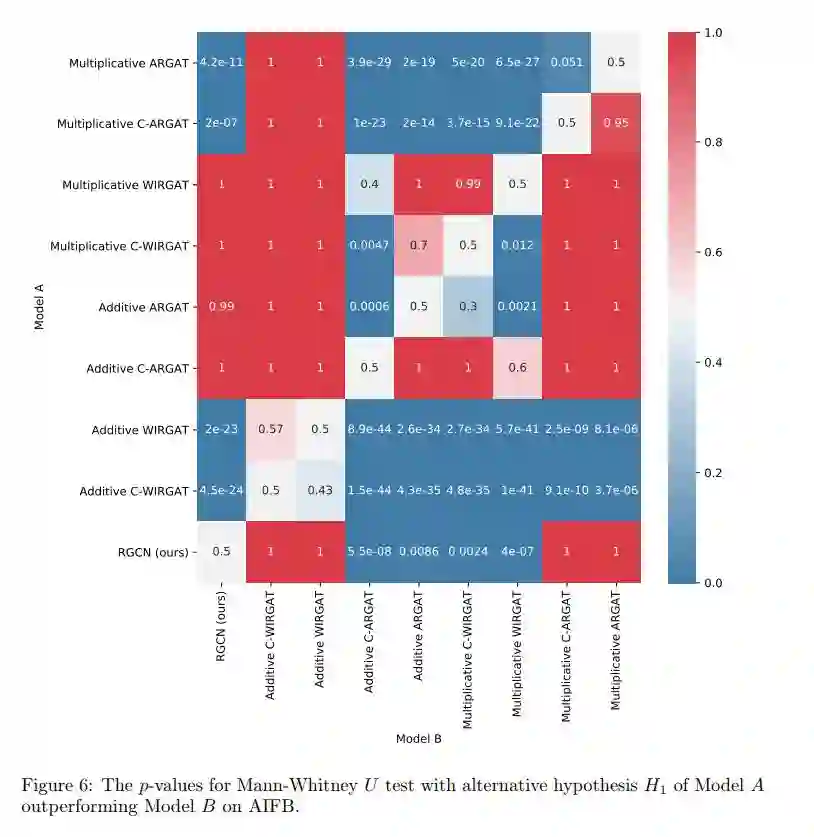

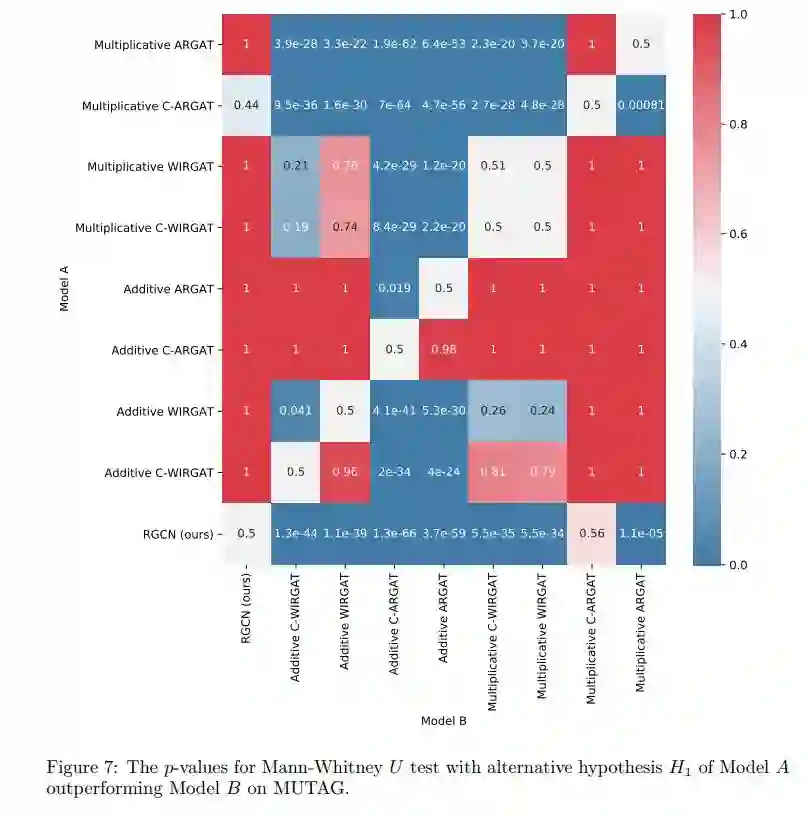

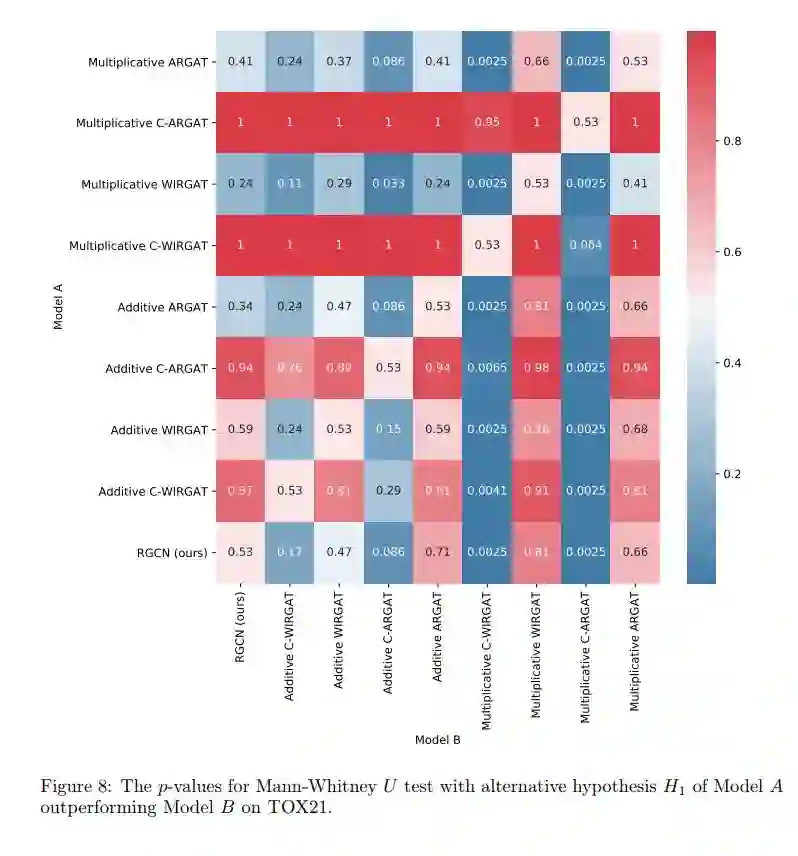

我们研究了关系图注意力网络,这类模型扩展了非关系图的注意力机制以合并关系信息,从而为更广泛的问题开辟了一些方法。我们对这些模型进行了彻底的评估,并与既定的基准进行了比较。为了提供一个有意义的比较,我们重新训练了关系图卷积网络(Relational Graph Convolutional Networks),即关系图注意力网络的谱对应体(spectral counterpart of Relational Graph Attention Networks),并在相同的条件下对它们进行了评价。我们发现关系图注意力网络的性能比预期差,尽管一些配置对模拟分子特性有一定的帮助。我们对此提出了见解,并建议对评价战略的修改,以及今后工作的研究方向。

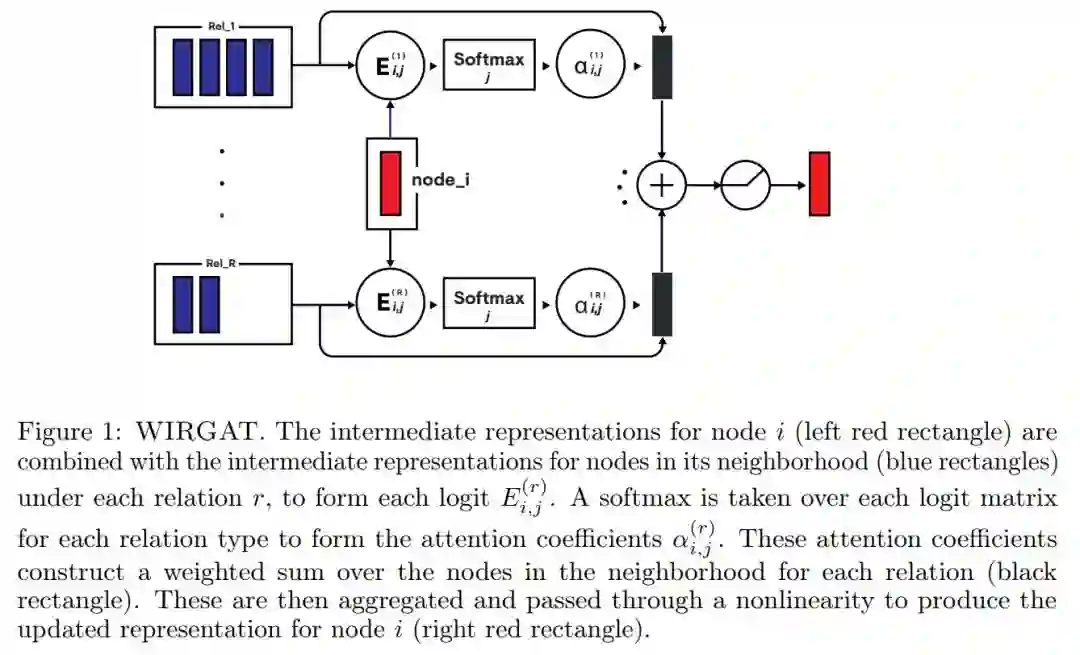

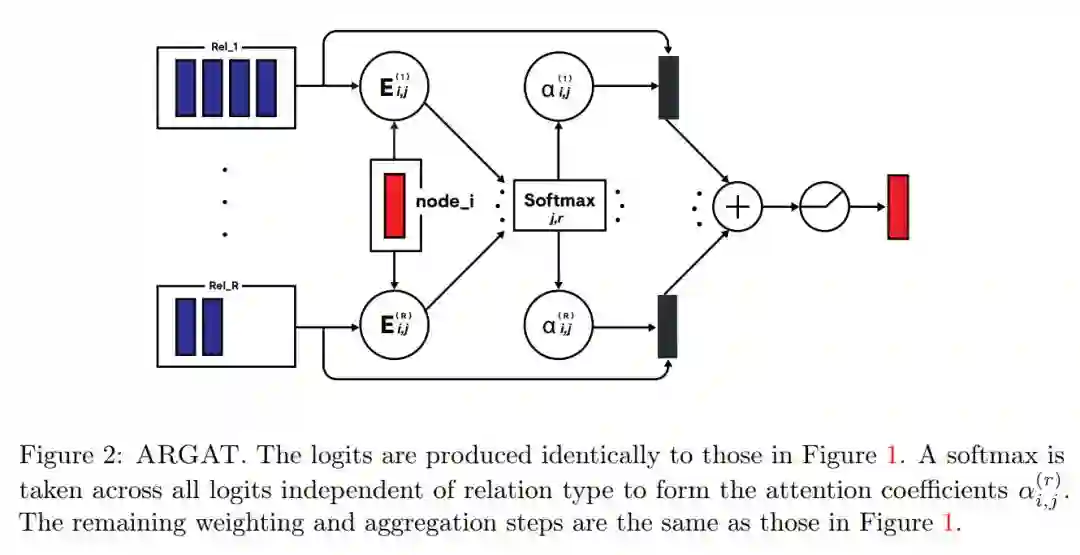

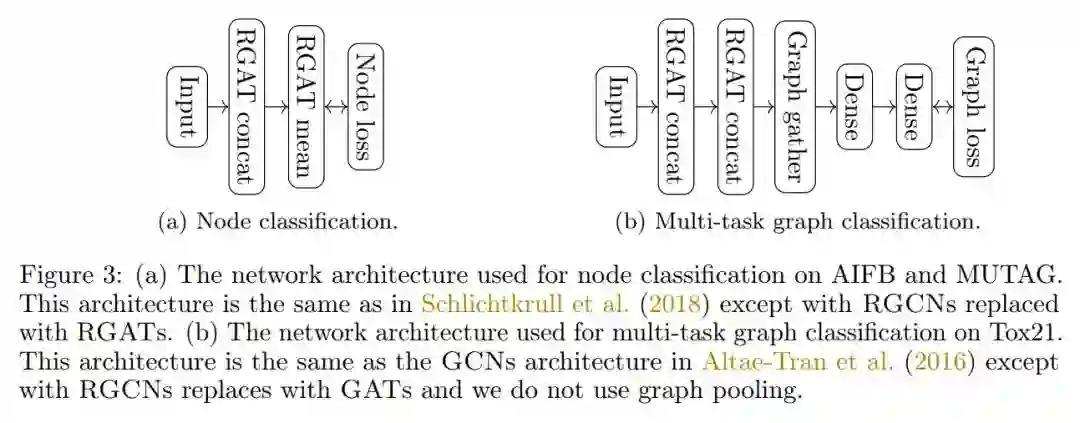

本文以RGCN为出发点,研究了一类关系图注意力网络(RGATs)模型,将关注机制扩展到关系图域。我们考虑两个变体,内部关系图注意力(WIRGAT)和跨关系图注意力(ARGAT),每个变量都具有加性和乘性注意力。我们进行了广泛的超参数搜索,并对具有挑战性的传感器节点分类和归纳图分类任务进行了评估。将这些模型与已建立的基准以及重新调整的RGCN模型进行比较。

内部关系图注意力(WIRGAT)结构图

跨关系图注意力(ARGAT)

结点分类任务

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!530+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程