题目: Heterogeneous Graph Attention Network

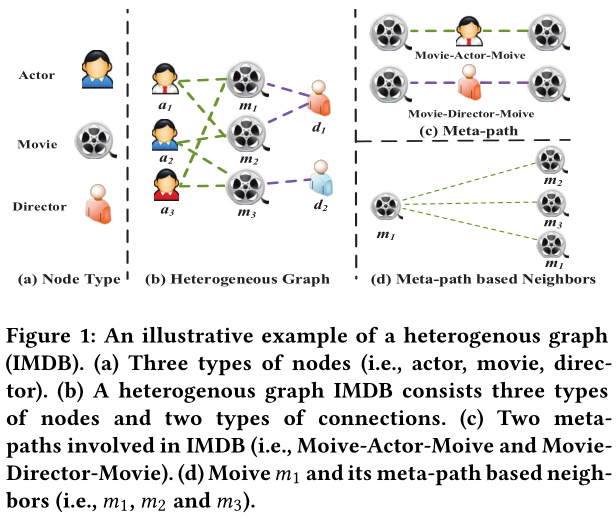

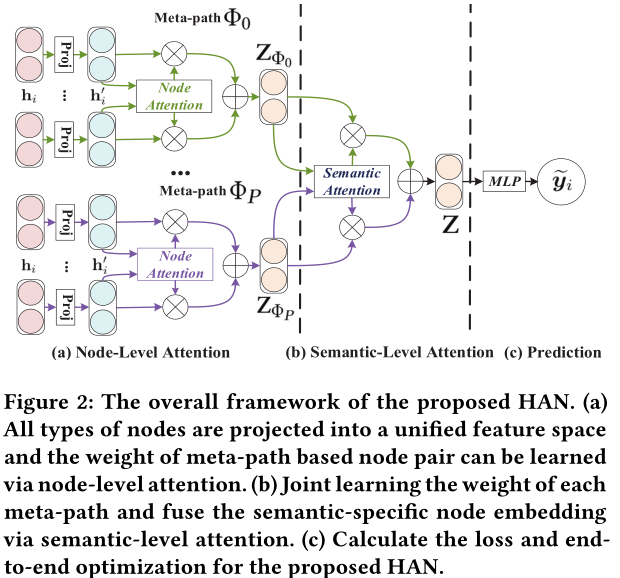

摘要: 图神经网络作为一种基于深度学习的功能强大的图表示技术,表现出了优越的性能,引起了广泛的研究兴趣。然而,对于包含不同节点和链接类型的异构图,图神经网络还没有充分考虑到这一点。异构性和丰富的语义信息给异构图的图神经网络设计带来了很大的挑战。最近,深度学习领域最令人兴奋的进展之一是注意力机制,其巨大的潜力在各个领域都得到了很好的展示。本文首先提出了一种基于分层关注的异构图神经网络,包括节点级关注和语义级关注。具体来说,节点级注意的目的是学习节点与其基于元路径的邻居之间的重要性,而语义级注意能够学习不同元路径之间的重要性。通过对节点级和语义级注意的学习,可以充分考虑节点和元路径的重要性。然后将基于元路径的邻域的特征分层聚合,生成节点嵌入。在三个真实世界的异构图上的广泛实验结果不仅显示了我们所提出的模型的优越性能,而且也显示了它对图分析的潜在良好的可解释性。

成为VIP会员查看完整内容

相关内容

专知会员服务

63+阅读 · 2020年7月12日

专知会员服务

60+阅读 · 2020年6月28日

专知会员服务

101+阅读 · 2020年6月28日

专知会员服务

66+阅读 · 2020年4月17日

Arxiv

44+阅读 · 2020年2月5日

Arxiv

6+阅读 · 2018年3月24日