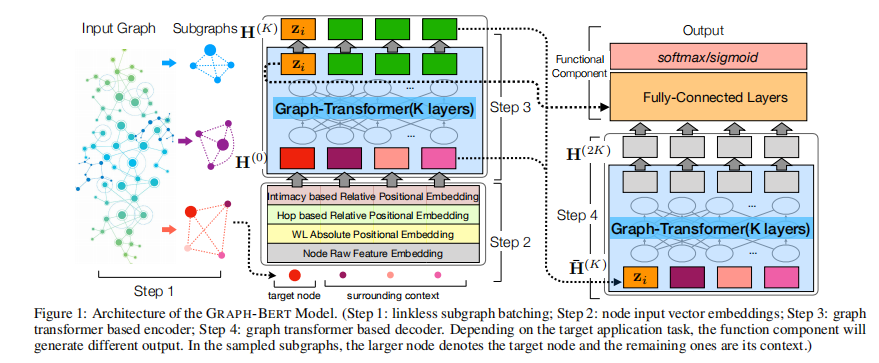

简介: 主导图神经网络(GNN)完全依赖图连接,已经存在几个严重的性能问题,例如,过度平滑问题。此外,由于内存限制了节点之间的批处理,因此固定连接的特性会阻止图形内的并行化,这对于大型数据输入至关重要。在本文中,引入一种新的图神经网络,即GRAPH-BERT(基于图的BERT),该网络仅基于注意力机制而无需任何图卷积或聚合算法。本文在局部上下文中使用采样的无连接子图训练GRAPH-BERT。此外,如果有任何监督的标签信息或某些面向应用的目标,则可以使用其他最新的输出层对预训练的GRAPH-BERT模型进行微调。我们已经在多个基准图数据集上测试了GRAPH-BERT的有效性。在预训练的GRAPH-BERT具有节点属性重构和结构恢复任务的基础上,我们进一步针对节点分类和图聚类任务进一步调整GRAPH-BERT。

成为VIP会员查看完整内容

相关内容

芝加哥大学(TheUniversity of Chicago)位于美国伊利诺伊州芝加哥,是美国最富盛名的大学之一。芝加哥大学从建校起,便以宏观教育理念与微观实验精神奠定了她在美国教育史上的重要地位。同时,该校对于学术研究的贡献也使其拥有极高的声誉。

专知会员服务

78+阅读 · 2020年5月31日

专知会员服务

51+阅读 · 2020年2月22日

专知会员服务

115+阅读 · 2020年1月3日

Arxiv

5+阅读 · 2019年9月26日